来源:36氪

编者按:尽管人工智能的热度一直不减,但很多人对人工智能投资回报率的质疑却日益增加。人工智能需要消耗的算力和电力极大,但带来的回报却不在一个级别上。本文将对人工智能价值链的收入来源进行量化分析,帮助大家了解目前人工智能的市场现状。文章来自编译。

鉴于最近大家对人工智能投资回报率(ROI)的怀疑日益增加,再加上对“人工智能泡沫”破裂的担忧,我想对迄今为止人工智能价值链的收入来源做一番量化分析。我的目标是让大家了解一下收入情况的全貌,并点评一下人工智能的主要市场。文章分为以下几个部分:

- 人工智能ROI之争

- 人工智能市场现状总结

- 半导体市场

- 数据中心市场

- 云市场

- 人工智能应用

1. 人工智能ROI之争

一年半以来,公众舆论首次出现转向,态度变成了“超大规模数据中心的支出太疯狂了。人工智能是泡沫。”我不想人云亦云,投资就是寻找被低估的机会;越悲观越好。

我们不应该对人工智能的相关悲观情绪日益增加感到惊讶。基础设施建设与应用价值有落差应该在意料之中。所有的大型基础设施建设都没法做到完美契合需求。没关系。从基础设施建设过渡到价值创造不会是完美过程。

从某种程度来说,近期人工智能悲观情绪的上升是源自最新的超大规模资本支出数据。

过去这四个季度,亚马逊、谷歌、微软以及 Meta 的资本支出总计达到了 1770 亿美元。从 2023 年第二季度到 2024 年第二季度,该数字平均增长了 59%。数字令人瞠目结舌,但有两点可能是真的:

目前,人工智能投资的ROI尚不明确。

超大规模企业做出资本支出业务决策是对的。

我们需要区分一下人工智能投资的ROI以及超大规模人工智能支出的ROI。人工智能的ROI最终要由应用对最终用户的价值决定。企业决定开发人工智能应用时,依据是收入或成本替代的潜力。

对于大型云服务提供商来说,情况则有所不同。

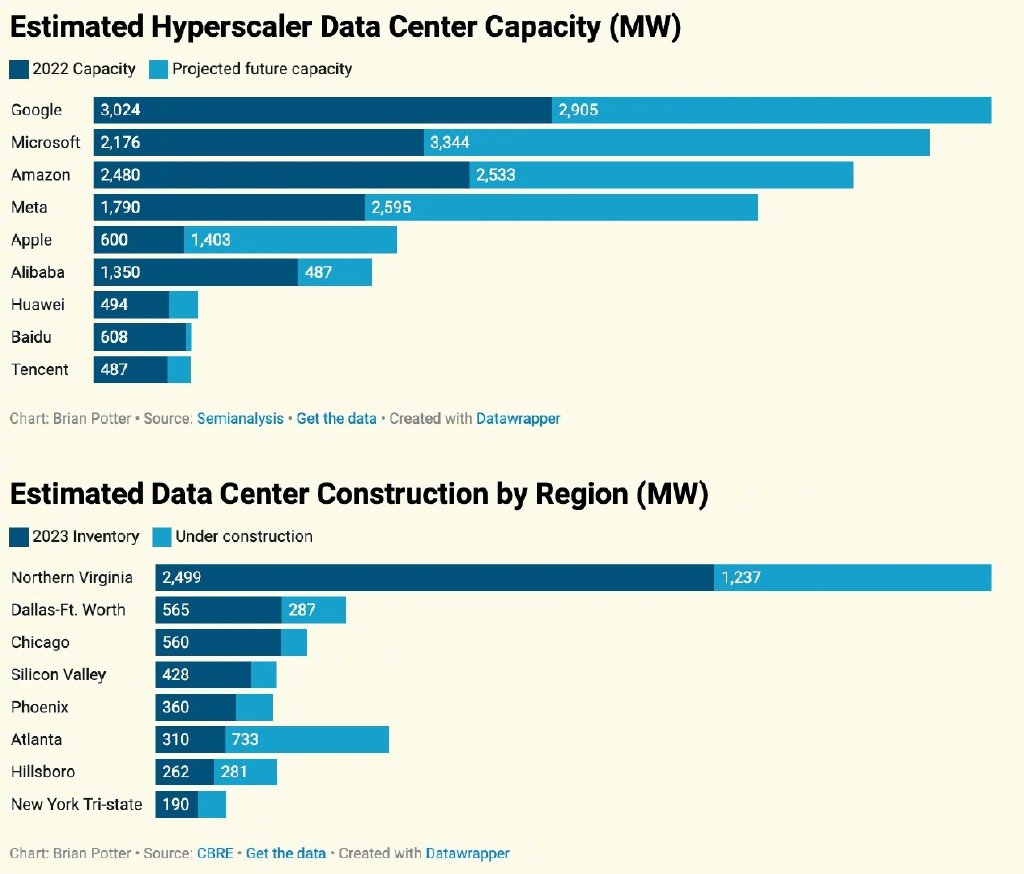

约 50% 的支出用于数据中心“套件”,如 GPU、存储和网络。到目前为止,这一直属于需求驱动型支出!所有三家超大规模企业都指出,他们在 AI 计算能力方面受到了容量限制。

其余50%的大部分用于确保未来15年内仍将稀缺的自然资源:房地产以及电力。

他们会自己或通过 QTS、Vantage 或 CyrusOne 等开发商来做这件事。他们购买靠近边缘的、电力充足且价格低廉的数据中心房地产。他们已经拿到了数据中心大部分的黄金地段;现在,他们主要是根据电力可用性来选地点。电力会继续成为计算需求的瓶颈,超大规模企业了解这一点。

超大规模企业的方程式相对简单:数据中心至少需要 15 年的投资。他们押注 15 年后计算需求会更高(这个假设并不疯狂)。

如果他们不能确保这些自然资源的安全,可能会发生三件事:

他们的业务会输给有能力的竞争对手。

他们会被迫拿性价比较差的次优土地。

挑战者会买下这些土地与电能,并蚕食超大规模企业的份额。

如果他们拿到了想要的土地,且不需要马上获得计算能力,则可以等到需求准备好后再在数据中心内建造“套件”。他们可能提前几年支出了数百亿美元,这并非理想情况。不过,三大云提供商的年收入有 2250 亿美元。

就像谷歌首席执行官桑达尔所说那样:“投资不足的风险高过投资过度。”

到目前为止,我们已经开始看到人工智能基础设施的建设了,主要是买 GPU ,以及数据中心的建设成本,我们的疑问是:“迄今为止在什么地方创造了价值,未来又将在什么地方创造出价值?”

2. 人工智能市场现状总结

目前,人工智能的价值大部分都集中在基础设施层面,尤其是英伟达及其相关公司。我们开始看到“人工智能数据中心”的建设,但我目前还处在这一趋势的早期阶段,而能源是这种建设的真正瓶颈。

云提供商通过模型 API 或“GPU 即服务”获得了部分收入,也即是买下 GPU 并通过云服务出租出去。

我们还没有看到大规模的应用收入。人工智能应用已经创造出约 200 亿美元的收入,到目前为止,其创造的价值(成本降低)要比这个数字高出几倍,但与基础设施成本相比微不足道。

行业最终将由人工智能应用价值(收入或成本替代)驱动。这种价值会受到消费者或企业的最终价值驱动。

所以可以得出这样的结论:人工智能应用解决的问题越大,整个价值链积累下来的价值就越大。

现在对基础设施的投资巨大,期望能从应用获得收入。问题是:人工智能在什么地方创造出了重要价值呢?

答案是,目前还不清楚。现在还为时尚早。但这没关系。

在深入探讨之前,我想先简要介绍一下我看法的理论框架(简化版)。

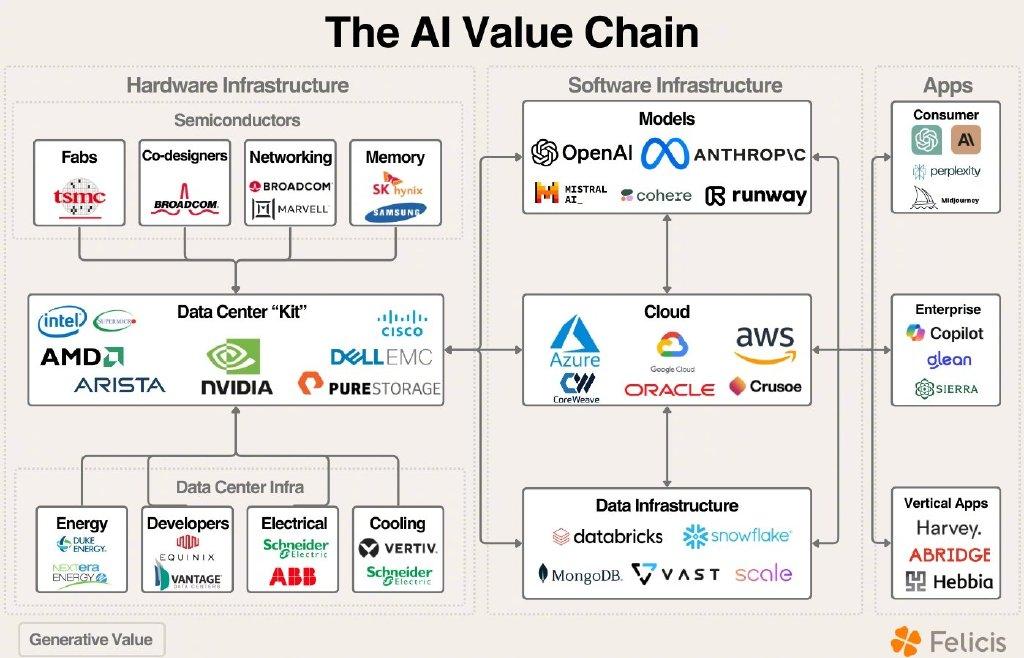

广义上,涉及的市场可分为半导体(及其价值链)、数据中心(及能源)、云平台、模型、数据与应用层。

3. 人工智能与半导体市场

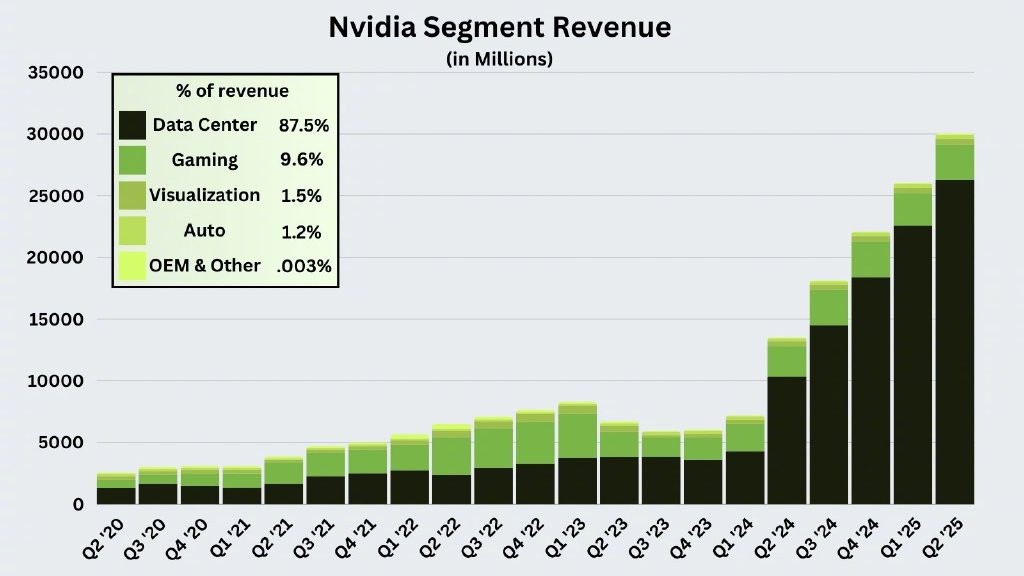

摘要:英伟达一家就占据了人工智能半导体收入的大部分市场份额,英伟达的供应链从中受益匪浅,HBM 内存与定制 ASIC 就是其中两类。

英伟达、英伟达的供应链及 AMD

上个季度,英伟达在数据中心板块的收入为 263 亿美元,其中 37 亿美元来自网络。回顾一下之前的资本支出数字,有 45% 的收入(即 118 亿美元)来自云提供商。

为英伟达生产尖端芯片的半导体代工厂台积电是最直接的受益者,其评论道:

我们预测,今年几款 AI 处理器的收入贡献率会增加一倍以上,到 2024 年将占我们总收入的百分之十几。未来五年,我们预测将以 50% 的复合年增长率增长,到 2028 年将占我们收入的 20% 以上。按照狭义定义,这几款 AI 处理器包括 GPU、AI 加速器以及 CPU 的执行、训练与推理功能,不包括网络边缘AI或板载 AI。

台积电 2024 年的收入预测均值为 863 亿美元;其中估计有 12% 来自人工智能,故预计人工智能收入约为 104 亿美元。

台积电的资本支出会跟着收入增长而增长,从而为半导体资本设备提供商创造收入。

那 AMD 呢?

在上一季度的收益报告中,苏姿丰预计 MI300X 的收入将超过 45 亿美元,高于之前预期的 40 亿美元。但最重要的一点是在之前的收益电话会议上她点评道:

“从全年角度来看,我们 40 亿美元的数字不受供应上限限制。”

当你最大的竞争对手的 GPU 销售额约为 200 亿美元,而且销量不足时,这种情况就不算理想了。话虽如此,开发芯片生产线需要时间,从发布芯片到一年内收入超过 40 亿美元的成就以及令人印象深刻。

HBM、Broadcom 与Marvell

高带宽内存芯片是为了减少 AI 工作负载的内存瓶颈;SK 海力士、三星以及美光是这类芯片的其中三家制造商。

Trendforce 称,“总体而言,SK 海力士目前占据了 HBM 市场约 50% 的份额,过去几年,该公司与三星基本瓜分了这一市场。考虑到这种份额情况,加上 DRAM 行业收入预计将在 2024 年增至 841.5 亿美元,如果 TrendForce 的估计准确,SK 海力士在 2024 年的 HBM 收入可能高达 84.5 亿美元。”

此外,Marvell 与 Broadcom 还提供两款主要的 AI 产品:

数据中心大多数网络设备的半导体(供应给 Arista 和 Cisco 等客户)。

共同设计合作伙伴关系帮助企业开发定制的 AI 芯片(最好的例子是博通与谷歌合作开发 TPU)。

博通:“本季度,我们的 AI 产品收入达到创纪录的 31 亿美元”,这得益于与谷歌合作生产 TPU以及网络半导体。上个季度,他们披露收入约 2/3 来自 TPU,1/3 来自网络。

Marvell:“我们今年设定的目标是 15 亿美元,明年的目标是 25 亿美元……我能告诉你的是,这两个目标都已经扩大了。”

半导体板块总结,我们预计英伟达在AI方面的年收入为 1050 亿美元,博通的年收入为 124 亿美元,AMD 2024年 AI 收入预计为 45 亿美元,台积电在 AI 的收入预计为 104 亿美元,内存供应商的 HBM 收入约为 160 亿美元(SK 海力士 的市场份额约为 46-52%,三星的市场份额约为 40-45%,美光的市场份额约为 4-6%),而 Marvell 的 AI 收入可能在 20 亿美元左右。

4. 人工智能数据中心市场

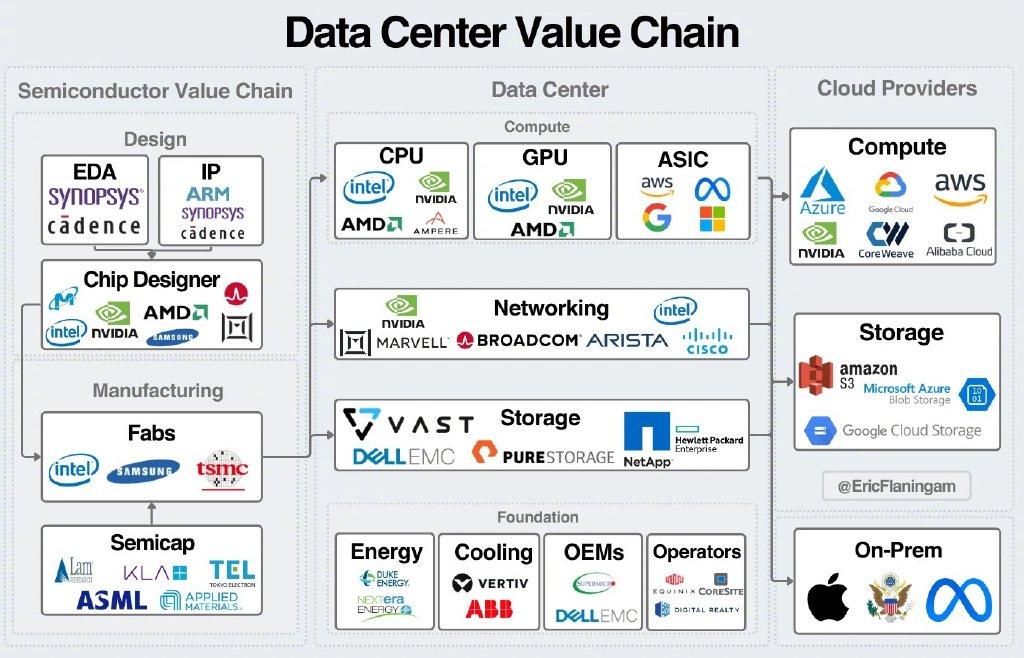

AI 数据中心的故事很有趣。我们看到收入流向了两个地方:GPU/AI 加速器以及数据中心建设。我们还没有看到收入流向 Arista、Pure Storage 或 NetApp 等传统数据中心设备提供商。

数据中心子支出情况

数据中心建设最直接的驱动因素是超大规模资本支出。亚马逊、谷歌、微软与 Meta 在过去四个季度的资本支出总计达 1770 亿美元。平均而言,从 2023 年第二季度到 2024 年第二季度,该数字增长了 59%。

其中约50%直接用于房地产、租赁和建筑成本。

Synergy Research 指出,超大规模数据中心的总规模仅用了四年时间就翻了一番,而且未来四年这一规模还会再次翻番。

我们还看到数据中心在规模上出现了一些分化。虽然核心数据中心规模越来越大,但为了将基础设施推向更靠近客户的地方,部署的(规模相对较小的)数据中心数量也在增加。综合来看,各条主要的增长趋势线都在急剧上升,向右发展。

显然,数据中心正在如火如荼地建设中,但谁能从中受益呢?

从理论上讲,价值应该流经传统的数据中心价值链:

这些数据的有趣分歧在于,我们还没看到收入流向传统的数据中心网络与存储提供商……目前为止如此。这意味着迄今为止的收入主要流向了机架级的实施和数据中心建设上。

Vantage、QTS 和 CyrusOne 等数据中心开发商购买土地和电力,然后将其出租给科技巨头。然后,开发商将完成数据中心的建设过程,然后再将设备投入使用。

到目前为止,其他主要受益者包括戴尔与 SMCI 等服务器制造商,这些制造商提供了搭载 Nvidia GPU 的机架。戴尔上季度销售了价值 32 亿美元的 AI 服务器,环比增长 23%。SMCI 上季度的收入为 53 亿美元,同比增长了 143%。

那电力呢?

显然,能源价值链将会创造价值,需求在增加,问题是哪些瓶颈将得到缓解来满足这种需求呢(我现在还没有很好的答案)。

下面这个故事凸显了能源需求的重要性:

美国最大的电网运营商 PJM Interconnection 于 2024 年 7 月 22 日当周举行了一年一度的电力拍卖。PJM 为全球最大的数据中心枢纽所在地北弗吉尼亚地区提供服务。拍卖价最终定为 269.93 美元/兆瓦/天(大部分地区),高于上次拍卖的 28.92 美元/兆瓦/天。

明年价格大概要比今年涨 10 倍。这凸显出超大规模企业对能源的担忧,以及他们为确保电能而愿意发挥的创造力。

5. 人工智能云市场

三家超大规模企业都希望成为垂直整合的 AI 提供商,让客户能够利用任何服务层(基础设施、平台、应用)。这正好也是他们用传统云软件部署的玩法。

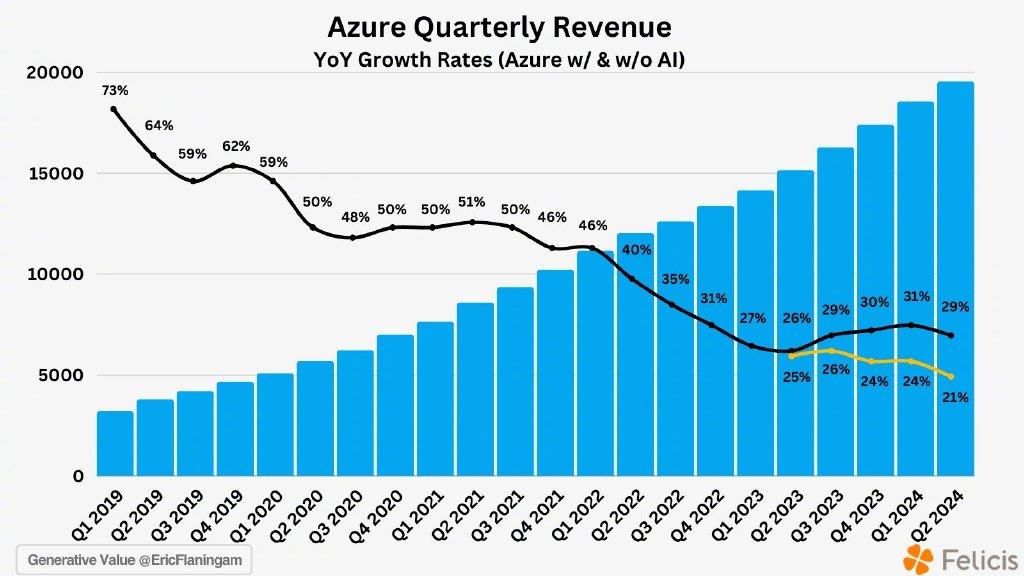

微软的表现无疑是迄今为止最好的一个,让我们对云 AI 收入有了一个很好的了解。我们可以根据贡献率粗估一下Azure AI 收入。将其与 Azure 净新收入相结合,我们就可以了解他们每季度新增了多少 AI 收入:

上个季度,他们的 Azure AI 年收入达到了约 50 亿美元。

谷歌和亚马逊均指出,他们的人工智能业务年收入达“数十亿美元”,但并未透露更多细节。

Oracle 已经签署了价值 170 亿美元的 AI 计算合同,如果我们将其平均分为 12 个季度,Oracle 每季度的 AI 收入将达到约 13 亿美元,这与其他超大规模企业处于同一水平。

再加入 GPU 云数据来完善 AI 收入的整体情况:

Coreweave 2023 年的收入预计为 5 亿美元,2024 年的合同收入为 20 亿美元。Lambda Labs 2023 年的收入预计为 2.5 亿美元。Crusoe 2023 年的收入预计为 3 亿美元以上。这些公司加起来可为 AI 云市场再增加数十亿美元。

小结:到目前为止,我们对 AI 云服务的年收入有一个非常粗略的估计,约为 200 亿美元。

以上讨论的所有内容都是我所所谓的“AI 基础设施”,其建设是为了支持最终实现 AI 应用价值。可以看出,从半导体到数据中心再到云端,收入出现了急剧下降。这说明了迄今为止 AI 收入的总体情况。

在人工智能领域,半导体板块今年将拿到 1000-2000 亿美元收入,超大规模企业在过去四个季度的资本支出已超过 1750 亿美元,云提供商今年将在人工智能领域获得约 200-250 亿美元的收入。

云计算的收入让我们看到了有多少价值投资到人工智能应用当中;不用说,比迄今为止对基础设施的投资要少得多。

6. 人工智能模型与应用收入

AI 应用价值是目前 AI 市场最重要的一个问题。AI 应用价值最终将推动整个价值链的投资。如果没有后端的价值创造,所有这些基础设施建设都将成为泡沫。

AI应用的收入规模要取决于为客户创造的价值。它解决了什么问题?这些问题的规模有多大?

坦白说,我们现在还没有好答案。Sapphire 估算了以下一些数字:

Scale AI(据报道今年收入达 10 亿美元)与 VAST Data(去年 ARR 为 2 亿美元,今年高得多)等数据公司表明对 AI 应用的需求明显。不过,这些仍属于基础设施类,并未直接接触最终用户。

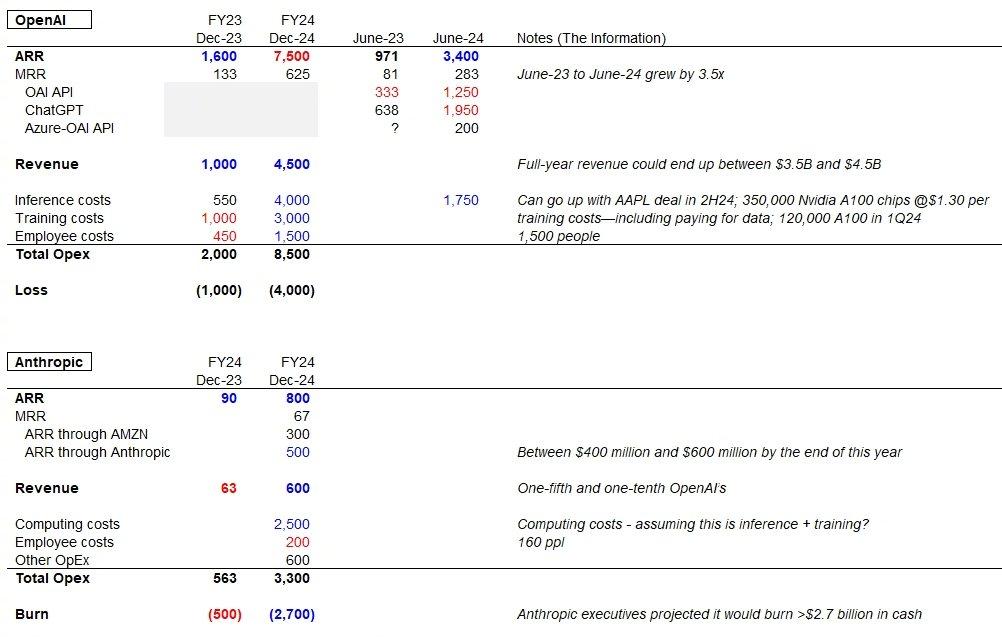

我们对 AI 应用收入的最佳指标来自模型收入(OpenAI 的 API 收入估计为 15 亿美元,Anthropic 2024 年收入估计为 6 亿美元)。Altimeter 的 Freda Duan 详细分析了 OpenAI 与 Anthropic 的预计财务状况。

问题在于分析这笔收入的投资回报率。对于基于 LLM 的应用,我们可以假设毛利率为 80%,并且应用收入在 50 亿至 100 亿美元之间。但是,劳动力替代成本创造的价值又如何呢?比如 Klarna 在客户服务方面节省了 4000 万美元成本。

有两点我可以肯定:

一段时间内,人工智能应用不会对基础设施建设的投资产生净正的投资回报率。

人工智能应用必须不断改进并解决新问题才能证明基础设施建设的合理性。

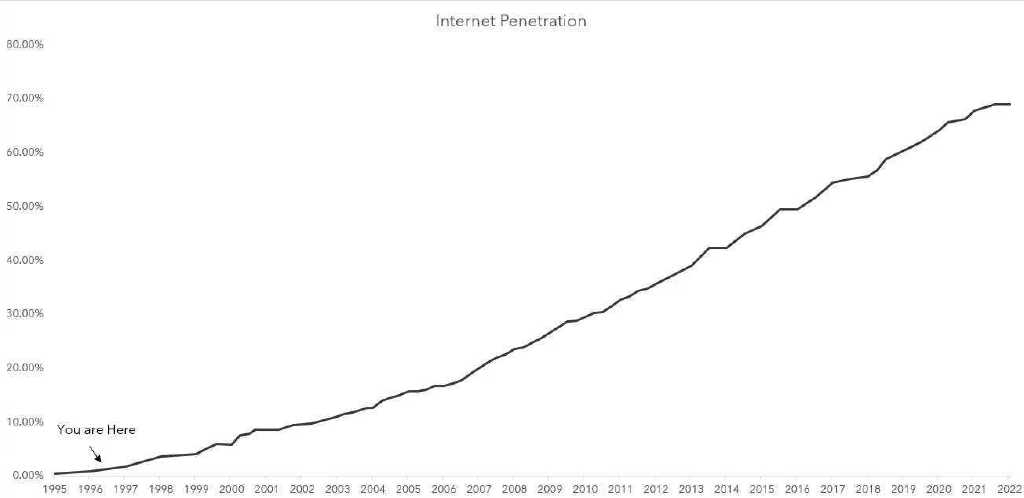

关于后一点,人工智能的未来似乎在智能体(大模型有记忆、能规划,可与工具集成来执行任务)。这似乎代表了人工智能应用价值突破的下一个阶跃函数。但实际上,人工智能价值可能会以我们无法预测的方式表现出来。( 2000 年的时候你怎么能预测到互联网让住在别人家里或搭别人的车成为可能呢?)

正如 Doug O'Laughlin 所指出那样,我们还处在人工智能的早期阶段:

新技术很难预测,尤其是在短期内。但没关系。价值会以不可预见的方式被创造出来。从长远来看,把注押在技术是错误选择;我肯定不会这样。

译者:boxi。

鲁公网安备37020202000738号

鲁公网安备37020202000738号