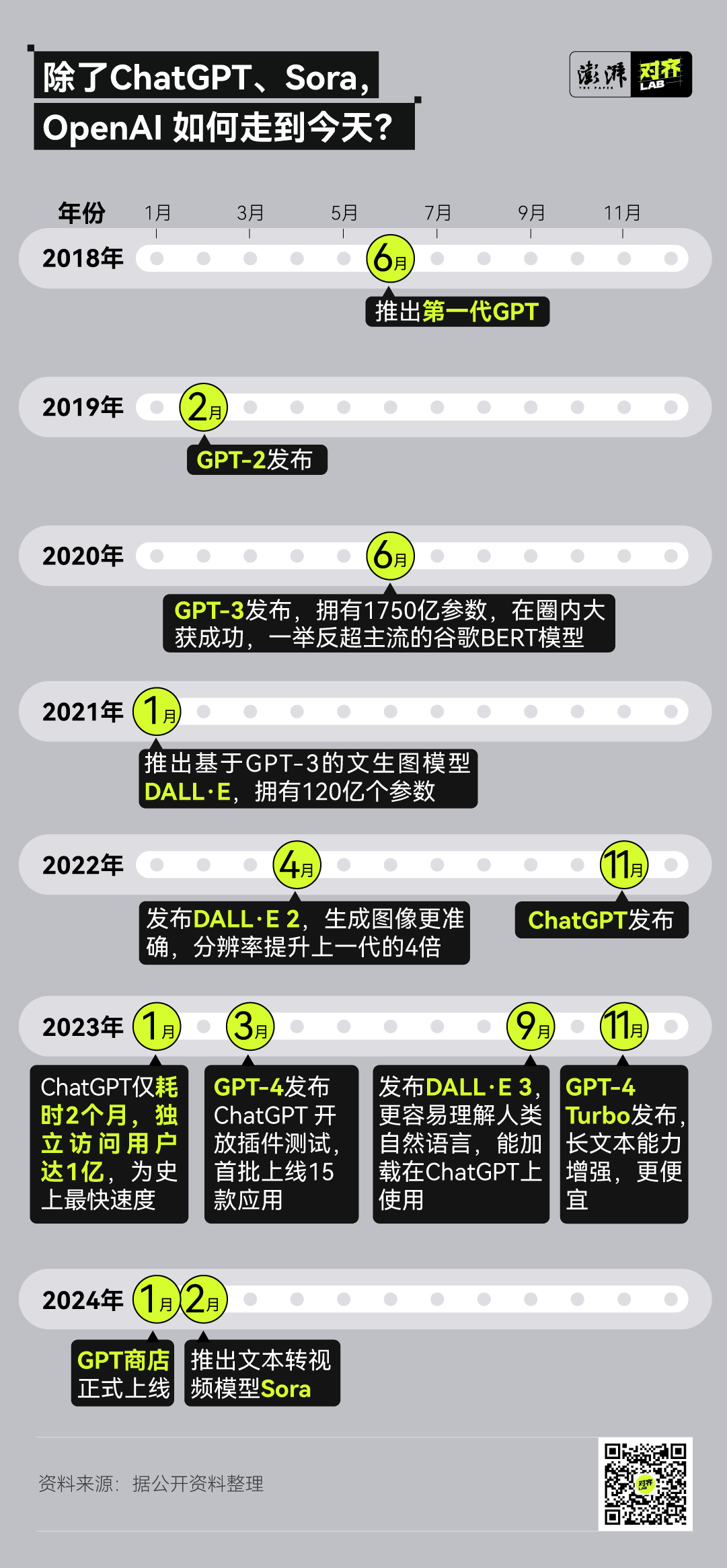

视频生成模型 Sora 横空出世半个月后,仍在强势刷屏。

这款 AI 可以生成长达 60 秒的高质量视频。最令人恐惧的是,其学习的对象不局限于画面、像素,Sora 还“学会”了一些视频中呈现的物理规律(比如人在雨后走过,水面有倒影)。因此,研发它的 OpenAI 称其为“世界模拟器”。

但很多人的疑问是:几乎所有的科技巨头都在 All in 大模型,为什么这次出圈的模型,又是来自 OpenAI?

真正的伟大,无法被计划

2015 年 OpenAI 成立之初,对如何实现目标毫无头绪。

公司的创始人兼 CEO 萨姆·奥尔特曼(Sam Altman)回忆道,最初这个团队连办公室都没有,大家聚集在公寓里,他脑子一直在想:我们该怎么办?

OpenAI 成立第一天的场景,奥尔特曼于 2023 年 1 月 4 日分享在社交媒体 X 上。

这种状态持续了很久。OpenAI 成立一年多时,所有的事情都还进展缓慢。大家只是胡乱尝试一通,钻研了解决视频游戏的系统,在机器人技术上花费了大量精力,然后发几篇论文。

奥尔特曼想起当时公司的景象时说:“我们知道我们想做什么,我们知道为什么要这么做,但我们不知道怎么做。”

不过,这个团队一直被一种乐观力量所驱使,大家对于 AGI 的疯狂愿景,让事情在最终迎来了转机。所谓 AGI,即通用人工智能,也就是像人类一样完成复杂任务的 AI。

这个愿景人类期待了很久,奥尔特曼和他的团队也是。

奥尔特曼 8 岁时,父母送给他一台电脑。一次玩至深夜,他的脑海中突然闪现出一个想法:“有一天,这台计算机将会学会思考。” 等奥尔特曼 2003 年进入斯坦福大学就读时,他仍想完成年少时的梦想,为此修了部分人工智能的课程,但他觉得这些“根本没什么用”。

退学后,奥尔特曼进入科技孵化器 Y Combinator 工作,并在 28 岁接任 CEO。那时,计算机已经能通过深度学习和神经网络完成一些任务,比如给照片贴标签、翻译文本等。这些进步第一次让他相信,AGI 是触手可及的。

然而,把 AGI 交到大公司手中让他感到担忧。奥尔特曼认为大公司会过于专注于自己的产品,而无法抓住机会尽快开发出通用人工智能,即使他们真的开发出来,也可能很鲁莽地将其公之于众。

当时,奥尔特曼一直在考虑竞选加州州长,但很快他意识到,自己可以做一件更大的事:“领导一家可能改变人类的公司”。奥尔特曼开始寻找一些同行者,帮他共同创办一家新型人工智能公司。

彼时,埃隆·马斯克(Elon Musk)正因与谷歌联合创始人拉里·佩奇的一场 AI 讨论,而倍感不快。马斯克事后在 CNBC 的一次节目中谈到此事,佩奇认为机器人和人类应当拥有平等的权利,并指责自己是物种歧视者(speciesist)。这种对于 AI 安全的“漠然”态度,让马斯克感到担忧。

奥尔特曼和马斯克一拍即合。几个月内,奥尔特曼就从马斯克和里德·霍夫曼等人那里筹集了资金。奥尔特曼开始招兵买马,他将招聘范围定得极窄:必须是 AGI 的信徒。凭借他本人和马斯克的号召力,以及探索 AGI 这套诱人的话术,奥尔特曼挖来了 Stripe CTO Greg Brockman 和谷歌大脑核心科学家 Ilya Sutskever 等人。

转折点出现在公司成立一年多后,OpenAI 先后等来了一个人和一项技术。

一个人是传奇 AI 研究员 Alec Radford。他 2016 年加入 OpenAI 时,最大的兴趣是让神经网络与人类进行清晰的对话。

他先是通过 20 亿条 Reddit 评论来训练语言模型。和 OpenAI 的许多早期实验一样,这个实验失败了,但这个 23 岁的年轻人获得了继续前进、再次失败的许可。Alec Radford 继续使用 1 亿条亚马逊评论训练模型,去预测、生成评论中的下一个字符。这一模型能够判断评论是正面还是负面的,如果让模型创建一条正面或负面的评论,它也能做到。“这完全是意外之喜”,辨别评论的情感是一个复杂函数,但不知为何,Alec Radford 的模型找到了一点感觉。

而 OpenAI 等来的技术则诞生自它的竞争对手谷歌。2017 年初,一篇由 8 位谷歌研究人员合著的研究论文预印本出现了,但并未引起人们的注意。这篇论文的正式标题是“Attention Is All You Need”,它后来被称为“Transformer 论文”。Transformer 使神经网络能够更高效地理解和生成语言,通过并行分析语料,找出哪些元素值得关注。这极大地优化了生成连贯文本以响应提示的过程。后来人们意识到,同样的技术也可以生成图像甚至视频。

虽然该论文后来被称为当前 AI 狂潮的催化剂,但在当时,Ilya Sutskever 只是少数几个了解这一突破有多么强大的人之一。Brockman 回忆道,Ilya 看到 Transformer 出现时,惊喜地喊到:“这就是我们一直在等待的”。

之后,Alec Radford 开始试验 Transformer 架构。他表示,当时在两周内取得的进展超过了过去两年的进展。

Radford 和他的合作者给他们创建的模型起的名字是“generatively pretrained transformer”——这就是今天我们耳熟能详的 GPT 一词缩写的全称。最终,这个模型被通称为“生成式 AI”。该模型包含 1.17 亿个参数或变量,在理解语言和生成答案方面的表现优于之前的所有模型。

仅从事后的叙述来看,OpenAI 的成功仿佛是一步一脚印的,它把握住了所有关键时点,无一遗漏。但是奥尔特曼仍然强调:“我们没有总体规划”,OpenAI 所做的一切就像“穿过迷宫到达终点”,而终点即是安全的 AGI。

即便是对于 GPT 的诞生,奥尔特曼也感到吊诡。他十岁时,对于 AI 的想象遵循这样的路径:有机器人后,先体力再脑力;在初级脑力工作后,再会做复杂脑力工作,比如证明一个数学定理,最后才是拥有创造、写作等深层次能力的 AI。但“事实正朝着完全相反的方向发展”。

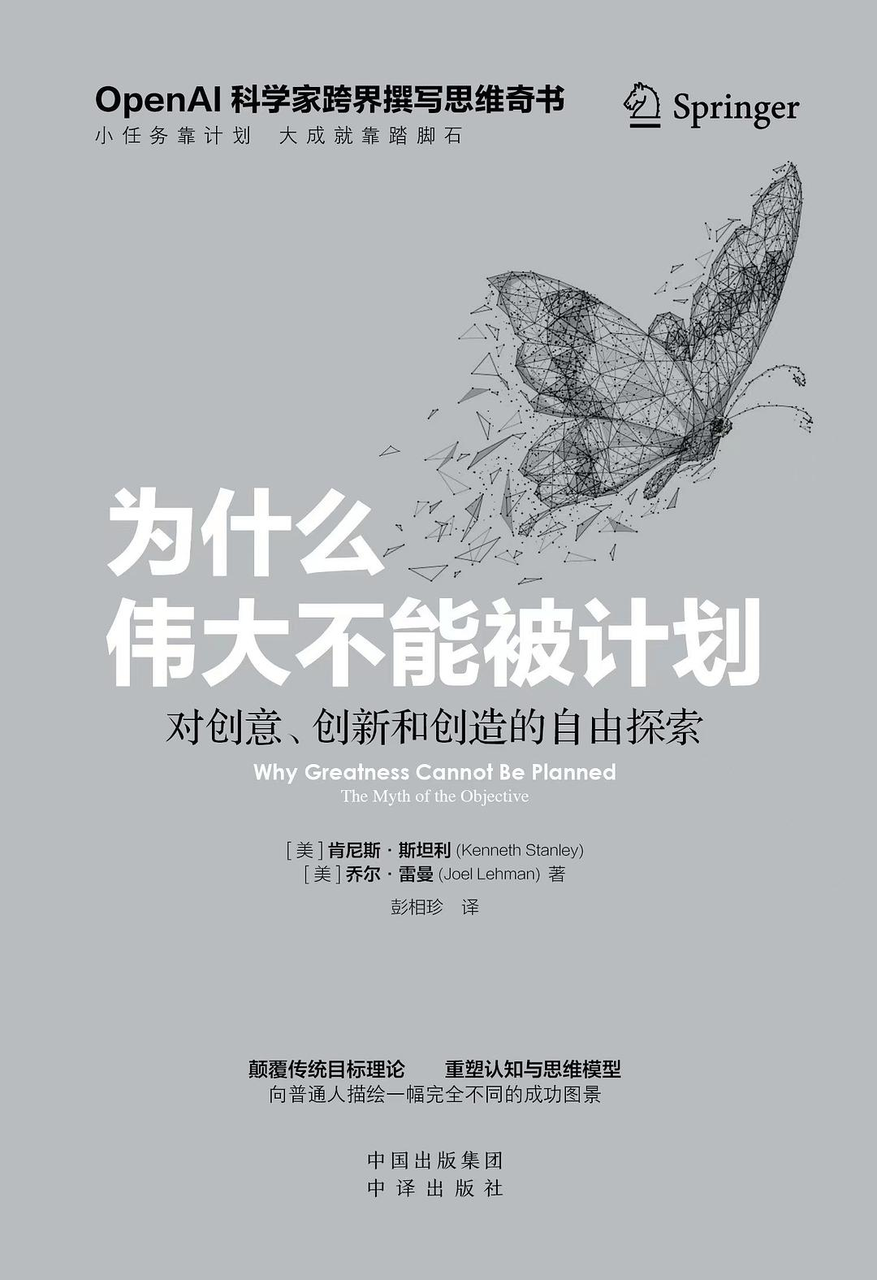

OpenAI 的科学家肯尼斯·斯坦利(Kenneth Stanley)和乔尔·雷曼(Joel Lehman)在近期出版的书籍《为什么伟大不能被计划》对此进行了高度总结:真正的伟大无法在计划中诞生。

来自 OpenAI 的科学家肯尼斯·斯坦利和乔尔·雷曼撰写的书籍《为什么伟大不能被计划》

作者乔尔·雷曼在一次专访中表示 OpenAI 做了很多了不起的事,但 ChatGPT 绝对不是 OpenAI 成立之初的目标。OpenAI 的许多早期探索还与电子游戏、多代理模拟(multi-agent simulations)和机器人有关,许多通往 ChatGPT 的踏脚石都没有把 ChatGPT 当成最终目标。

某种意义上,ChatGPT 的紧急推出,也是一种营销策略。

营销踩点,OpenAI 抢走谷歌风头

OpenAI 成立之初,颇有一层与谷歌对抗的意味。奥尔特曼和马斯克都认为:与其让大公司控制少量的 AI 系统,不如让大量独立的 AI 系统同时存在予以制衡,人们可以根据开放的源代码建立各自 AI 系统。

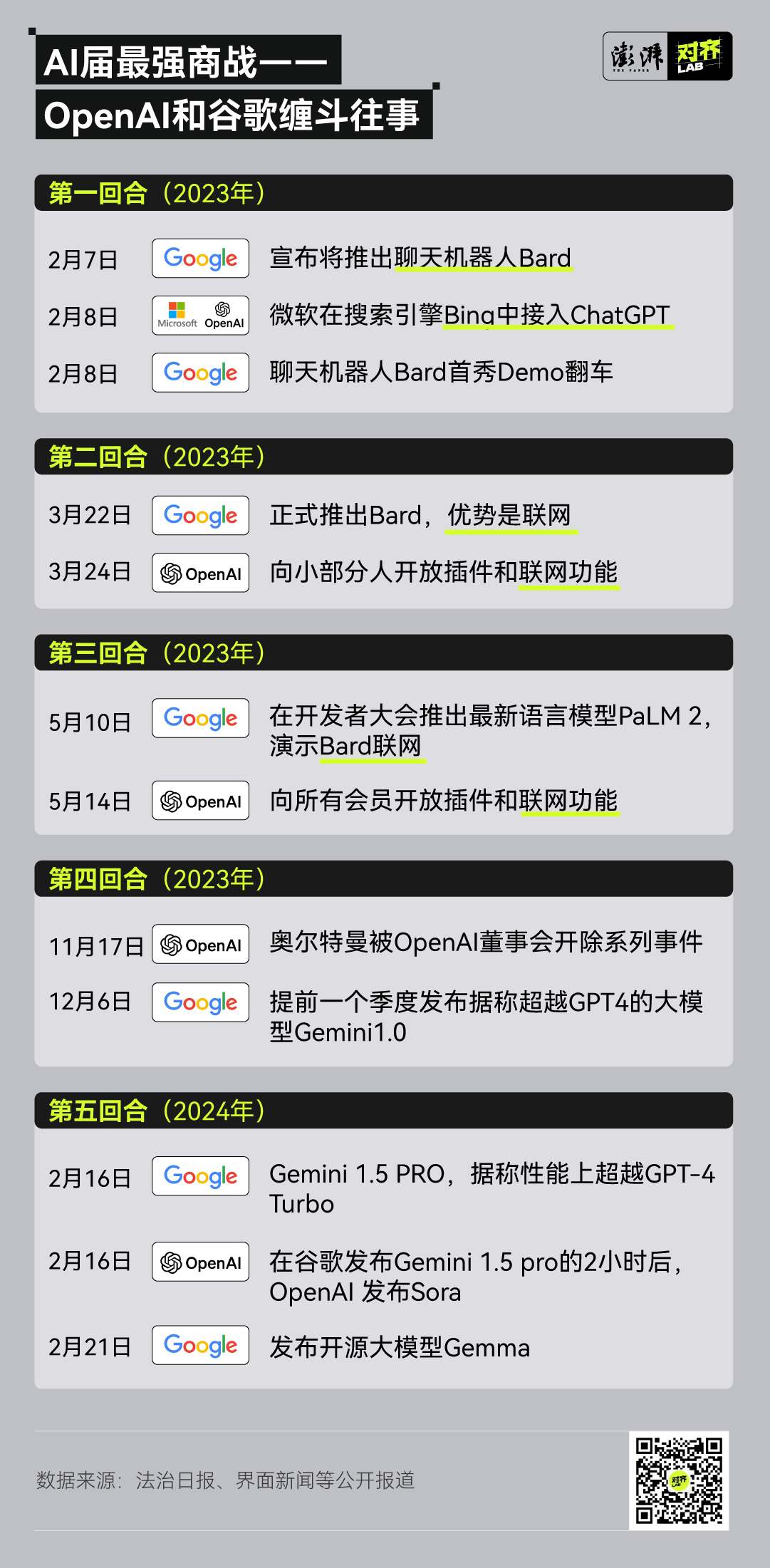

彼时的谷歌确实是 AI 领域的老大哥,ChatGPT 最初依赖的 Transformer 架构即来源于谷歌。但现在的 OpenAI 至少在 AI 领域,已有足够的底气和谷歌掰手腕。

最近一次商战在 2 月 16 日。

当时,谷歌推出了据称性能上超越 GPT-4 Turbo 的 Gemini 1.5 PRO ,而仅仅在两小时后,OpenAI 就推出了 Sora。Sora 推出后,奥尔特曼在社交媒体 X 上在线接单,按照用户给出的提示词一连发布了 8 条视频。此外,OpenAI 官方号还进驻 TikTok 发布 Sora 视频,仅一周时间就收获了超 14 万粉丝。这些方式进一步“炒火”了 Sora。

很难说,这只是一种巧合。我们发现在谷歌推出某项新产品、新模型或新计划后,奥尔特曼常常会从“武器库”里翻出一把利器。人们的目光便立刻从谷歌身上移开,并且不再回来。360 创始人周鸿祎对此表态:“OpenAI CEO 是个营销大师,知道怎样掌握节奏,他们手里的武器并没有全拿出来。”

这样的例子并不鲜见。

谷歌在 2023 年 3 月 22 日推出聊天机器人 Bard,当被问及与 ChatGPT 的区别时,Bard 就回复:“我不仅基于文本和代码,并且有互联网上的真实世界的信息作为支撑,因此我能够做到 ChatGPT 做不到的事”。仅仅两天后,OpenAI 就宣布向部分用户开放插件和联网功能。

到了 2023 年 5 月,谷歌和 OpenAI 的擂台仍不休止。前脚是谷歌在开发者大会上宣布一系列 AI 成果——推出据称部分能力超越 GPT4 的 PaLM 2 模型、演示 Bard 联网,后脚 OpenAI 就宣布向会员开放插件和联网功能。

当然 OpenAI 的营销瞄准对象并不仅谷歌一家。

OpenAI 在 2022 年 4 月份小范围内推出了文生图模型 DALL·E2,不过很快风头就被开源的 Stable Diffusion 和另一竞争对手 Midjourney 盖过。数以百万计的用户都在使用文生图产品,一时间呈现出病毒式传播的现象。

OpenAI 从中获得的启示是,向大众公开生成式 AI 产品,不仅能吸引大量用户,收获有价值的用户数据,还可能引来更多资金。

谷歌搜索趋势显示,OpenAI 推出的文生图模型 DALL·E,风头很快被对手 Stable Diffusion 和 Midjourney 盖过。 注:官方名称为 DALL·E,而图中用网上较为普遍使用的 DALL-E 进行检索

那什么样的营销事件能让话题关注度迅速回来?

OpenAI 的答案是聊天机器人。

彼时,OpenAI 在 GPT 4 上已经花了一整年,模型也基本准备就绪。但是来自市场层面的压力迫使 OpenAI 调转车头,迅速发布一个聊天机器人。从计划推出 GPT 4 转到做一款聊天机器人,仅仅十三天后,ChatGPT 就诞生了。

这种策略后来被称为“迭代部署”,构建所谓的“最小可行产品”:先拼凑出一个很酷的演示,吸引一小群喜欢它的用户,并根据用户反馈进行改进,再把产品推向全世界。最终,如果足够幸运并且做得正确的话,这将吸引大量用户,点燃媒体炒作周期的导火索,巨额资金将随之而来。

暴力美学,Scaling Law 信仰

这次出圈爆火的 Sora 可以生成长达 60 秒的高质量视频。令人恐惧的是,其学习的对象不再限于画面和像素,它还“学会”了视频中展示的物理规律。

Sora 使用一种新的 Diffusion Transformer 模型,它融合了扩散模型与自回归模型的双重特性。不过,在 Sora 的技术文档里,OpenAI 并没有展开模型的技术细节,只有透露了诸如“patch(视觉补丁)技术”、“重新字幕技术”等拼图碎片。

但是,一个核心理念——Scale 又再次被提及。文档写道:Sora 基于的 Diffusion Transformer 模型也是符合规模效应的(scale effectively),随着训练计算量增加,视频质量显著提升。

OpenAI 给出的小狗视频案例,可以看出 Sora 在 Scaling Law 下的效果提升。

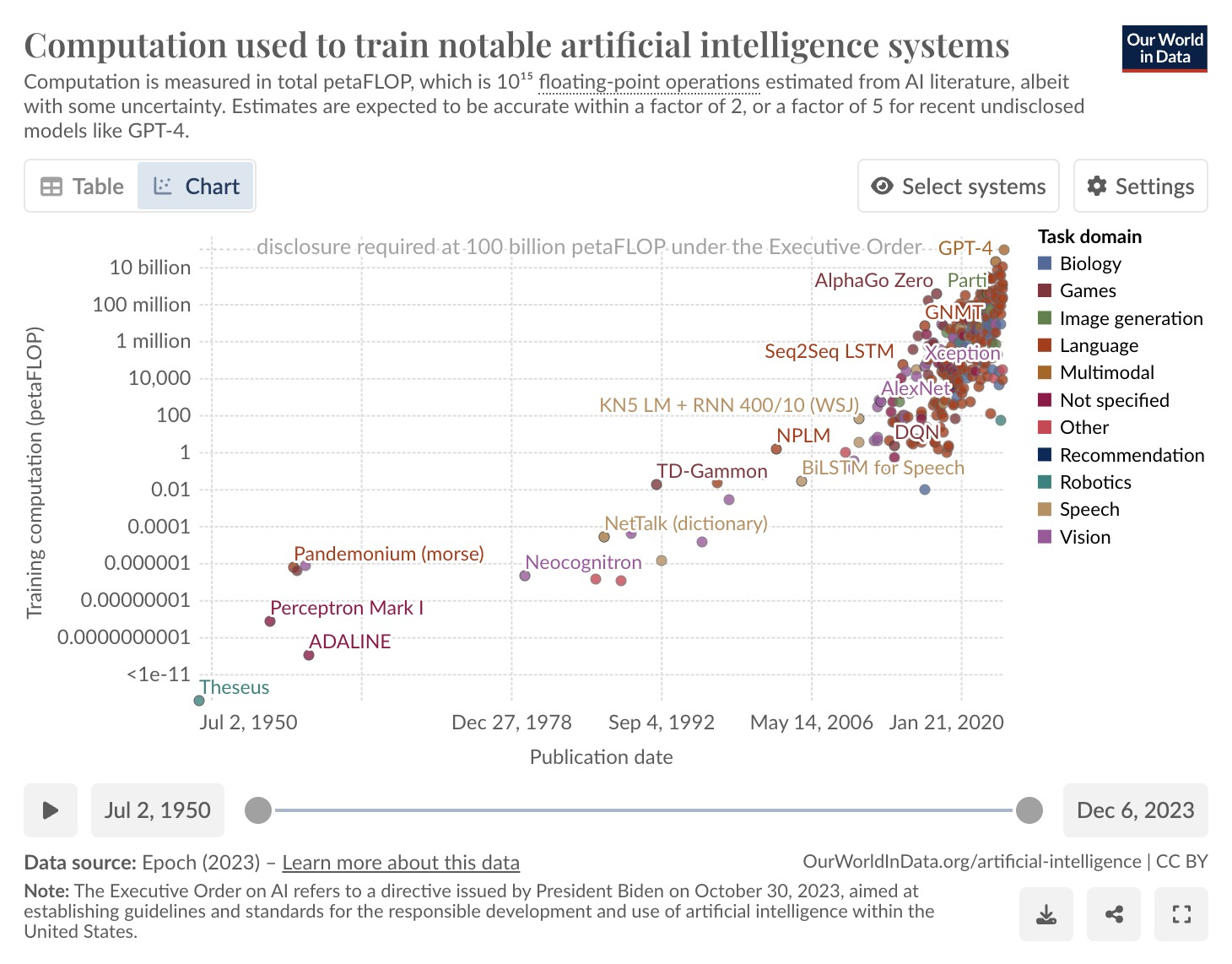

这一理念以 Scaling Law(规模法则)的名称为业内熟知。根据 Scaling Law,模型性能会在大算力、大参数、大数据的基础上像摩尔定律一样持续提升,这不仅适用于语言模型,也适用于多模态模型。

OpenAI 是 Scaling Law 的忠实信徒,其将 Scale 列为企业核心价值观之一:“我们相信规模——在我们的模型、系统、自身、过程以及抱负中——具有魔力。如有疑问,扩大规模。”

来自 OpenAI 的科学家乔尔·雷曼在一次专访中对此强调:有一条主线贯穿 OpenAI 研究的始终,即规模——大型神经网络、大数据、大量算力的重要性,很多人迟迟没有意识到这一点。这一表述揭示了 OpenAI 持续领跑的另一原因。

无论是一年多前风靡全球的 ChatGPT,还是目前火出圈的 Sora,再到 OpenAI 早期爆发业内地震的 GPT-3(有 1750 亿参数,一位图灵奖得主称“全宇宙无非是 4.32 万亿个参数而已”),可以说都是 Scaling Law 的产物——当模型足够“大”,就会产生智能涌现的能力。

上图展示了 AI 模型正在往暴力美学方向进行范式迁移,随着时间推移,模型运算量指数级上升。 https://ourworldindata.org/grapher/artificial-intelligence-training-computation

那么,模型一定是越大越好吗?如果数据量足够大、算力足够充沛,是否永远触不到上限?目前的观点仍是莫衷一是的。

支持者认为,超大规模及足够多样性的数据、超大规模的模型、充分的训练过程,是让 AI 智能“涌现”的必由之路。路途之中,可能会出现出人意料的惊喜,也可能是惊吓。

反对者认为,大模型虽好,但其性能有一个上限,虽然这个上限尚不明确。

最易被人理解的原因是“数据是有限的”,一篇 2022 年 MIT 的论文给出了这样的估算结论:高质量的语言数据将会在 2026 年左右用光,低质量语言数据会在 2030 到 2050 年用光,低质量图像数据会在 2030 到 2060 年用光。

还有一种观点认为大模型存在方向上的路线错误。这一派观点主要认为:大模型本质上只具有通过观察进行因果归纳的能力,不具备因果演绎的能力。但是,AGI 应该是一个“能够理解世界的模型”,而不仅仅是描述世界。

拼算力,抱紧微软

但问题在于,大模型训练的“暴力美学”法则的可行性已人尽皆知,那为什么这次文生视频最出圈的模型,又是出自 OpenAI ?

一个现实因素是,Scaling Law 需要高昂的算力支出来支撑,而这正是 OpenAI 比较擅长的。视频模型的竞争最终也从拼团队的调参能力,衍变到最后是拼算力。这便是 OpenAI 走在前列的第三个原因:能拼算力,不缺钱。

OpenAI 前期的资金支持基本都来源于马斯克。但在 2018 年,特斯拉开始研究将 AI 技术用于自动驾驶,而刚好 OpenAI 已经有了显著的技术突破。

马斯克在当时提议,不如把整个公司都交给他来打理——直接把 OpenAI 并入特斯拉。但这个提议遭到奥尔特曼和其他高管的拒绝,于是双方分道扬镳,马斯克撤走了他全部的投资,在一次全体会议上宣布自己会离开。会上,他预言 OpenAI 将以失败告终,他还称至少有一名研究人员是“蠢货”。

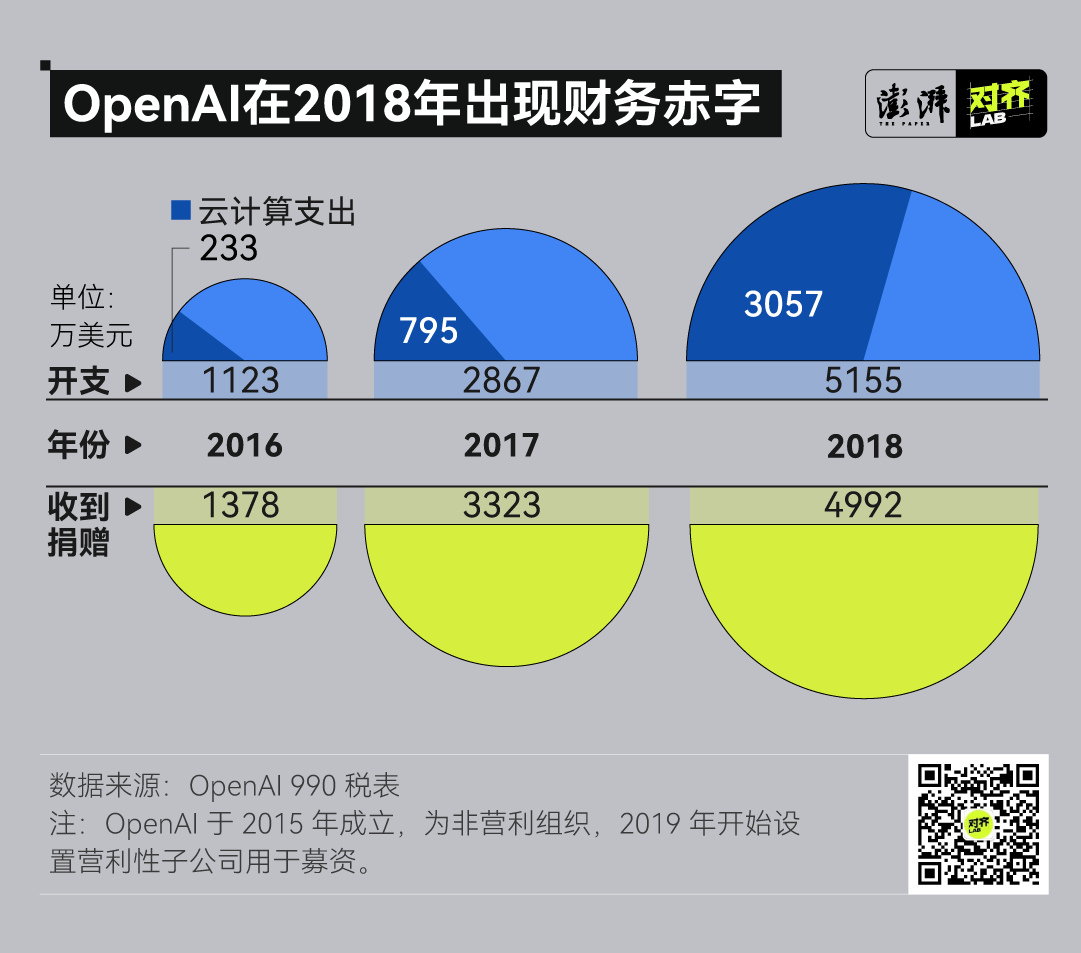

由于公司没有收入,马斯克撤资无疑是一场生存危机。虽然 OpenAI 正在做的研究是硅谷最时髦的 AI,但它是一家非盈利机构,这无疑限制了它融资的吸引力。

2019 年 3 月,OpenAI 想到了一个办法。在保持非盈利的同时,再创建一个盈利实体。但这个盈利部门的营收有一个上限——这个数字并没有公开,从公司章程推测,可能高达数万亿美元。在达到这个上限之后,盈利实体所得的一切都要归还给非盈利的研究实验室。

对 OpenAI 来说,AI 研发是一个夸张的无底洞。创造大型语言模型的 Big Transformer 方法需要大型硬件,GPT 系列的每一次迭代都需要呈指数级增长的算力,只有少数几家公司有负担的能力。

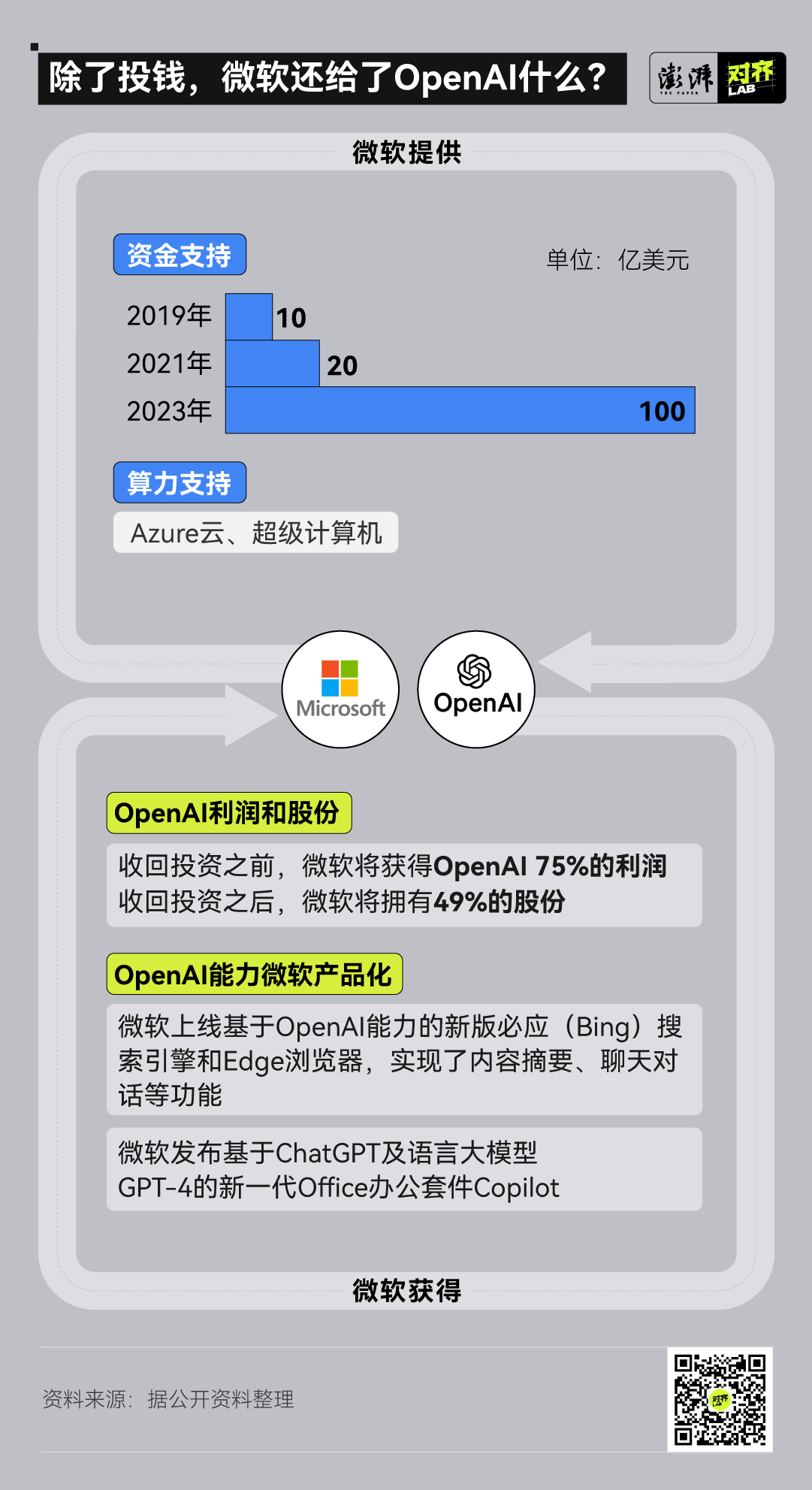

OpenAI 很快锁定了微软。

奥尔特曼后来对记者表示,这是因为微软 CEO Satya Nadella 和 CTO Kevin Scott 足够有魄力:在花费了 20 多年时间和数十亿美元建立了一个所谓的尖端 AI 研究部门之后,承认自己的工作一团糟,然后押注一家成立仅几年的小公司。

微软最初出资 10 亿美元,并提供当时全球排名前五的超级计算机作为回报。但随着双方信心的增强,交易规模不断扩大。现在,微软已经向 OpenAI 投入了 130 亿美元。

微软也为自己争取到了一大笔好处。根据财经媒体 Semafor 报道,直到微软收回投资之前,都将获得 OpenAI 75%的利润。在达到这一门槛后,微软将拥有 49% 的股份,OpenAI 的非营利性母公司则持有 2% 的股份。此外,微软还获得了 OpenAI 技术独家商业化授权,并且成功让旗下云计算平台 Azure 成为 OpenAI 的独家云服务商。

当然,根据交易条款,OpenAI 最初的一些理想——为所有人提供平等访问权——被丢进了垃圾桶。

在交易的过程里,OpenAI 逐渐有了营利性机构的性质,这让一些员工感到反感,几位高管随之离职,他们认为,OpenAI 已经变得过于商业化,偏离了最初的使命。

“强者,便使它更强”

“凡有的,还要加给他,叫他有余。凡没有的,连他所有的,也要夺去。”马太效应再次在 OpenAI 身上得到应验。

2023 年后,OpenAI 的强势领先从模型本身开始落到了账面上。根据金融媒体 FT 在 2024 年 2 月的最新报道,OpenAI 最新年化收入突破 20 亿美元,这一水平与另一家科技巨头 Meta 相当。而在 2022 年,OpenAI 的年化收入为 0.28 亿美元。不断刷新的年化收入,没人能看到 OpenAI 的营收天花板。

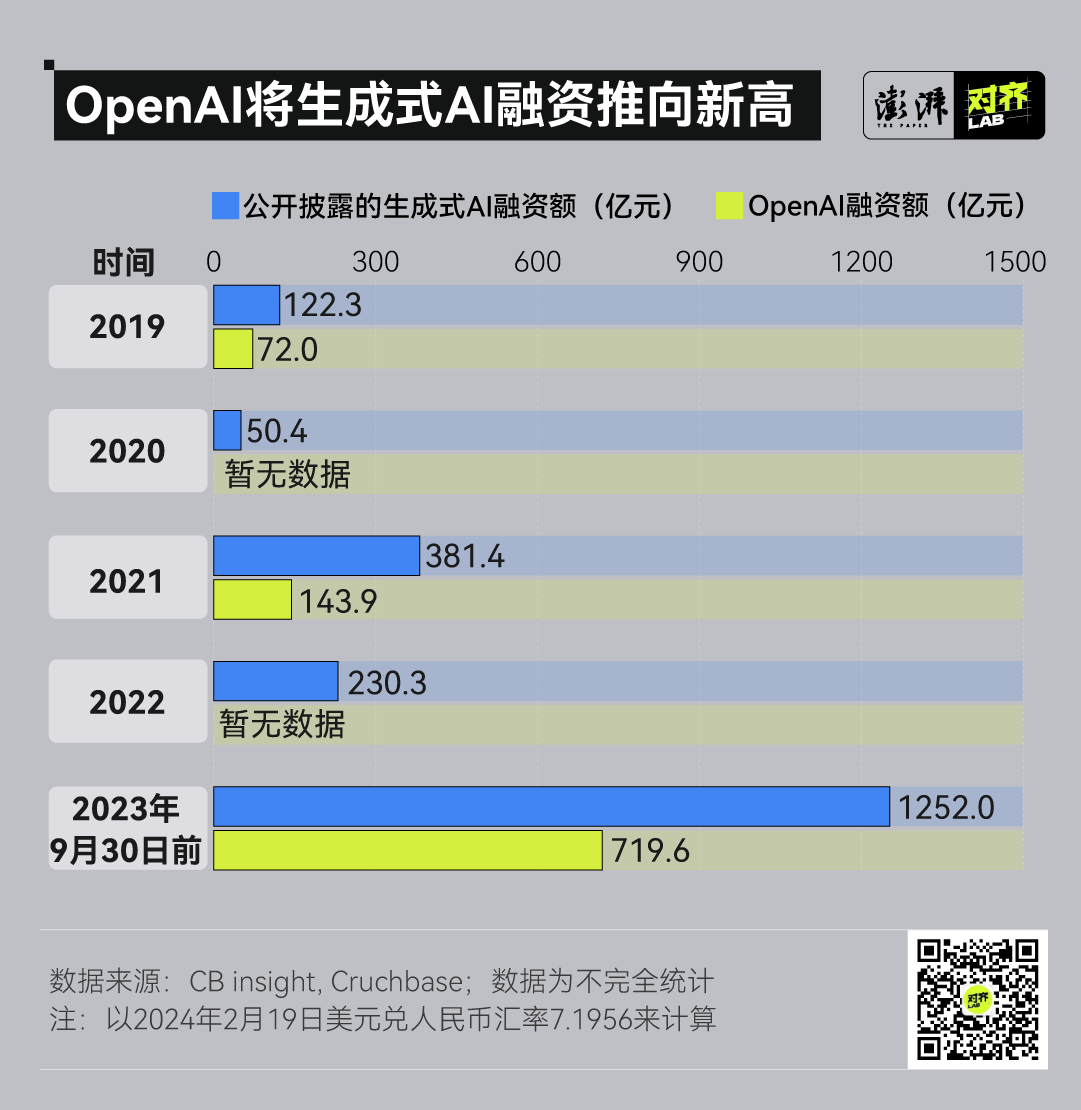

此外,OpenAI 还拿到了当前生成式 AI 领域的最多融资。

截至 2023 年 9 月 30 日,微软就向 OpenAI 投资了 100 亿美元(折合人民币 719.6 亿元),占了当时生成式 AI 领域融资额的 57.8%。

营收和融资如此强劲的 OpenAI,还在广泛进行战略布局。OpenAI 已经至少投资了 19 家公司,范围涉及机器人、代码编辑、新闻报道、交友育儿等多种垂直领域。此外,OpenAI 还收购了一家创意设计公司,全球照明(Global Illumination),以拓展生成式 AI 的应用可能性。

而 OpenAI 的每次大动作也使得一部分投身生成式 AI 领域的创业小公司感到无穷危机。此次 Sora 的推出,就被认为“吊打”此前爆火的 Pika 和 Runway。

科技孵化器 Y Combinator 一场讨论,直接发出了灵魂提问:“OpenAI 会杀死所有创业公司吗(Will OpenAI Kill All Startups)?”

时间回到 2022 年底,答案似乎是显而易见的。金沙江创业投资基金主管合伙人朱啸虎对此表示,“ChatGPT 太强大了,对创业公司很不友好。”

当时,直接受到冲击的企业大多生产基于 GPT 二次开发的“套壳产品”,明星独角兽公司 Jasper 就是其中之一。其业务是在 GPT-3 的基础上进行高精度的前端提示和交互界面设计,再利用营销经验对模型微调,生成文章。但 ChatGPT 推出后,这一模式完全翻船了。 用户可以使用自然语言与 ChatGPT 对话。“中间商”不需要了。

不仅如此,OpenAI 的发展似乎开始偏离了他们的初心。

马斯克就曾直接开炮,他为 OpenAI 取了这个名字,意图抗衡谷歌,“然而现在它却变成一个不开源、追求最大化利润的公司,并且还由微软控制。”

而 OpenAI 成立营利性子公司,不再开源 GPT 模型的做法,也使得更多人赞同了马斯克的评价。难怪有人认为,OpenAI 已经不再 “Open”。

此前的 OpenAI“宫斗”之争,实质上也是关于 AI 发展的“理念之争”——到底是加速 AI 的商业化进程,还是确保 AI 的安全性再推向全世界。

因此,OpenAI 对人类走向通用人工智能时代到底意味着什么,仍是未知。

*封面图由 Stable Diffusion 生成

鲁公网安备37020202000738号

鲁公网安备37020202000738号