随着ChatGPT点燃的人工智能(AI)热潮,通信行业的面貌焕然一新。在各种行业展会、论坛上,面向通信行业的AI应用层出不穷。

“ALL in AI,AI for All”不仅仅是口号,AI已经和通信系统深度融合。甚至可以说,在有些方面AI已经成为了主角,形成了通信×AI的乘数效应。

5G-A是5G下半场演进的技术底座,“泛在智能”已经成为了5G-A发展的重要方向,5G-A×AI的能量正在厚积薄发。

其实,在5G以及5G-A标准的制定过程中,业界也早已认识到了AI的优势,并试图把一些流程用AI来优化赋能。

那么,从标准的角度看,3GPP在网络智能化方面的进展如何?

来源:Linkedin:AI in 5G Use Case - Summary of 3GPP's Work & Study on AI/ML for 5G System

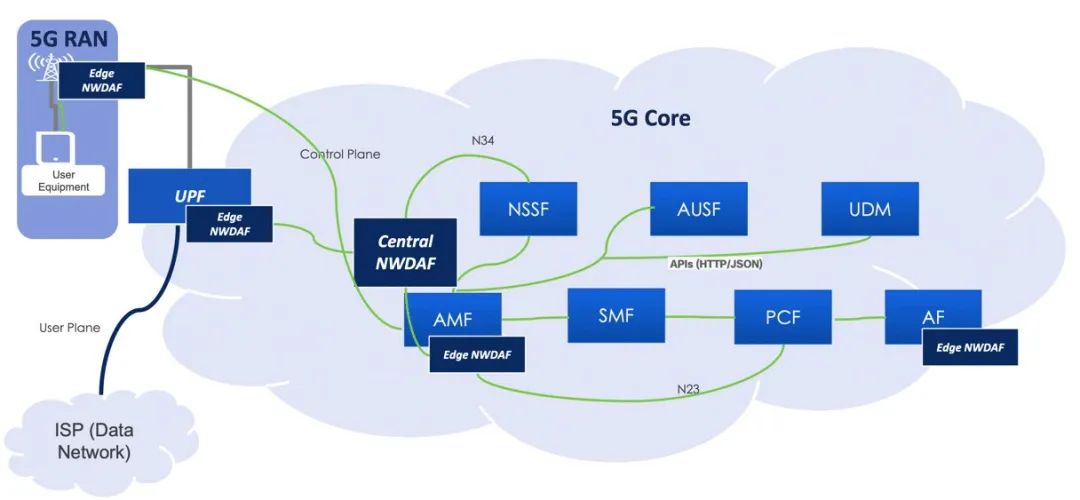

可以看出,在5G阶段,网络智能化有核心网的NWDAF(NetWork Data Analytics Function,网络数据分析功能)、运维层的MDAF(Management Data Analytics Function,管理数据分析功能),以及接入侧的一些基本功能研究,这些AI局限在网络侧,和终端没有交互。

到了5G-A阶段,标准制定的AI能力向网络和终端协同的更复杂功能演进。最后到6G,就是全栈全节点的原生智能了。

网络层及运维层网元

早在5G标准的第一个版本R15,3GPP就定义了一个全新的核心网网元——NWDAF。

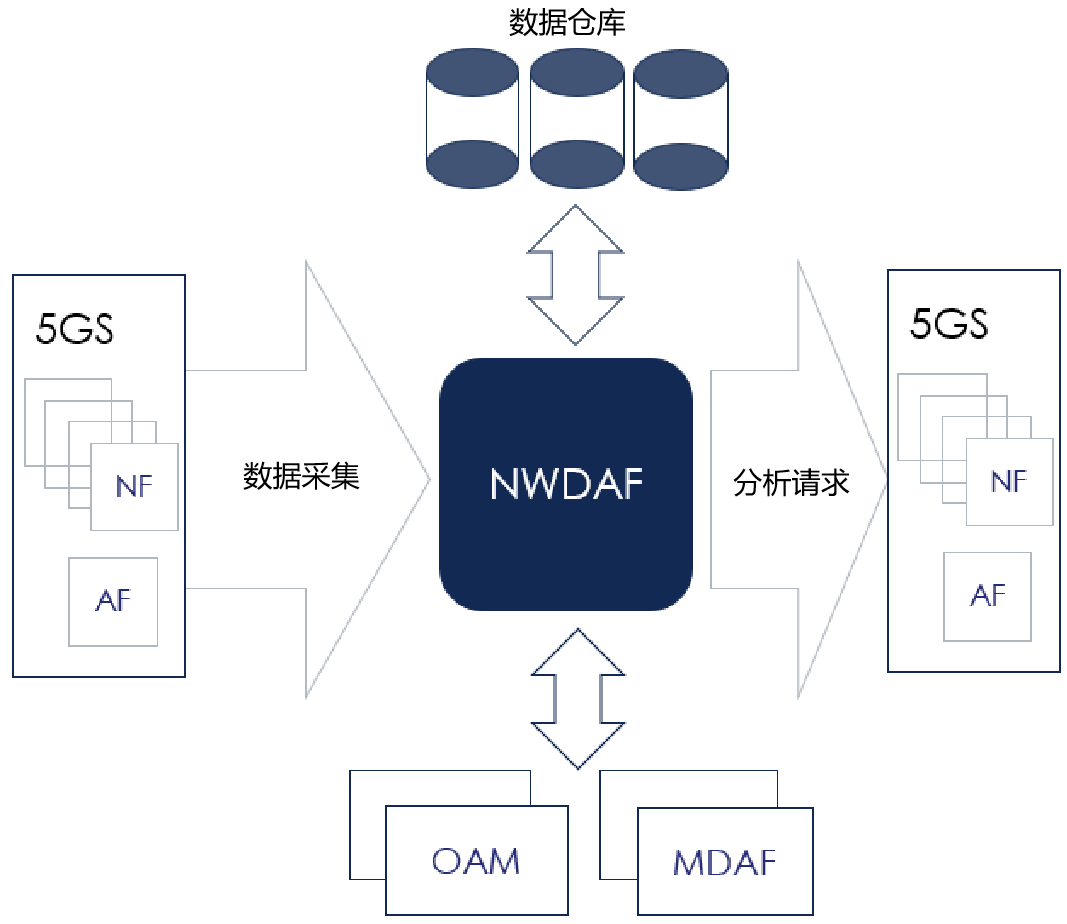

NWDAF从各种核心网网元、应用、运维系统以及运营支持系统收集数据,然后对这些数据进行分析,以提供有关网络性能和健康状况的建议及处理方案。

NWDAF可以支持:

网络性能监控:监控时延、吞吐率、以及网络可用性等关键网络指标,用于识别和解决性能问题。

网络安全分析:分析网络流量,以识别潜在的安全威胁,用于提高网络的安全性。

客户体验优化:分析客户数据,用于改善客户体验。比如,NWDAF可发现某些客户或特定应用程序的体验不佳,并定位存在问题的地点。

网络自治闭环:支撑网络运维自动化,在出现性能问题或安全威胁时自动生成告警。

与此同时,网络运维(OAM)系统也需要增强,即通过引入AI和自动化来实现接近零接触的网络及服务管理编排。

在此背景下,3GPP在R17版本为网络运维层引入了MDAF,进一步丰富和增强管理功能,实现最佳的网络性能及服务保障。

综合下来,5G核心网及运维层的智能化架构是下图这样的。

核心网以及上层的运维有了这些动静,那么接入网NG-RAN(Next Generation Radio Access Network,下一代无线接入网)呢?

RAN接入层智能化

3GPP也是从R17阶段开始研究怎样把AI引入基站及终端,首先考虑的是网络节能、负荷均衡以及移动性优化等基础功能。

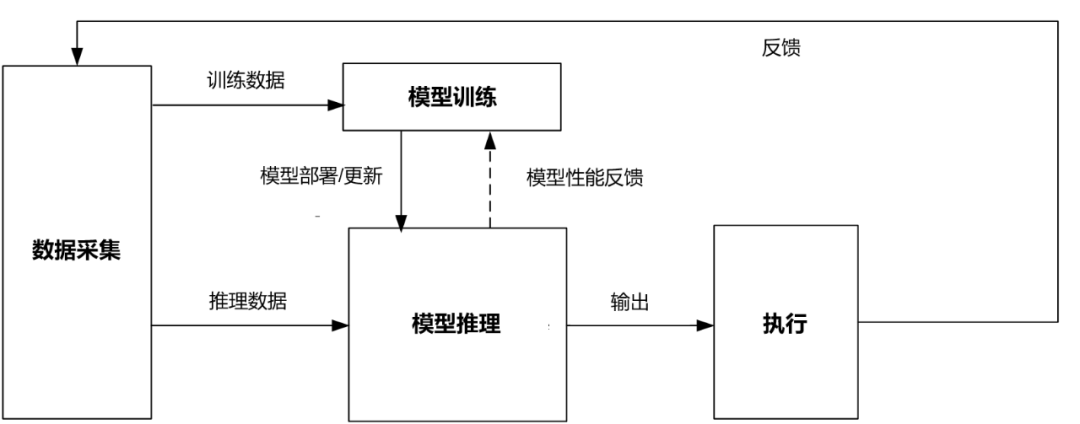

首先要做的是定义AI在RAN(Radio Access Network,无线接入网)侧的基本运行结构:

从上图可以看出,RAN侧的AI框架和通用的AI架构并没有大的不同之处,都分为数据采集、模型训练、模型推理和执行这几个模块。

数据采集:通过标准接口从网络中获取数据,并提供给模型训练和模型推理。

模型训练:进行数据的预处理,并执行AI/ML训练、验证、测试等工作。

模型推理:采用训练好的模型来进行推理,生成预测数据并进行智能决策。

执行:接收模型推理的结论,并在网络中实际生效执行。

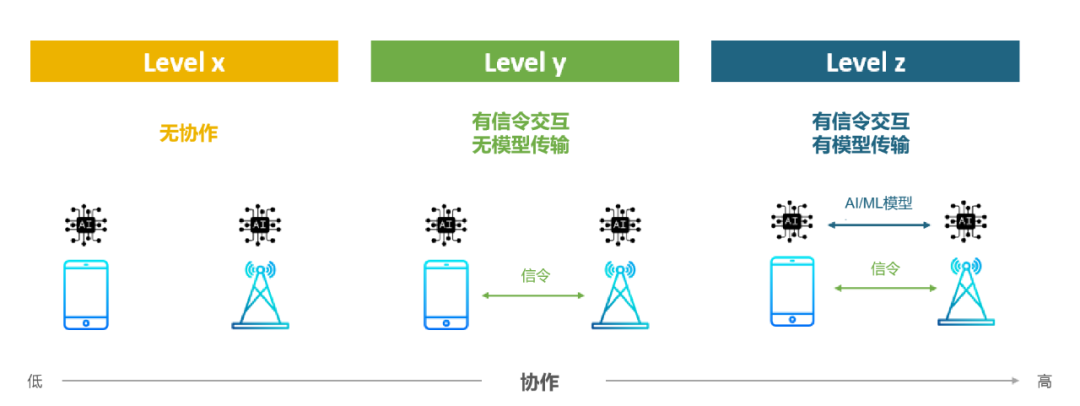

那么,这些模块是在终端侧运行,还是在网络侧运行?答案是都可以,3GPP根据协作程度的高低定义了x,y,z三个级别。

来源:Linkedin:AI in 5G Use Case - Summary of 3GPP's Work & Study on AI/ML for 5G System

Level x:基站和终端各自管各自的AI处理,之间没有任何交互与协作。

Level y:基站和终端之间的AI处理通过信令交互,但它们之间的交流也仅限于此,没有AI模型层面的交互。

Level z:基站和终端之间的AI处理既有信令交互,也可以进行AI模型的传输和更新。这就是最高级别的协同了。

目前已在R17阶段研究并在R18阶段标准化的RAN侧AI主要是网络节能、负荷均衡以及移动性优化。

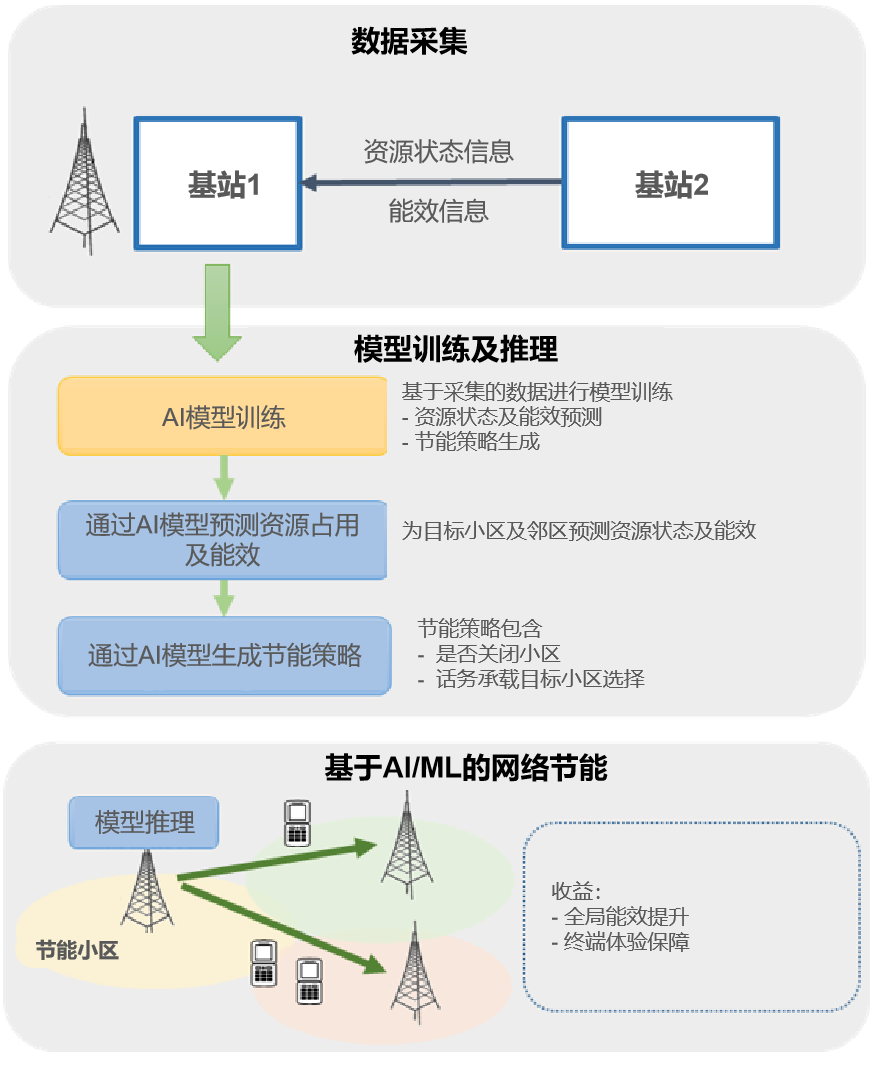

网络节能:节能的关键是精准预测话务量,并根据话务量来最大程度关闭空闲资源。网络节能的挑战在于话务预测的精度、网络性能和节能之间的收益平衡,以及迭代优化配置的高效性。通过引入AI,可以让网络能效更上一层楼。

来源:Samsung Rearch:First Light of the AI/ML Empowered RAN in 3GPP

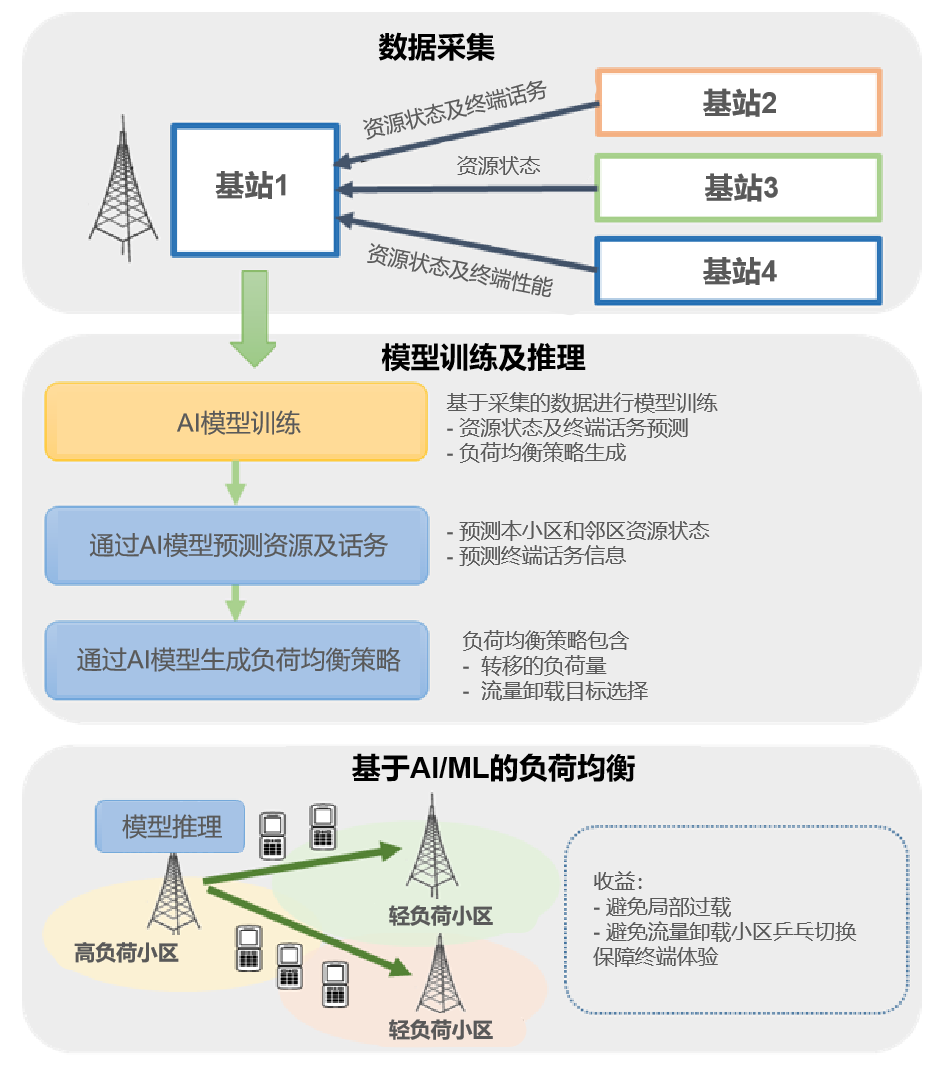

负荷均衡:如果大量用户集中在一个小区,周围的小区还很空闲的话,就需要负荷均衡来把用户平均分配在各个小区,最大化资源利用。怎样迁移用户才能始终保持网络体验最佳?这也需要AI的加持。

来源:Samsung Rearch:First Light of the AI/ML Empowered RAN in 3GPP

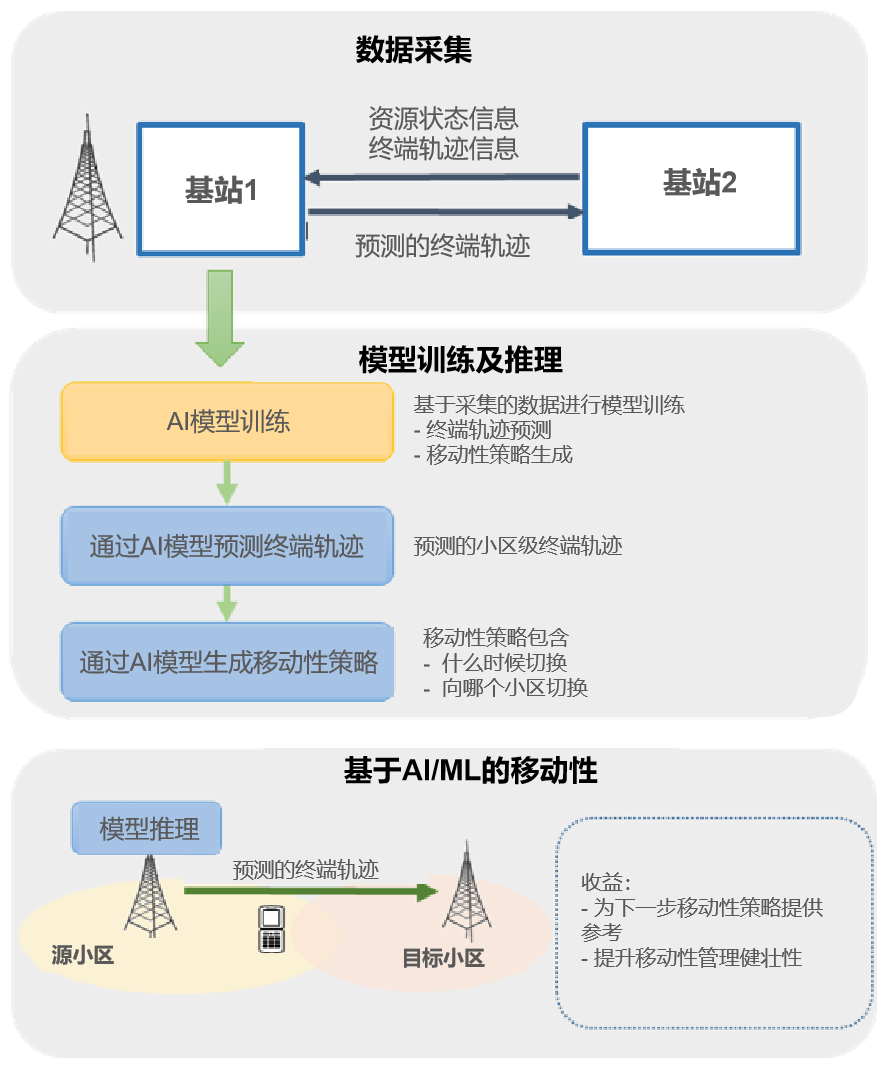

移动性优化:移动性是指用户在移动时,本小区的服务质量下降,需将用户切换到最合适的小区。不切换不行,切换太频繁了也不好,那么怎样保证以最少的切换次数保障最优的用户体验?AI能让每一次切换都恰如其分。

来源:Samsung Rearch:First Light of the AI/ML Empowered RAN in 3GPP

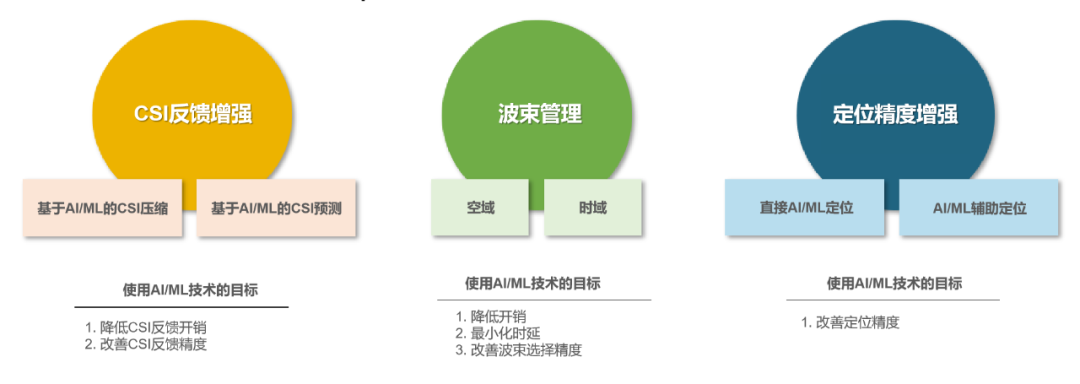

在R18阶段,3GPP研究了CSI反馈增强、毫米波波束管理以及定位精度增强这三个AI应用,跨入了系统和终端协作新时代。

来源:Linkedin:AI in 5G Use Case - Summary of 3GPP's Work & Study on AI/ML for 5G System

CSI反馈增强:CSI(Channel State Information)是终端测量得到的信道状态信息。信道状态信息越准确,用户的下载速率也就越高。然而在大规模MIMO系统中,大量天线会导致CSI数据量巨大,反馈开销也很大。

如果我们能利用神经网络框架对CSI进行非线性编码和解码,可提高系统效率,实现更有效的多用户复用,还可以最小化干扰。我们还可以针对设备进行定制,实现更低开销的反馈。

并且,由于用户是移动的,而CSI的反馈需要时间,可能到达基站时就已经因为信道状态变化而成为了无用信息。因此,基于AI/ML的CSI反馈增强还可以采用设备端的AI模型来改善CSI预测。

来源:Qualcomm.com:Towards an AI-native communications system design

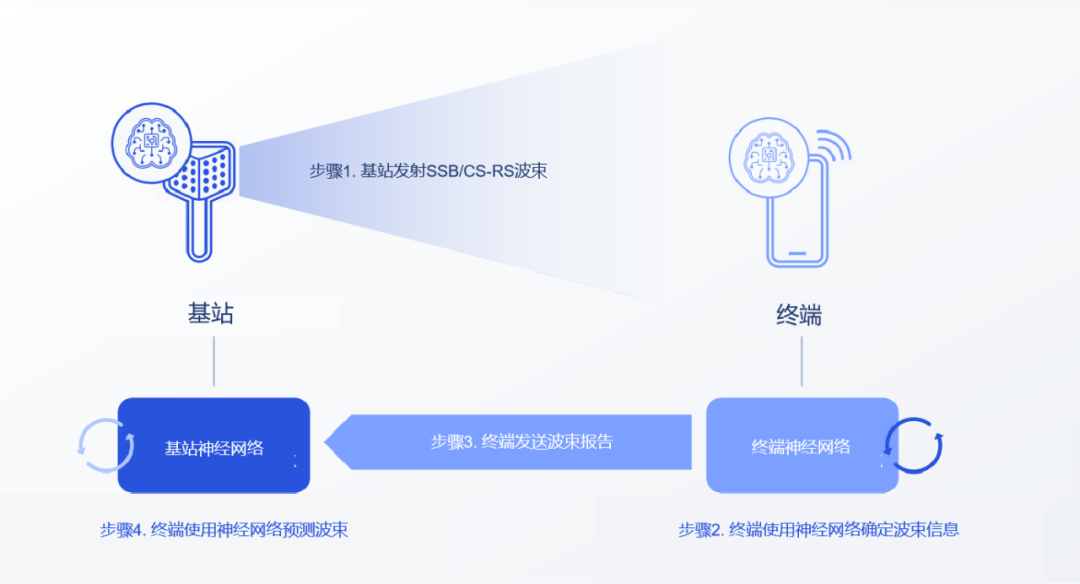

波束管理增强:毫米波的波长短,传播损耗大,极易被遮挡。为了补偿路损,基站一般要使用超大规模的天线阵列来实现波束赋形增益。但为了最大化利用这些窄波束,我们需要良好的算法来选择并保持发射和接收端最佳对准的波束对。

然而,当设备快速移动时,信道状态瞬息万变,保持波束最佳对准是非常困难的,我们还需要多个窄波束来实现最佳覆盖。因此,从众多波束中搜索并跟踪最佳波束变得更加困难。在这种情况下,我们需要引入AI来提升性能。

来源:Qualcomm.com:Towards an AI-native communications system design

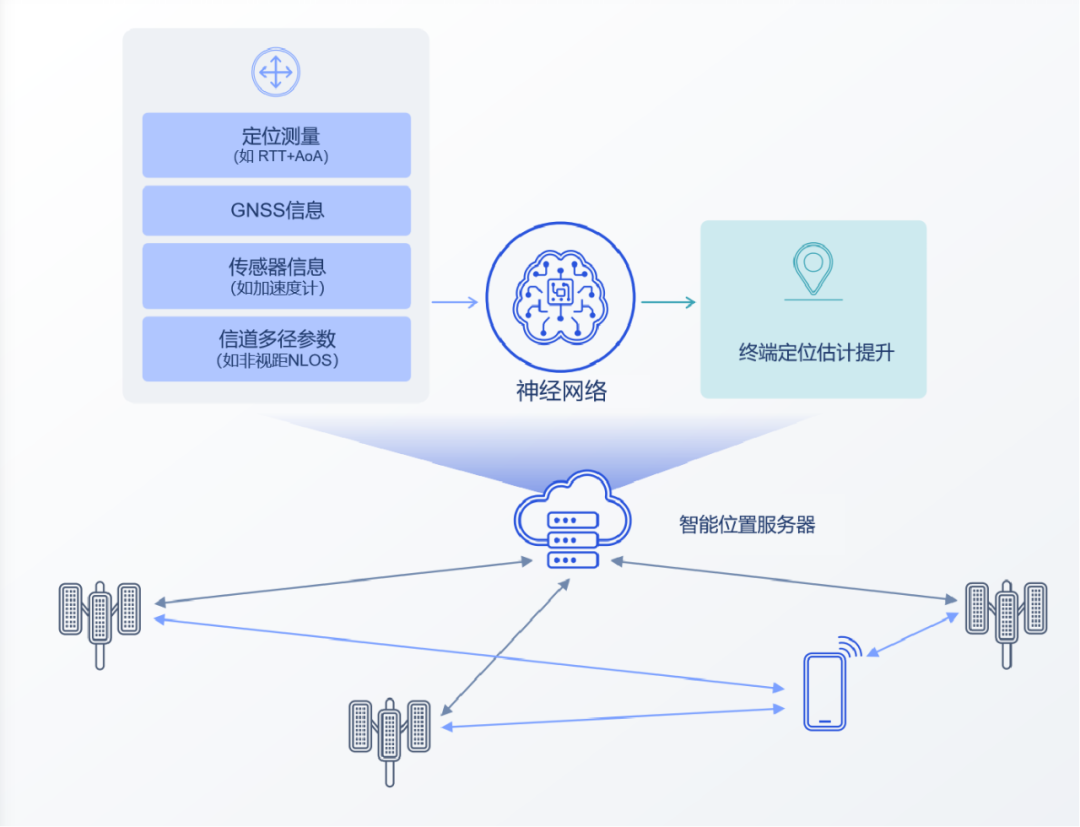

定位精度增强:在复杂的城市环境中,传统的定位方案可能会由于建筑密度和多径干扰等因素而精度不佳,需要引入AI,综合多维信息来提升精度。AI还可以适应环境的变化,并帮助我们在信号传播受阻的情况下进行定位,如卫星或基站信号被遮挡。

来源:Qualcomm.com:Towards an AI-native communications system design

后续的R19将研究新的AI/ML用例。例如,为了实现快速适应和分布式学习,AI/ML的数据和模型可能会直接在设备之间共享,而不需要经过5G网络。这就需要进一步研究隐私保护以及能耗降低等问题。

此外,对于分布式学习,在标准制定上还需要考虑更多。比如,如何处理设备进出覆盖区域、电量有限、设备间卸载计算等场景,并在AI/ML模型准确度、模型生成延迟、功耗约束、计算能力等因素之间权衡。

再往后,我们离6G的标准化就近在咫尺了。在当前的6G愿景中,“AI与通信融合”六边形的顶点之一。AI将成为网络底层架构的一部分,从之前的外挂式走向AI原生。

邬贺铨院士曾经指出,6G应聚焦在如何利用AI分析信道特性实现干扰消除、优化能效和核心网对业务的智能化适应上。这不仅是当前5G-A阶段正在做的,更是6G应该与生俱来的基础能力。

作者 / 蜉蝣采采

— END —

参考资料:

Linkedin:AIin 5G Use Case - Summary of 3GPP's Work & Study on AI/ML for 5G System;

Samsung Rearch:First Light of the AI/ML Empowered RANin 3GPP;

Qualcomm.com:Towards an AI-native communications system design;

Sharetechnote.com:5G/NR - AI/ML.

来源:无线深海

编辑:鱼非我

转载内容仅代表作者观点

不代表中科院物理所立场

如需转载请联系原公众号

鲁公网安备37020202000738号

鲁公网安备37020202000738号