本文由「Light科普坊」出品

撰稿:焦述铭

审稿:左超

众所周知,如今人工智能(AI)功能非常强大,高算力软硬件再配合上无处不在的摄像头作为自己的眼睛,分辨一张图片中动物是猫还是狗,在茫茫人群找到某个目标,都早已不是难事。在图像分类识别和图像目标检测等任务中,准确率几乎达到“百发百中”的程度,甚至很多时候超过了真人。通过人脸识别和大数据,AI视觉系统不仅可以知道“你是谁?”,还很可能猜测出来“你从哪里来?”,“你要到哪去?”。对于这些直击灵魂的“哲学终极三问”,你不必说一句话,AI已经“心中有数”。

如果一个人不希望被铺天盖地的AI视觉系统所察觉,有没有什么好办法呢?

用头套和面罩把自己的脸遮挡地严严实实的,把摄像头砸坏了,或者把计算机电源线拔了?这些莽撞愚蠢的做法,只会起到欲盖弥彰的效果,反而主动暴露了自己,真正的高招是瞒天过海,暗度陈仓,不动声色把AI给骗了。可现在的AI越来越聪明,“猴精猴精的”,还能轻而易举被人给骗了?其实欺骗AI不仅可行,还有很多种黑客攻击办法。

目前以深度神经网络模型为代表的AI系统虽然可以出色地完成很多任务,但内部结构像个黑箱,研究者也没有完全搞清楚其中的机理。这样复杂的系统难免有各种漏洞(bug),只要抓住其中某一个,直击要害,就可以把AI捉弄得团团转。就如同人的双眼会产生各种视错觉一样,AI视觉系统也经常有“看走眼”的时候。

即使一个AI系统平时表现甚佳,也会因为被“整蛊”,变得彻底发挥失常,丢人现眼,出尽洋相。AI系统好比一个发挥不稳定的学霸,考试中可以轻松应对压轴难题,却也会莫名其妙地出现低级失误,回答不出“送分题”。如果只对一张图片做出微不足道,甚至难以察觉的更改,诱导AI视觉系统做出错误判断,称为对抗样本攻击。

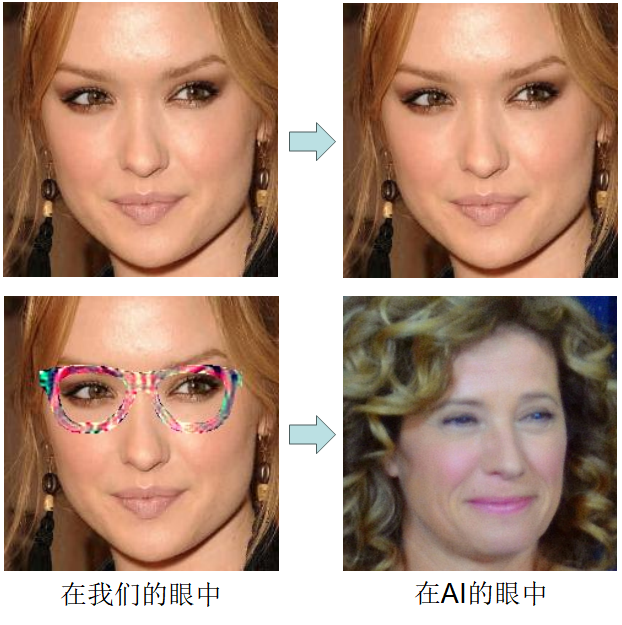

对于手机电脑上的电子图片,使用者可以任意更改其中每个像素的数值,给图片内容改头换面非常容易。难点在于,一方面做出的更改要尽可能无踪无影,不容易被看出,另一方面所做出的更改要足以触发AI系统的漏洞,误导生成错误的输出。不过目前已有很多不惧艰险的优化算法,可以生成这种被称为对抗样本的图片。下图展示的就是AI视觉系统遇到电子“图骗”攻击之后的种种奇葩表现。

不得不说,在遭受对抗样本攻击之后,AI的眼力实在不敢恭维,“睁着眼睛说瞎话”,图像的识别结果都是些胡言乱语,表现大失水准。AI系统除了可以给出结果外,还会给出对应的置信度,表示自己对于结果正确程度抱有多高百分比的信心,可偏偏这些误判结果的置信度数值都相当高,不是99%就是100%,看来此时的AI视觉系统还很“普信”,明明表现很普通,却还那么自信。

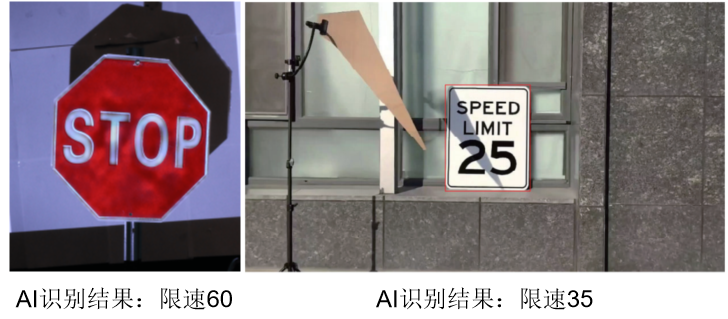

如果说对于电子图片,实施的是魔法攻击,那么对于现实中的物体,就需要实施物理攻击了[4]。简单一点的物理攻击方式就是在人脸、交通标志或者别的什么物体上,贴上一个小标签,画上几笔线条,当然所做的更改同样是精心设计过的,就可以让AI视觉系统失灵。

图2:通过贴小标签的简单方式迷惑AI视觉系统[4]

千万不要小看了这种恶作剧,图中的“停车”交通标志牌会被AI误认作“限速45”,如果自动驾驶汽车真的被这样的标志所欺骗,发生交通事故,车毁人亡都是可能的,AI视觉系统的这种漏洞值得认真对待。

图3:一个女孩戴上特殊镜框后,就会被AI识别为另一个不同女孩[5]

一般来说,某个人的长相要是可以被AI视觉系统认出来,那他戴上眼镜,很大概率还是可以照样被认出来。不过戴上以上这副特殊“眼镜”就不一定了,这种假眼镜没有镜片,只有镜框,镜框的彩色装饰图案也很另类,外表看似一件当代艺术作品,实际是根据AI模型的缺陷“独家定制”的,可以让AI视觉系统感觉“判若两人”[5]。

对于实物的对抗样本攻击当然也离不开光学手段,利用投影仪在物体表面投影干扰光图案就是一个简单有效的方法[6],而使用随处可见的影子作为攻击方式[7],看起来则更自然,隐蔽性更强,只是需要把遮挡物体摆放到恰当位置,让影子成为所需的样子。

图4:利用投影仪(左)和物体自然影子(右)的光学对抗样本攻击[6,7]

如今智能手机的照相功能越来越先进,拍摄出照片和视频越来越清晰,哪怕一款低配置的手机拍照质量也基本可以让人满意,但数码照相设备和人眼各自所忠实记录的真实世界,其实是有差别的。不仅AI软件系统本身是有漏洞的,作为AI视觉输入的相机和摄像头同样有漏洞,通过在拍摄环节“做手脚”,人眼看起来再正常不过的物体,在图像传感器上却会被转换为一张张奇奇怪怪的照片,进而误导AI的判断。

要想欺骗相机,第一招是利用人眼与相机传感器频谱的差异。红橙黄绿青蓝紫各种不同颜色的光都被称为可见光,是因为它们在人眼的视觉范围内,可以被看到,而比红色光波长更长的红外线,比紫色光波长更短的紫外线,在人眼中都是隐形不可见的。普通手机和相机的传感器可以接收光信号的频谱范围大致和人眼类似,可又不完全一样,往往可以探测到一定波长的人眼看不到的红外线。

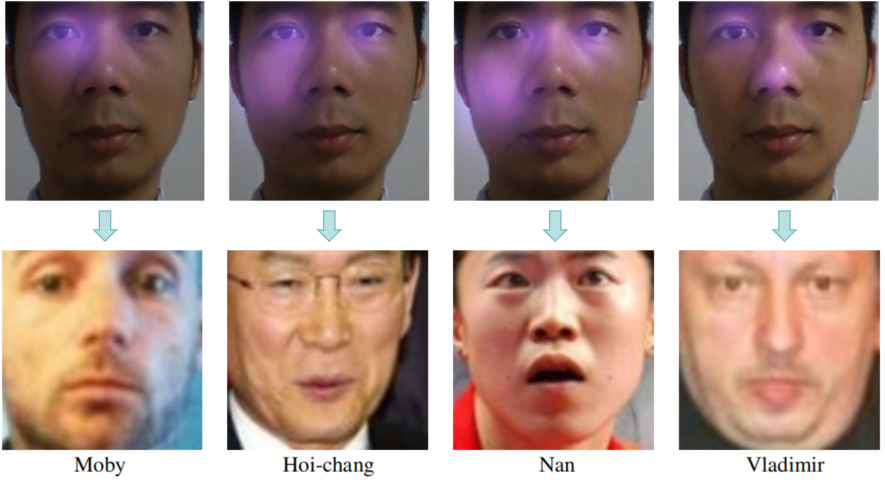

图5:诡异的红外光让AI总是认错人:相机拍到的图片(第一行)和识别结果(第二行)[8]

有研究者通过一个红外线LED灯,把经过设计的不同光分布图案找到人脸上,无论怎么照,在真人观看者眼中没有任何异常,可是在拍出的照片中,脸上总是有紫色的一块区域,这样就会诱导AI人脸识别系统产生“脸盲症”表现,把同一个人误看成多个不同的人[8]。而用于网上支付的正常纸质二维码,经过百米之外红外激光的照射,在手机摄像头眼中,可以变为完全不同的另一个二维码,在不被留意的情况下,成为恶意网站链接的入口[9]。

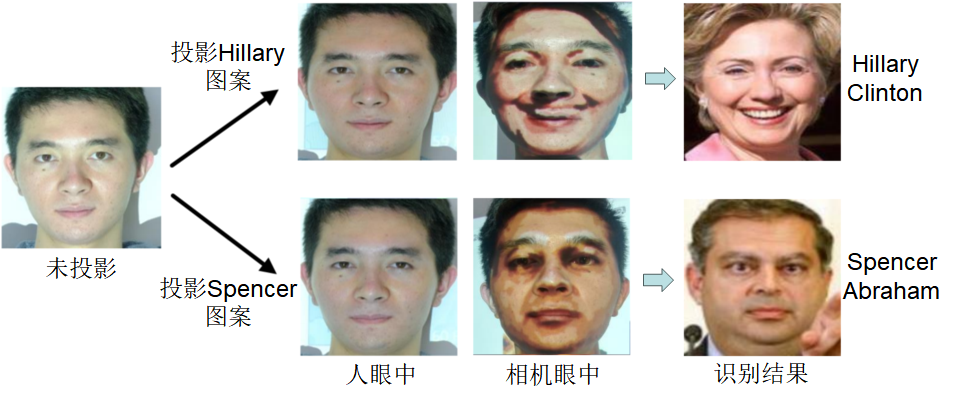

图6:在一组快速交替的投影图案照射下,人眼中还是那张脸,可相机眼中是完全另外一幅“浓妆淡抹”的模样[10]

第二招是利用人眼独特的颜色融合机制。当红色光和绿色光快速交替展示时,比如每秒60张,由于闪烁过快,人眼将难以分辨,看到的只会是红色光和绿色光融合后形成的黄色光,而相比之下,图像传感器则更加明察秋毫,每个时刻记录的或者是红色光,或者是绿色光,并不会是融合后的黄色光。投影仪将包含了伪装目标(比如希拉里)人脸画面的两个图案快速交替投影到现实中的人脸上,真人观看者看到的是两个投影图案中和后的均匀光图案,看上去并没有怎么影响人脸本身的样子,而在手机或相机拍到的照片里,出现的却是一个被投影图案高度扭曲的人脸,会被识别为投影图案中的人。这相当于用投影仪给人脸“浓妆淡抹”一番,不过妆容是若隐若现的,只要不通过相机观看,化的妆就被自动卸掉了[10]。

第三招是利用图像传感器卷帘快门的缺陷。人眼中的视网膜相当于相机中的传感器,都是用于记录图像光信号。不过区别在于,视网膜记录整张二维图像的时候,是同步进行的,比如看一张人脸的时候,耳朵眼睛鼻子嘴都是同时看到的。但很多相机传感器不是这样,采取一种称为卷帘快门的逐行扫描方法,单张图像的光信号也是一行一行分开记录的,耳朵眼睛鼻子嘴因为位置不同,并不是同步记录下的,而是有微小的时间差。这样通过明暗快速交替变化的灯光,恰好遇上相机传感器正好记录图像中某一行光信号的时候,光是暗的,拍到的照片中就会出现一条黑线[11],最后整个画面就成了斑马的模样。而对于人眼来说,由于灯闪烁得实在太快了,完全感觉不到灯在闪烁,看到的图中更不会有黑线。

图7:卷帘快门效应使得相机在快速闪烁灯光下拍到的照片中有一条条黑线或者彩色条纹[11、12]

而如果我们使用红绿蓝三种不同颜色的灯光[12],并且更加精细地计算每种灯光各个短暂时刻的开启和关闭状态,照片上出现的不再是简单的黑线,而是彩虹一样的彩色条纹。无论黑线和彩色条纹,都可以迷惑AI系统,使它无法正常工作。

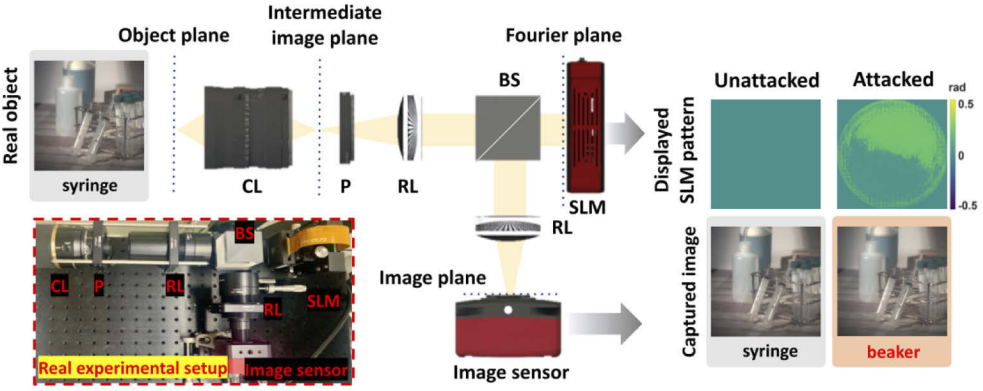

除了利用现成相机传感器的缺陷,研究者也尝试了更主动的攻击方式,就像在特洛伊木马中隐藏士兵一样,在正常相机的成像系统光路中额外添加一个处理模块,这个模块能够以光学方式对拍摄的图像光信号进行微小的修改[13]。具体来说,通常情况下物体图像的光信号通过相机透镜之后,会直接投射到图像传感器上。但这个不普通的系统中,相机透镜和传感器之间还添加了一个额外的模块,模块里面包括两个透镜和一个空间光调制器,第一个透镜相当于以光场传播模拟了对图像进行傅里叶变换,然后用空间光调制器调整变换结果的相位,再通过另一个透镜,进行傅里叶逆变换。经过这个特殊模块处理后的图像会和正常相机的拍摄结果稍微不同,“魔鬼就存在于细节之中”,输入中巧妙设计的微小改变足以扰乱一个AI系统的正常运行。

图8:一个嵌入了用于生成对抗样本图像的光学处理器的相机系统[13]

当然,面对各种对抗样本攻击,AI视觉系统的设计者也不是束手无策,两者是矛与盾的关系,矛越锋利,盾也会更坚固。近年来,研究者经常举办全球范围内的人工智能对抗样本攻防竞赛,参赛者可以在模拟的场景中相互切磋,聚集在一起华山论剑[14]。“魔高一尺,道高一丈”,AI视觉系统抵御对抗样本攻击的能力也在日益提升,随着各种漏洞的填补而变得愈加完善。

参考文献

[1] I. J. Goodfellow, J. Shlens, and C. Szegedy, Explaining and Harnessing Adversarial Examples, arXiv:1412.6572 (2014)

[2] Y. Dong, F. Liao, T. Pang, H. Su, J. Zhu, X. Hu, and J. Li, Boosting Adversarial Attacks with Momentum, 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR 2018), 9185-9193 (2018)

[3] H. Ye, X. Liu, and C. Li, DSCAE: a denoising sparse convolutional autoencoder defense against adversarial examples, J. Ambient. Intell. Human Comput. 13, 1419–1429 (2022)

[4] J. Fang, Y. Jiang, C. Jiang, Z. L. Jiang, S.-M. Yiu, and C. Liu, State-of-the-art optical-based physical adversarial attacks for deep learning computer vision systems, arXiv: 2303.12249 (2023)

[5] M. Sharif, S. Bhagavatula, L. Bauer, and M. K. Reiter, Accessorize to a Crime: Real and Stealthy Attacks on State-of-the-Art Face Recognition, In Proceedings of the 2016 ACM SIGSAC Conference on Computer and Communications Security (CCS '16), 1528–1540 (2016)

[6] A. Gnanasambandam, A. M. Sherman, and S. H. Chan, Optical Adversarial Attack, arXiv:2108.06247 (2021)

[7] Y. Zhong, X. Liu, D. Zhai, J. Jiang, and X. Ji, Shadows can be Dangerous: Stealthy and Effective Physical-world Adversarial Attack by Natural Phenomenon, 2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), 15324-15333 (2022)

[8] Z. Zhou, D. Tang, X. Wang, W. Han, X. Liu, and K. Zhang, Invisible mask: practical attacks on face recognition with infrared, arXiv:1803.04683 (2018)

[9] 《纸质二维码也能隔空篡改:百米之外无痕攻击,秒变恶意网站入口》,量子位微信公众号,https://mp.weixin.qq.com/s/mNB-4mAfFCtcNtvSUW3x5Q

[10] M. Shen, Z. Liao, L. Zhu, K. Xu, and X. Du, VLA: a Practical Visible Light-based Attack on Face Recognition Systems in Physical World, Proc. ACM Interact. Mob. Wearable Ubiquitous Technol. 3(3), 103 (2019)

[11] Z. Chen, P. Lin, Z. L. Jiang, Z. Wei, S. Yuan, and J. Fang, An Illumination Modulation-Based Adversarial Attack Against Automated Face Recognition System, In Information Security and Cryptology: 16th International Conference (Inscrypt 2020), 53–69 (2020)

[12] A. Sayles, A. Hooda, M. K. Gupta, R. Chatterjee, and E. Fernandes, Invisible Perturbations: Physical Adversarial Examples Exploiting the Rolling Shutter Effect, 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), 14661-14670 (2020)

[13] K. Kim, J. Kim, S. Song, J.-H. Choi, C. Joo, and J.-S. Lee, Engineering pupil function for optical adversarial attacks, Optics Express 30(5), 6500-6518 (2022)

[14] 张子豪,《神经网络太好骗?清华团队如何做到打NIPS攻防赛得3冠军的》,程序员好物馆微信公众号,https://mp.weixin.qq.com/s/k0dCmIhwMsqvsR_Fhhy93A

监制:赵阳

编辑:赵唯

来源:中国光学

编辑:Sdk

鲁公网安备37020202000738号

鲁公网安备37020202000738号