每经记者:文巧 每经编辑:兰素英

3月18日,马斯克旗下大模型公司xAI兑现诺言,正式对Grok-1大模型开源。随后在X平台上,马斯克还不忘嘲讽OpenAI一番,“我们想了解更多OpenAI的开放部分”。

据悉,Grok-1模型参数大小为3140亿,是迄今为止业界开源参数最大的模型。

马斯克的开源举措引发了业界的广泛关注和热烈讨论。表面上,这一举动像是针对OpenAI的一记“回击”,但从更深的层次来看,还隐藏着马斯克的战略谋划和考量。

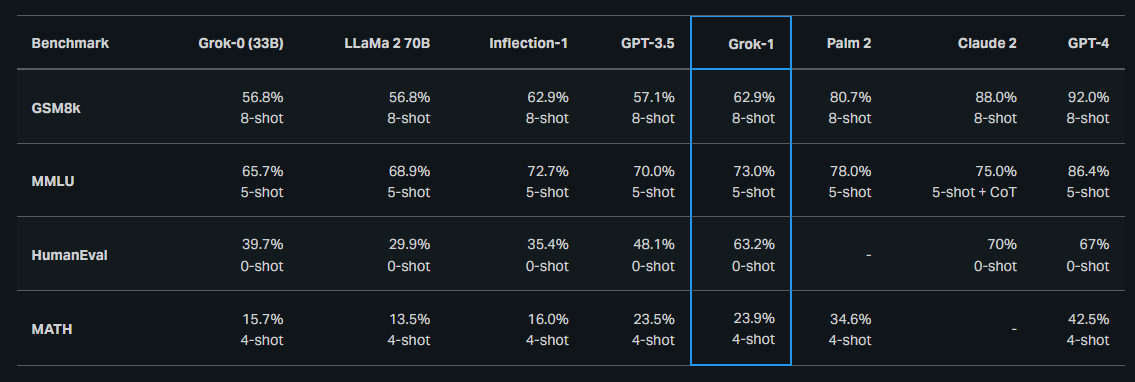

据xAI去年公布的文档,尽管Grok-1在各个测试集中呈现的效果要比GPT-3.5、Llama2要好,但距离Palm-2、Claude2和GPT-4仍然差了一大截。

因此有分析认为,在强敌环伺,且Grok难以匹敌顶尖大模型的情况下,马斯克选择开源是必然之举,其考量之一可能是将模型迭代进化的任务交给社区。

开源还是闭源,一直是AI浪潮之下一个极具争议性的话题。有AI专家此前在接受《每日经济新闻》记者采访时认为,开源已是大势所趋。从商业角度来看,开源不仅能够避免少数财力雄厚的科技公司控制前沿模型,对于AI创业者来说,也进一步降低了门槛和成本。

马斯克的“阳谋”:让开源社区迭代模型

3月18日凌晨,马斯克旗下大模型公司xAI宣布正式开源3140亿参数的混合专家(MoE)模型Grok-1以及该模型的权重和网络架构。截至发稿,在Github上,该开源项目已经揽获31.6k星标,足见其火爆程度。

图片来源:Github

值得注意的是,这是迄今为止业界开源参数最大的模型,超过GPT-3.5当时1750亿的参数量。

DeepMind工程师Aleksa Gordié预测,Grok-1的能力应该比Llama2要强,但目前尚不清楚有多少数据受到了污染,二者的参数量也不是一个量级。

从Grok-1的模型细节来看,值得注意的一点是,该基础模型基于大量文本数据进行训练,没有针对任何具体任务进行微调。而在X平台上可用的Grok大模型就是微调过的版本,其行为和原始权重版本并不相同。也就是说,xAI目前开源的Grok-1模型并不包括X平台上的语料。

据xAI去年公布的文档,从Grok-1的整体测试效果来看,Grok-1在各个测试集中呈现的效果要比GPT-3.5、70亿参数的Llama2和Inflection-1要好,但距离Palm-2、Claude2和GPT-4仍然差了一大截。

图片来源:xAI

基于此,有分析认为,马斯克开源Grok-1的一个考量是,尽管该模型表现尚可,但“比上不足,比下有余”,并未具备打败顶尖模型如GPT-4的能力,更别说未来的GPT-5。

在大模型角逐的当下,尽管Grok依托X平台的数据,但其无论是在能力上,还是知名度上都不具备与OpenAI、谷歌、Anthropic等公司匹敌的优势。尤其是今年以来,谷歌发布了Gemini,Anthropic发布了Claude3,大型语言模型的竞争更加激烈,在这样的情况下,马斯克选择开源路线也是必然之举。

模型开源让研究者和开发者可以自由地使用、修改和分发模型,打开了更多开放合作和创新的可能性。因此,一次性开源可以将迭代进化的任务交给社区。

正如月之暗面CEO杨植麟在此前接受腾讯采访时表示,“如果我今天有一个领先的模型,开源出来,大概率不合理。反而是落后者可能会这么做,或者开源小模型,搅局嘛,反正不开源也没价值。”

再加上马斯克频繁讽刺OpenAI并不Open,外媒Venture Beat认为,Grok-1的开源显然对他来说也是一个有益的立场。

不过,针对让社区来实现迭代这一目的,有业内人士在X平台表示,Grok-1的问题可能是模型参数太大,这需要巨大的计算资源,所以开源社区可能无法对Grok-1进行迭代。

另有评论认为,Grok-1没有对特定任务进行微调,这提高了用户使用它的门槛。AI工具饱和的市场可能更需要针对特定用例的工具。

开源乃大势所趋,初创公司迎来新机会

开源和闭源是当前AI浪潮之下的一个极具争议性的话题。

纽约大学坦登工程学院计算机科学与工程系副教授Julian Togelius在此前接受《每日经济新闻》记者采访时曾认为,开源是业界大势所趋,Meta正在引领这一趋势,其次是Mistral AI、HuggingFace等规模较小的公司。谷歌今年2月罕见地改变了去年坚持的大模型闭源策略,推出了“开源”大模型Gemma,似乎也是对Togelius言论的验证。

从技术视角来看,开源代码可以提高透明度并有助于推进技术发展,也能帮助了解模型弱点,这样才能更好地部署模型,从而降低风险。另一方面,也有不少反对开源的一派认为,开源AI会被不良行为者操纵从而造成风险。

从商业角度来看,Julian Togelius认为开源对防止权力集中很重要,能够避免少数财力雄厚的科技公司控制前沿模型。此外,还有分析认为,对于创业者来说,开源大模型则进一步降低了创业门槛,降低了大模型的开发成本,让更多创业者在基础模型方面处于同一起跑线上。

例如,目前许多开源模型都是基于Meta的开源模型Llama2而开发。据报道,截至2023年底,HuggingFace上开源的大模型排行榜前十名中,有8个是基于Llama2打造的,使用Llama2的开源大模型已经超过1500个。

Grok-1的权重和架构是在宽松的Apache 2.0许可下发布的,这使得研究者和开发者可以自由地使用、修改和分发模型,这种开源方式可以适应多种不同的任务和应用场景,更适合那些想要用开源模型打造自己专有模型的开发者。因此,有分析认为,Grok-1的开源也是为许多AI初创公司提供了另一个选择。

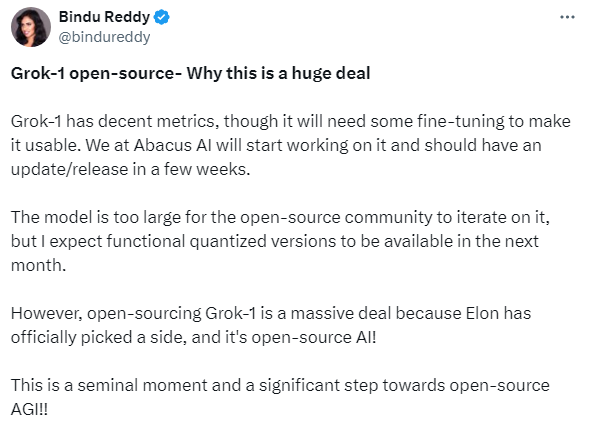

例如,AI初创公司Abacus AI的CEO就在X平台上表示,将开始研究Grok-1,并在几周内进行更新/发布。

图片来源:X平台

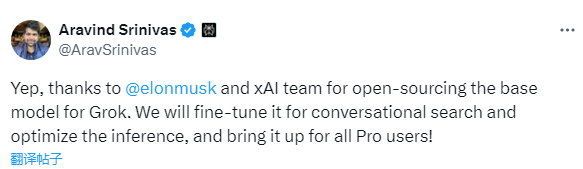

对话搜索引擎公司Perplexity CEO Aravind Srinivas也在X平台上发文称,将会基于Grok的基础模型进行对话式搜索和推理的微调。

图片来源:X平台

随着开源力量的不断壮大,马萨诸塞大学洛厄尔分校计算机科学教授Jie Wang曾对《每日经济新闻》记者表示,未来各个主要参与者可能都倾向于采用半开源的方式,类似Meta开源Llama2系列大模型的方式,即开源模型的某些部分,以便研究人员和开发人员了解模型的架构和训练过程,但保留最重要的部分,例如用于训练和预训练模型权重的完整数据集。

Grok-1走的也是这样的路线。

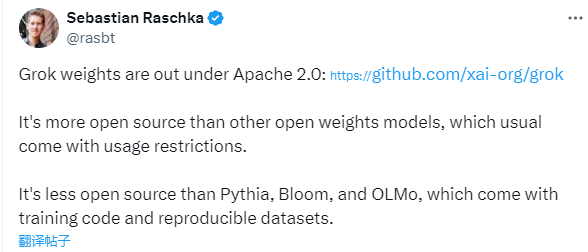

知名机器学习研究者Sebastian Raschka认为,“尽管Grok-1比其他通常带有使用限制的开放权重模型更加开源,但是它的开源程度不如Pythia、Bloom和OLMo,后者附带训练代码和可复现的数据集。”

图片来源:X平台

每日经济新闻

鲁公网安备37020202000738号

鲁公网安备37020202000738号