文 | 思辨财经

自2022年11月ChatGPT问世,这一现象级产品迅速点燃了市场的大模型热情。新老科技企业纷纷杀入,誓要抓住移动互联网以来最大的一次产业红利。当行业如火如荼发展一门心思搞技术之时,又出现了“路线之争”:

闭源路线:以国外OpenAI的ChatGPT,Anthropic的Claude,谷歌的Gemini,国内百度的文心一言,月之暗面的Kimi等企业为典型代表,倾向于闭源大模型的高性能,强商业化等优势,其中以百度最为激进,李彦宏近期便一直以“闭源拥趸”频频出圈,发表诸如“开源大模型是智商税“,”大模型场景下开源是最贵的”等出位言论,引发行业热议;

开源路线:以META的Llama,国内阿里云的通义为典型代表,认为开源模式的协作特性可实现技术的快速迭代,可以通过模型托管提高云计算的业务成长空间,且该路线有利于数据敏感型组织通过私有云或本地化内网落地大模型,较之闭源具有高成长性,多落地场景等优点。

与行业往日争议不同,此次大模型争论充满技术情怀,从业者争论多聚焦在 “技术之争”,李彦宏就表示“开源模型会越来越落后”,其让频频登上热搜。

那么在这场开闭源的争论中我们要建立怎样的分析框架?又来如何理性评判当前的路线之争呢?

其一,根据Scaling laws原理,大模型的成功乃是更大算力,更多数据,更高算力的综合结果,这背后则是资金的海量投入,基础设施完善,管理的稳定等等,大模型没有闪电战只有持久战;

其二,百度选择闭源有技术的考量,但与商业路径也密不可分;

其三,开源大模型并没有想象那般弱鸡,闭源也不一定能永远保持先进性;

其四,开闭源大模型共存将会是长期趋势;

Scaling laws原理:大模型将长期烧钱

我们首先从大语言模型中的第一性原理“Scaling laws”入手分析(被翻译为“缩放原理”或“尺度定律”)。

2020 年 1 月,OpenAI 发布论文《Scaling Laws for Neural Language Models》,奠定了 Scaling Law的基础,为后续 GPT 的迭代指明了方向:更大参数、更多数据和更多算力能够得到更好的模型智能。

也就从此时开始,OpenAI开启了大参数模型路线,GPT-3的参数已经达到1750亿(GPT-2还只有15亿),训练数据则直接跃升到570亿G。

大模型的大参数军备竞赛也由此拉开大幕,动辄数千亿级的大模型流行于市场,带来技术的快速发展和普及。

由此也就引发了一个新的问题:算力。

根据 Scaling Law 论文,可以用 6ND 来估算模型所需要的训练算力(N为参数,D为数据集TOKEN数),算力需求在大模型时代得到指数级提升(长文本大模型所需算力可能还要高于6ND)。

这一方面催生了底层算力提供者英伟达为代表的GPU厂商的爆炸式增长,另一方面大模型厂商若要保持技术先进性就必须花大价钱在算力基础设施方面。

在华泰证券的图表中我们也能清晰看到大模型与此前的云计算爆发式增长一样,业务的增长是要基础算力的高投入为前提的。根据Visible Alpha一致预测,2026年全球科技四巨头(微软,谷歌,META和亚马逊)合计资本支出将达2399亿美元,2023-2026年CAGR为18.86%。

有观点曾寄希望于Scaling Law的边际效应收窄效应,认为只要熬到技术成熟期(Scaling Law效应边际效应迅速放大之时),算力的投入便会达峰,此时模型只需要维护自身模型的可靠性与稳固性即可,只是站在当下时代,Scaling Law远未到终点。

清华大学的唐杰教授在2024年 2 月就指出:我们还远未到 Scaling law 的尽头, 数据量、计算量、参数量还远远不够。未来的 Scaling law 还有很长远的路要走。

现实中主流大模型厂商的算力仍然在持续增大,模型的参数规模也在增大,行业终局是看不到头的。

研发人员固然可以通过技术架构优化和软硬件资源协同等方面来提高大模型的性能,只是我们也必须得承认,指数级的大模型技术迭代仍然仰赖于高参数和强算力。

在上述两项约束条件下,大模型厂商不得不面临非常棘手的问题:

如果把算力的资本性支出视为“蛋”,大模型的高性能为“鸡”,究竟鸡生蛋还是蛋生鸡就成了大模型厂商不得不面临的问题。

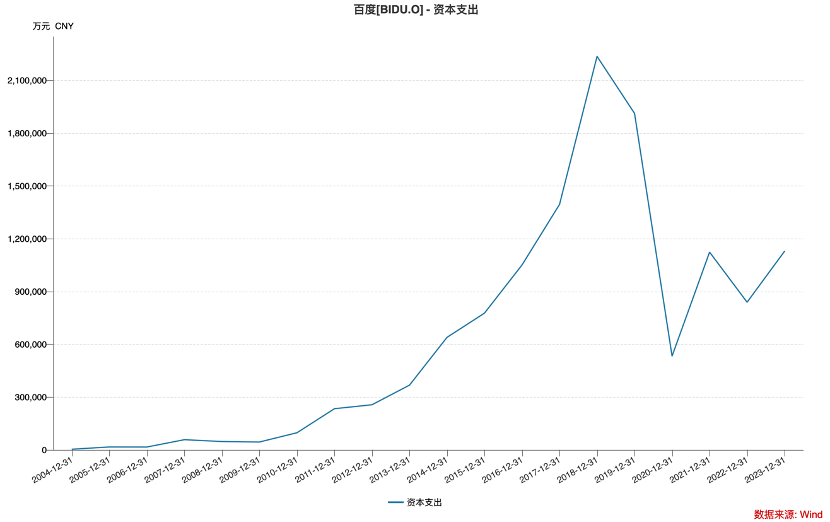

我们以闭源大模型的忠实拥趸百度为例,在基石的广告业务压力不断加码之时,其经营理念已经越加审慎,如对非核心业务的裁撤,人员的优化等等。这在资本开支中则反馈表现为支出的越加保守,过去三年表现非常明显。

2023年META和亚马逊等科技头部企业也均在进行资本支出的结构性优化,如亚马逊的物流仓储成本开始降低,与此同时云计算的数据中心等基础设施仍处于大规模扩张中。百度亦是如此,表面看其资本开支越发慎重,但大模型相关的基础设施投入必然是高速增长的。

这对百度也就会带来一个问题,结构化的资本开支缩减终有结束之时,Scaling Law还远未能看到终端,加之“第二曲线”短期内无法扛起支出重任,从财务方面就迫使百度不得不在商业路径上进行考虑。

以卖模型(API接口)的闭源大模型成为首选,对C端用户文心一言收取会员,对B端以API的接口费为主要变现,又由于闭源大模型乃是企业独家开发,维护和管理成本也相对低廉,对百度是十分划算的。在鸡生蛋和蛋生鸡的问题上,百度选择了鸡生蛋。

可闭源果真就能战胜开源吗?

开源大模型不弱鸡

前文中我们已经从大模型的原理,技术以及商业路径角度,简单勾勒了行业当前的现状,并对百度对闭源大模型抱以极度的热忱有了一定的理解。

接下来我们来讨论开闭源大模型的趋势性问题 。

如开篇所言,李彦宏对开源大模型常有鄙夷之情,如开篇“开源模型会越来越落后”,又如“没有应用,开源闭源模型都一文不值”,闭源大模型果真如此不堪吗?

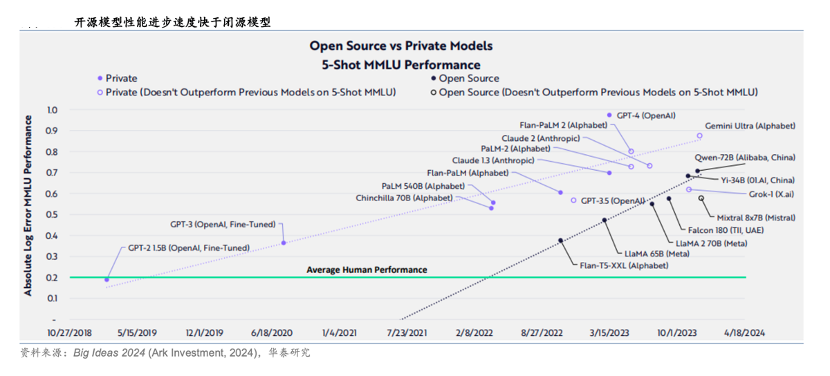

ARK Investment每年都会将其观点和洞察力发表在年初的“Big Ideas”报告中,在2024年的报告中,”开源模型性能进步快于闭源模型“乃是其重要观点之一。在上图中阿里云的Qwen-72B乃为闭源大模型之最。

一方面闭源大模型确实有先发优势,以OpenAI的ChatGPT为典型代表,但另一方面大模型的演进又是一个持久战(Scaling law为主要因素),对企业的管理,投入以及持续的创新力就有了更高的要求,如此前OpenAI一系列的“人事斗争”很难说不会影响核心业务。

与之所对应的开源大模型也在此时开始展示先进性。

2024 年 4 月,Meta 发布 Llama 3,设计目标是多模态、多语言,根据 Meta 公布的目前训练数据,其性能与 GPT-4 相当。

Llama大模型的成功给了开源阵营足够的信心,在权威机构推出全新的大模型测评基准LiveBench AI中,阿里通义Qwen2拿下美国最新测评榜单开源大模型全球第一,成绩超过Meta的Llama3-70B模型。

在基础算力的投入保障之下,拉长时间线,开源大模型是可以保持足够竞争力的,仅就此来看李彦宏鄙夷开源大模型性能不进步是站不住脚的。

这再次告诉我们:闭源和开源绝非技术理念之争,而是商业路径的分歧。

那么究竟哪何种商业路径最适合大模型的落地呢?

篇幅原因我们省去繁琐的分析过程,精简观点如下:

中短期:闭源大模型在变现方面优势更明显,以卖模型为主要商业模式,简单易操作。百度又可以通过改造原互联网应用产品(如地图,文库,搜索等),实现模型的落地改进产品力,将业务线由“AI+”向“+AI”过渡。此外需要提醒的是,企业内部原产品线的改造也是伴随巨大的成本开支需求的,如华泰证券曾测算,META若内容推荐完全以大模型为主,取代原有算法,将需要至少50万片英伟达GPU,仅此一项就是一笔巨大开支(最近有消息称META今年GPU规模将超过30万块),这就对短期内闭源大模型的落地和变现提出了更高的要求。

长期:开源大模型走的更远,如高度定制化的特点将提高大模型对不同行业的渗透率,当不同行业的接入大模型,提高大模型的应有广度之后,企业开发展则要仰赖于开源大模型背后的算力和云计算平台,以实现可持续增长。

在上述两种路径中,“资本”是商业模式运转的必要条件,这又回到了我们前文所言的“鸡生蛋”的悖论。

这也就使得采取闭源大模型的往往具有以下特点:应用端具有得天独厚优势(如谷歌),又如技术上短期内遥遥领先(如OpenAI);

开源大模型则具有:资金底子雄厚(如META),云计算基础设施健全(如阿里云),能够熬得住,扛得起基础设施膨胀带来的巨大成本,又能接得住开源大模型普及后的云计算需求。

显然没有一种大模型是兼有所有优点而无缺点的,百度此时以激烈语言来鼓吹闭源大模型,其背后应是其短期商业化的焦虑(此前API接口价格战对闭源大模型影响更大),以及对争夺目标客户心智的野心。

基于此我们并不认为会有包打一切的大模型路径,相反企业选择适合自己的路径更多是“权宜之计”,客户选择开闭源模式也将会有自己的考量,一些企业也采取开闭源共存的模式来满足不同客户需求,如谷歌将轻量级的开源模型系列Gemma进行开源。

不过此时发表出格语言最能出圈,能够提高闭源大模型优点的普及型,只是忽视了开源大模型绝非“弱鸡”,大模型的发展会是持久战,未来有太多的不可测性,轻易下断言在其后很可能被反噬。

鲁公网安备37020202000738号

鲁公网安备37020202000738号