在人工智能的语境中,“开放(open)”一词没有公认的定义,并且被应用于差异很大的产品,几乎没有稳定的含义。

译自 How Should We Define 'Open' AI?,作者 David Cassel。

国家信息标准组织的官方网站解释说:“我们的愿景是一个所有人都能从不受限制的信息交流中受益的世界。”

该组织经美国国家标准协会 (ANSI) 认可,是针对“传统”和新技术的图书馆/出版/书目应用程序的非营利标准组织。

但世界上仍有一个非常重要的标准在发展中:究竟什么是开放人工智能或“开放 AI”?这是一个问题,Archive.org 的副主任 Thomas Padilla 在那年的 NISO Plus 会议的主题演讲中解决了这个问题。

Padilla 向听众承诺:“这是一场关于 AI 的演讲。”

“但就像大多数关于技术的话题一样,最终会变成关于我们自己以及我们想要实现的目标。”

Llama 2 是开源的吗?

虽然开源倡议组织仍在制定其“开源 AI”的官方定义——通过咨询社区流程——但一些重要的区别已经很明显了。

Padilla 认为,开放 AI 应该具有五个特征,他相信“开放”AI 应该是可重复使用的,用户在性能和“更广泛的可重复使用性以及我们社区中的其他人建立底层模型的潜力”之间权衡取舍。

但这在现实世界中是如何发挥作用的?

Meta 的 Llama 2 宣称它是开源的,并且可以免费用于研究和商业用途——但 Padilla “戴上我的图书馆管理员帽子”,审查了其 GitHub 存储库中的许可条款。

在“其他商业条款”中,它警告称,如果被许可人拥有超过 7 亿活跃月度用户,“您必须向 Meta 申请许可,Meta 可以自行决定是否授予您许可。”

否则,“除非或直到 Meta 明确授予您此类权利,否则您无权行使本协议项下的任何权利。”

Padilla 称其为“对其他大型科技公司的一种排斥,在大多数情况下”——尽管 Red Monk 联合创始人 Steve O’Grady 相当明确地表示,这不是纯粹的开源:

有用的澄清,明确了目标。你可以使用它,除非你在谷歌工作,比如。想象一下,如果 Linux 是开源的,除非你在 Facebook 工作。

而这只是多个使用领域限制之一,其中任何一个都意味着它不是开源的。 ——Steve O’Grady (@sogrady)

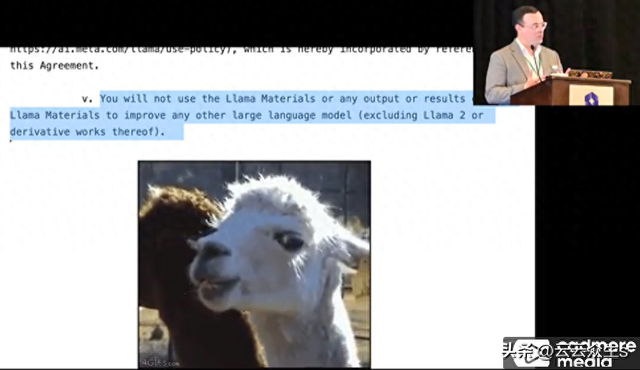

但 Padilla 认为,还有另一个条款更值得“Llama 侧目”。

Padilla觉得非常“…不符合开源的精神。在我看来,它有点——它炸毁了整个事情。这怎么是开源的?它不是!”

但Padilla补充说,“其他模型已经进入市场,我认为它们在与开源精神保持更强一致性方面表现出一定程度的希望……”——具体引用了开放语言模型OLMo。

OLMo 自称是一个“真正的开放 LLM 和框架”,并强调“所有代码、权重和中间检查点都在 Apache 2.0 许可证下发布”。

神秘的答案

Meta 的 Llama 并不是城里唯一的竞争者。

ChatGPT 的开发者甚至将他们的技术命名为OpenAI——Padilla 在这里告诉他的听众,“我也相信 OpenAI 是开放的。”

但仍然有批评的空间。透明度是Padilla对开放性的定义的一部分——它在“知识的完整性”中发挥作用——定义为确保作者和“知识生产者”得到认可。

相反,正如Padilla所见,当今的内容制作者正在被“幽灵化”——要么没有信用“…要么含糊地提到。我认为这是不好的。”

对于当今的大部分生成式 AI,它更像是从一场神奇的降神会中召唤出的神秘答案。“你会得到这样的回答,‘我无法访问我如何向你提供这个答案。’”

Padilla指出,对于经过同行评审的论文来说,这样的回答永远不会被接受:

我问 Chatgpt 其数据有多少来自维基百科:我无法访问我的训练数据,但我接受过互联网上各种数据的训练,包括书籍、网站和其他文本等来源,以发展对语言的广泛理解。

——James (Jim) McTague (@Mctaguej) 2023 年 12 月 8 日

还有另一个问题。2 月份,Fast Company 采访了 OLMo 项目负责人,AI2 高级研究总监 Hanna Hajishirzi,了解 Meta 的模型。他们的结论是什么?这些模型非常有价值,但它们背后的数据仍然不可用。“我们不了解从数据到功能的所有联系,”该杂志指出。

除此之外,“训练代码的详细信息不可用。很多东西仍然隐藏着。”

因此,透明度的另一个方面是良好的文档记录——在这里,Padilla看到了 Hugging Face 的 模型卡 的前景。

当用户将模型上传到 Hugging Face 的工具时,系统会提示他们指定模型的参数以及使用了哪些数据集(根据 Hugging Face 的 模型卡定义)——以及模型的预期用途及其“潜在限制,包括偏差和道德考量”。

Padilla说他“很乐意看到更多人采用这种做法”——并且“甚至可能要求”将它们上传到 Hugging Face。“也许这就在眼前。”

“如果没有透明度,你就无法保证知识的完整性,”Padilla告诉听众。“如果你没有知识的完整性——那么为什么要参与这样的事情?我真认为它削弱了整个事情的价值主张。”

人工智能应该如何承担责任?

此外,Padilla认为,开放人工智能也应该承担很大的责任——这意味着它应该根据特定的社区需求进行开发(和使用)。

对于“责任”,Padilla赞扬了政策、法规和行政命令“试图制定某些保护措施和安全措施来指导人工智能的开发和实施”,包括白宫 10 月份的“ 关于安全、可靠和值得信赖的人工智能的行政命令”。

但Padilla还引用了分布式人工智能研究所(DAIR,由人工智能研究员 Timnit Gebru 创立)在其 研究理念 页面上提出的现实世界责任原则。

他们的目标之一是缩小“研究人员和社区合作者之间的距离”。他们的另一个目标是关注信任和时间,以与社区建立“有意义的关系”。他们特别谈到了少数族裔或边缘化社区,这些社区通常不在人工智能研究的中心,但经常受到未考虑生活经验的人工智能研究的负面影响。

“我认为 DAIR 为我们提供了一份不错的路线图,”Padilla说。

可持续性

Padilla说 开放人工智能应该以“可持续” 的方式采用,并意识到“相互依存、威胁和机遇”。

为此,Padilla提出了三种看待它的方式。为了展示他所说的相互依存的“爆炸”视图,Padilla展示了 2018 年数据可视化,该可视化在纽约现代艺术博物馆展出,(根据其画廊标签)“分析了支撑单个亚马逊 Echo 智能音箱的‘诞生、生命和死亡’的庞大网络”。(它从元素周期表开始,Padilla告诉听众,“到需要进行露天采矿以获得生产 Dot 的原材料,再到冶炼厂和精炼厂,然后是良好的劳动条件,再到组件制造等等。

“我认为这是了解我们在采用人工智能(不仅仅是人工智能,而是任何技术)时所发挥的相互依存关系的一种方式。”

还有一个“系统”视图——Padilla 引用了世界体系理论,该理论探讨了世界不同部分如何被贬低为 Padilla 所说的“高度精加工商品产品”的生产中的角色。Padilla还提供了一个“替代”视图中探索的问题类型的示例。10 月份,美国众议院技术监督小组委员会 听取了华盛顿大学语言学教授 Emily M. Bender 的证词。

“我发现‘人工智能’这个词最适合理解为一个营销术语,”本德说,“它只会混淆视听。谈论自动化更清晰。”这导致了不同的问题,包括:

- 什么正在被自动化?

- 谁在自动化它,为什么?

- 谁从该自动化中受益?

- 谁受到了伤害,他们需要什么追索权?

- 谁对自动化系统的运行负责?

- 自动化正在使用的活动中哪些现有法规已经适用?

人工智能的到来不应仅仅是担心哪些工作将被取代。Padilla认为,理想情况下,我们还希望开放式人工智能产生“肯定”的影响——支持组织中角色的演变。

营销术语与技术描述符

Padilla 以一篇去年 8 月撰写的论文 中的严厉观察来开场他的演讲。David Gray Widder 在卡内基梅隆大学攻读博士学位期间,与人工智能研究所的常务董事 Sarah West 和信号基金会主席 Meredith Whittaker(一个专注于开源隐私技术和 Signal 消息应用程序开发的非营利组织)合作。

研究人员写道:“我们发现‘开放’和‘开源’这两个术语的使用方式混乱且多样化,通常构成更多愿望或营销,而不是技术描述符,并且经常混合来自开源软件和开放科学的概念。”

“这使本已复杂的格局变得更加复杂,其中目前尚未就人工智能背景下的‘开放’达成一致的定义,因此该术语正在应用于差异很大的产品,几乎没有参考稳定的描述符。”

因此,Padilla说,我们目前生活在一个许可条款难以评估的世界中,更不用说发现一个高度专有且昂贵的技术栈的冲击了。“我们认为我们知道开放意味着什么,然后我们开始体验类似于 M.C. Escher 那样的体验……”

“我认为我们有必要对我们从人工智能和我们共同完成的知识工作中想要什么有一个更具体的认识。”

鲁公网安备37020202000738号

鲁公网安备37020202000738号