MoRA技术,这是微软与北京航空航天大学联手搞出的一个大动作,听着就让人觉得牛笔。这个技术,它的核心在于一种叫做参数高效微调(PEFT)的玩法,简单说就是用更少的资源去调整那些大型语言模型(LLM)。MoRA不走寻常路,用的是方阵,而不是之前流行的低秩矩阵,这样一来,模型在吸收新知识和记忆上的能力就大大增强了,特别是在数学推理和持续预训练这种复杂任务上,MoRA更是表现出色。

接下来,咱们得聊聊MoRA和LoRA之间的较量。LoRA这家伙,在简单任务上表现得还不错,但是一旦遇到数学推理和持续预训练这种硬茬子,就有点儿力不从心了。MoRA就不一样了,它用方阵,所以在这些复杂任务上的表现就更加出色。而且,MoRA在记忆任务上的性能,几乎可以和完全微调模型相媲美,这可是个大突破。

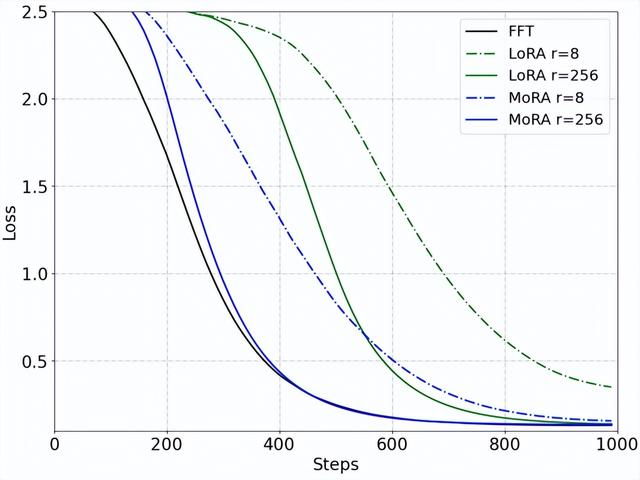

下图展示了LoRA系列方法在记忆UUID对的任务上性能,可以发现MoRA显著优于LoRA,并且与FFT相当,证明了高秩更新在记忆能力上的优势。

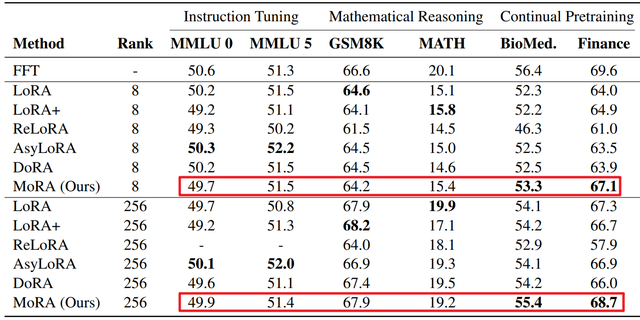

在特定领域,MoRA的表现也是可圈可点的。比如说在生物医学和金融领域,MoRA在做持续预训练任务的时候,优势特别明显。这对于那些希望提升自家LLM应用程序性能的企业来说,MoRA的出现无疑是个好消息。

说到企业应用,MoRA的开源实现,这可是个重大利好。企业可以用这个工具,更方便地给基础模型添加新知识,这在以前可是想都不敢想的。MoRA的出现,让企业在微调LLM应用程序时,有了更多的选择和可能性。

实验结果

下表展示了不同方法在三个任务上的性能。MoRA在指令调整和数学推理任务上与LoRA表现相当,在持续预训练任务上优于LoRA。

最后,咱们再展望一下MoRA的未来。随着MoRA适配器秩的增加,PEFT与完全微调之间的性能差距正在逐渐缩小。这就意味着,MoRA完全有潜力成为未来企业LLM微调的首选技术。这个领域,MoRA绝对是个值得关注的新星。

总的来说,MoRA技术的诞生,不仅仅是技术上的一次飞跃,更是给企业和开发者带来了实实在在的好处。这就像是在IT行业找到了一个新的突破口,让那些原本可能被大企业挤压得喘不过气的小企业和个人开发者,看到了新的希望和机会。MoRA,这个技术的潜力,绝对不容小觑。

鲁公网安备37020202000738号

鲁公网安备37020202000738号