文|邓咏仪

编辑|苏建勋

2024年刚开年,AI巨头们的竞赛,一波未平一波又起。

前几日,尽管和OpenAI Sora的比试里遗憾落了下风,但进击的谷歌,默默在深夜再度出了个大招——

北京时间2月21日深夜,谷歌正式宣布,推出全新开源模型Gemma。

Gemma 官网 来源:谷歌

对于Gemma,谷歌自己的官方描述是:

Gemma 是先进的轻量级开放模型系列,采用了与创建Gemini模型相同的研究和技术。受到Gemini的启发,Google DeepMind和Google其他团队合作开发了Gemma,并用拉丁语中意为“宝石”的gemma为其命名。

Gemma是一个小尺寸的大语言模型,与谷歌自家现在最强的大模型Gemini同出一源,共享技术。本次,谷歌发布了Gemma的两个版本:Gemma 2B(20亿参数)和Gemma 7B(70亿参数)。每种规模都提供了预训练和指令微调版本。

相较于百亿甚至千亿级别的通用基座大模型,2B和7B两个版本算是入门级的模型尺寸,相对应地,其应用成本也会更低。

比如,2B体量的大模型连手机都可以带得动而7B(70亿)则是一个检验模型性能的经典尺寸。大部分厂商在发布模型时,都会先选择发布近似这个体量的版本。

值得注意的是,Gemma和现在谷歌自家最强的大模型Gemini共享同一套技术。这相当于,谷歌把更小体量的Gemini放出来,跟现在的一众开源模型对打。

当前,Gemma 2B和7B允许所有组织(无论规模大小)负责任地进行商用和分发。未来,Gemma这个系列还会发布更大尺寸的模型。

而为了方便开发者,谷歌不仅开源模型,还附带开发套装,包括全新的“负责任生成式AI工具包”,为基于Gemma开发安全的人工智能应用程序提供了必要指导和工具,以及跨主流框架(如JAX、PyTorch及原生Keras 3.0下的TensorFlow)的推理和监督微调(SFT)工具链。

各种设备也已经适配好。谷歌已经基于英伟达的GPUs和谷歌云TPUs等多个AI硬件平台,对Gemma进行优化,让模型可以直接在笔记本电脑或台式机上运行。

谷歌此举,俘获了不少技术开发者的心。有人表示:好消息,谷歌终于再度回到开源路线了。

△网友迅速产出嘲笑OpenAI闭源的梗图 来源:X(Twitter)

不过,吃瓜的网友还是占大多数,有网友说:未来又有一众厂商又有技术型突破了,还有人吆喝:快通知这几天火遍国内的AI卖课大师李一舟。

△来源:Twitter(X)

小尺寸高性能,领跑Llama 2

此前,全球被用得最多的开源模型,是Meta旗下的Llama-2。谷歌发布Gemma,可以说直指开源竞赛——不少从业者表示,最强开源大模型,今日易主。

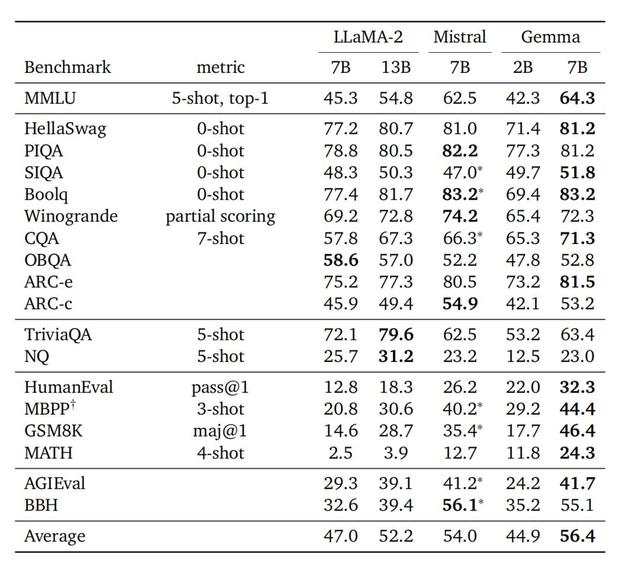

在Gemma的技术报告中,谷歌放出了大量训练细节,其中就包括Llama-2的测试对比结果图,大多数指标都超过了Llama-2。

△来源:谷歌

在训练数据上,Gemma主要在大量英文文本数据上进行训练的,这些数据主要来源于网络文档、数学和代码。具体来说,Gemma 2B模型训练了大约2万亿(2T)个token,而Gemma 7B模型则训练了大约6万亿(6T)个token。

不过,Gemma没有接受过处理图像或视频等非文本数据的训练,也没有专门针对多语言任务进行优化。

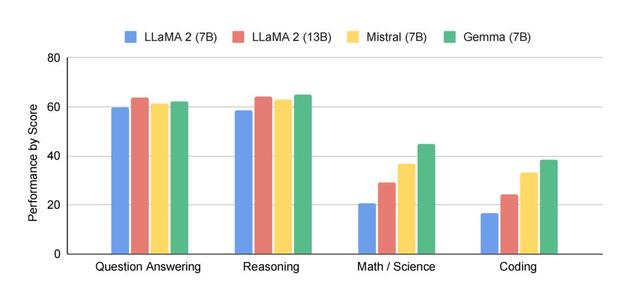

在谷歌的测试结果中,Gemma模型在18个文本任务中的11个上超越了同样规模的开放模型。它们在多个领域,包括问答、常识推理、数学和科学以及编程等领域,展示了先进的理解和推理能力。

谷歌甚至表示,Gemma模型在70亿参数规模的语言模型中表现最佳,甚至超过了一些参数量更大的模型。

△在各类英文数据集上,Gemma与其他相近体量开源模型对比 来源:谷歌

而最近风头正盛,号称要做“欧洲版OpenAI”的MistralAI是开源领域的新势力,旗下的Mistral 7B被誉为是“最强7B模型”。

对此,Gemma说:也没带怕的。在问答、推理、数学、代码场景里,Gemma的表现同样领先。

△来源:谷歌

谷歌再度领先开源竞赛

在大模型开源这件事上,谷歌可以说是鼻祖。在最初的Transformer、Bert等大模型路线,都离不开谷歌的经典论文、开源的多个基座模型等等重要贡献。

但OpenAI自从发布ChatGPT,此后的模型便开始转向闭源,这招致了AI界的批评和反对——OpenAI这个名字也多了几分讽刺意味。

对此,硅谷技术圈内的开源竞赛号角再度吹响。从2023年开始,Meta开源Llama、欧洲版OpenAI Mistral开源最强7B模型,还有马斯克的Grok,都在加速追赶开源社区追赶闭源模型的脚步。

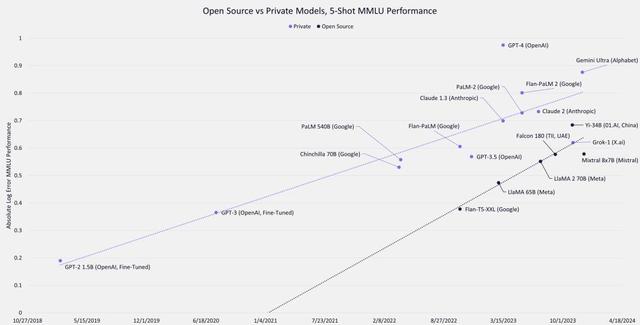

△一张经典的开源/闭源模型性能对比图 来源:ARK Invest

不过,对AI大模型的安全规范,学界、工业界依然争论不休,对于是否要让更大尺寸的模型开源,各家厂商都采取不一样的路线和开源程度。

比如,如OpenAI、谷歌和Meta等大公司,都在开源的节奏上更为审慎。2023年7月,Meta开源Llama-2时,就一口气提供了Llama-2的三种参数规模版本(70 亿、130 亿和 700 亿)。对此,OpenAI的首席科学家安德烈·卡帕西(Andrej Karpathy)就说,“Llama 2 是任何人都可以拿到的最强大语言模型。”

相对应地,Meta在开源时也设置了条件,有条件地开源给商业使用,而且超过7亿用户量的还要单独申请。

而在2023年新成立的AI公司Mistral,由一群从DeepMind和MetaAI出走的科学家远赴欧洲成立。

他们的路线更为激进,更像是原始版本的OpenAI:要让GenAI(生成式AI)为所有企业所用,完全开源。

△MistralAI

MistralAI的进展也不容忽视。就在这个月,Mistral在和客户沟通的时候泄露了一个中等尺寸的模型版本,各方面性能都已经相当接近GPT-4,引发开源社区的又一波震动。

开源模型的进展已然不容忽视。本次谷歌Gemma的发布,也再度证明谷歌在开源领域的野心和实力。

△来源:X(Twitter)

参考来源:Gemma官网:ai.google.dev/gemma

欢迎交流

欢迎交流

鲁公网安备37020202000738号

鲁公网安备37020202000738号