大模型去年还是百亿级参数,今年就干到了千亿级,而AI算力去年才出现的千卡集群,今年已然成了大厂标配,并将很快迎来万卡时代。

攒算力这个事,大厂小厂是各显神通。全世界的AI大厂都在疯狂囤N卡,也有亚马逊、特斯拉、微软这样的巨头在自研芯片。在国内,除了字节跳动是出了名的N卡收集狂,阿里百度有部分自研芯片外,绝大多数的大中小厂都在疯狂的寻找国产AI算力的替代方案。

毕竟H100、A100再强,阉割两次后——只比国产单卡的性能强一丢丢,主要还是CUDA这个庞大的软件生态托底。

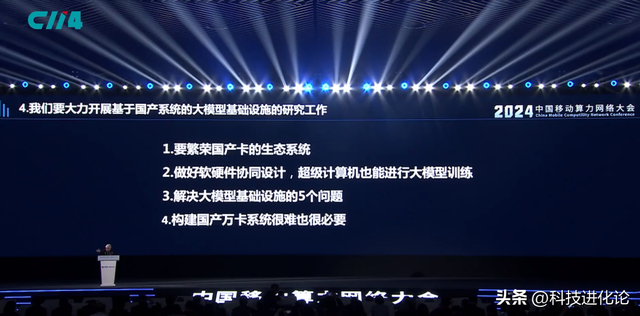

于是,留给国产AI算力的机会,就在千卡以上的集群,以及背后的软件生态了。正像中国工程院院士郑纬民所说:“构建国产万卡系统,虽然很难,但很必要。人工智能的模型研发、模型训练、模型精调、模型推理都需要算力,算力存在于大模型生命周期的每一环。”

在4月28日的中国移动算力网络大会上,郑纬民指出:“国产AI芯片与业界领先水平存在一定差距,但如果生态做好了,大多数任务不会因为芯片性能的微小差异而有明显感知。别人要用1万块卡,我们用9000块卡就可以了。”

华为和摩尔线程,可用的国产千卡集群

万卡集群是远方和田野,做好千卡集群才是眼前的生活。目前,国内具备部署全国产AI千卡集群的公司只有华为和摩尔线程这两家。

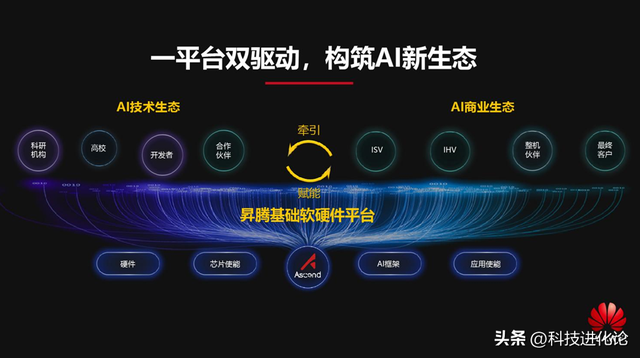

华为在去年发布了全新达芬奇架构的昇腾AI计算集群——Atlas900 SuperCluster,据了解该AI集群支持超万亿参数的大模型训练,采用全新的智算交换机以及超节点架构。在软件生态层面,华为推出了openEuler开源OS以及配套的数据库、中间件,涵盖从硬件、架构、框架、应用、开发运维工具等全产业链条,成为国产AI芯片的一支生力军。华为董事、ICT产品与解决方案总裁杨超斌在华为中国合作伙伴大会2024上表示,鲲鹏、昇腾逐步成为数智化转型升级的首选算力,昇思成为成长最快的开源AI框架。

如果说华为是国产AI专用芯片的代表,摩尔线程作为全功能GPU芯片头部创企,则是有望在功能上对标英伟达,成为大模型国产算力当下最佳选择。

摩尔线程率先推出了首个全国产千卡千亿模型训练平台——摩尔线程夸娥智算集群,可以为大模型训练提供稳定、高效、高兼容的算力支撑。以全功能GPU为算力底座,摩尔线程夸娥提供从卡(MTT S4000)、服务器(MCCX D800)到千卡集群(K1、K2、K3)的完整智算产品组合,通过软硬一体化的服务,将成为大模型企业的最佳选择之一。摩尔线程已经布局了从硬件集群、集群管理调度平台到大模型服务等软硬一体的全栈集群解决方案,具备了千卡甚至万卡的集群能力,在集群落地方面上走在行业前列。

软硬一体,端到端的千卡万卡集群

中国工程院院士郑纬民在“中国移动算力网络大会”上,强调了全栈软硬件一体化的重要性。

他认为国产算力支撑大模型训练,国产软件生态需要做好几件事:支持PyTorch 、TensorFlow等编程框架,多机多卡下的并行加速,跨机跨卡的通讯库,以及算子库、编译器、编程语言、调度器。

以摩尔线程的夸娥千卡集群为例,国产AI算力正在从GPU显卡到服务器,最后组成集群,包括了硬件的网络、存储、软件,再到大模型调度,实现了全栈式的工程、端到端的交钥匙方案。

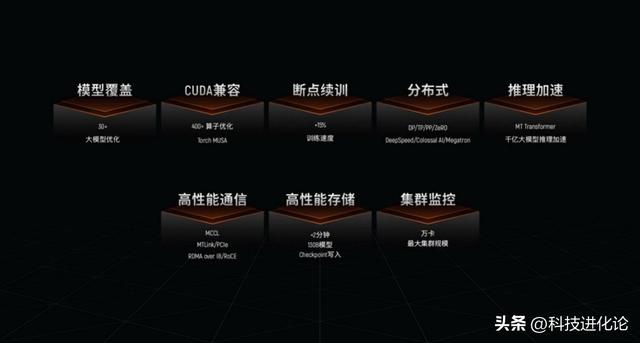

夸娥智算集群全栈方案有8大核心优势:

1) 模型覆盖:目前,摩尔线程支持包括LLaMA、GLM、Aquila、Baichuan、GPT、Bloom、玉言等业界主流大模型的训练和微调。

2) 主流生态兼容,包括CUDA:摩尔线程代码移植Musify工具,可快速将现有的主流迁移至MUSA,零成本完成CUDA代码自动移植,可以复用PyTorch开源社区的大量模型算子。

3) 断点续训:可以实时监测训练任务集群,分钟级发现故障并自动恢复训练;框架集成检查点(checkpoint)备份及恢复;综合提升训练效率15%-50%之间。

4) 大模型语言分布式训练:摩尔线程KUAE支持包括DeepSpeed、Megatron-DeepSpeed、Colossal-AI、FlagScale在内的业界主流分布式框架。

5) 推理加速:包含四个部分KUAE-ModelStudio、MUSA Serving 、MT Transformer 、TensorX,包含了大语言模型开放工具、推理服务软件、分布式推理加速框架。

6) 高性能通信:MT-Link高速片间互联, MT-Link带宽 112GB/s、支持双环拓扑结构,支持典型的ring allreduce算法通讯。

7) 高性能存储:夸娥吞吐量提升50%以上,时延降低75%。大规模训练下降低训练耗时约 28 个小时;每存储单元读取性能 90GB/s,写入性能 50GB/s,可横向扩容。

8) 集群可靠性与性能:支持万卡以上大规模GPU集群可靠、高性能运行。能高效获取服务器、GPU、集合通信组件、RDMA网络、异构架构、分布式训练任务等状态数据采集,无人值守的连续训练时长大于30天。

结语:郑院士认为:构建基于国产AI卡的万卡大模型训练平台,要考虑网络平衡设计、体系结构感知的内存平衡设计、IO子系统平衡设计,需要支持检查点、增加SSD。

摩尔线程的夸娥千卡集群,正是在软硬件一体化实现了全局突破,成为了国产AI算力第一梯队的一员。随着摩尔线程3家千卡集群智算中心的落地,未来万卡集群将更值得国产大模型期待。

鲁公网安备37020202000738号

鲁公网安备37020202000738号