本文是“大语言模型系列”的番外篇,探讨人工智能发展路上的5个寒冬。

- 第一个寒冬,1966年:机器翻译失败

- 第二个寒冬,1969年:联结主义者与神经网络研究的衰落

- 第三个寒冬,1974年:人工智能研究者与其资助者之间的沟通鸿沟

- 第四个寒冬,1987年:LISP机器市场的崩溃

- 第五个寒冬,1988年:没有高级机器智能——没有资金

//

第一个寒冬:1966年,机器翻译失败

自然语言处理(NLP)研究起源于20世纪30年代初,并随着机器翻译(MT)工作的展开而开始。然而,在1949年瓦伦·韦弗发表了具有影响力的备忘录后,显著的进步和应用才开始出现。

这份备忘录在研究界引起了极大的兴奋。在接下来的几年中,发生了许多值得注意的事件:IBM开始开发第一台机器,麻省理工学院任命了第一位全职的机器翻译教授,并举办了几次机器翻译专门的会议。高潮是在1954年,IBM-乔治城机器的公开演示吸引了权威报纸的广泛关注。

Yehoshua Bar-Hillel,第一位全职机器翻译教授

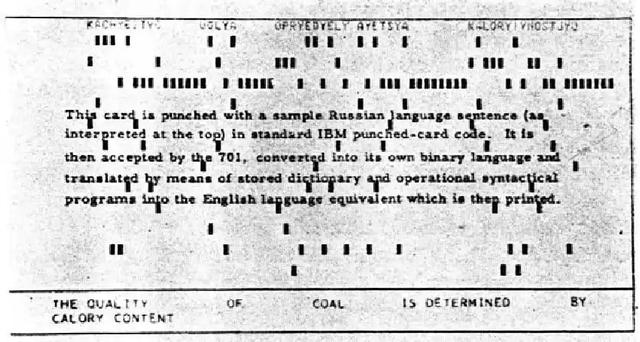

使用 Georgetown Machine 的机器翻译系统的首次公开演示

乔治城机器演示期间使用的打孔卡

推动机器翻译领域发展的另一个因素是美国中央情报局 (CIA) 的兴趣。当时,CIA 坚信开发机器翻译能力的重要性,并支持此类举措。他们还认识到,该计划的影响超出了 CIA 和情报界的利益。

怀疑论者

正如所有人工智能的繁荣都被绝望的人工智能寒冬所跟随一样,媒体往往夸大了这些发展的意义。

关于IBM-乔治城实验的头条新闻宣称“电子大脑翻译俄语”,“双语机器”,“机器人脑翻译俄语成国王英语”和“多语种的脑孩子”。然而,实际的演示只是将一套精心挑选的49个俄语句子翻译成英语,机器的词汇量仅限于250个单词。

为了让事情更加清楚,一项研究发现,人类需要大约8000到9000个词汇量才能以98%的准确率理解书面文本。

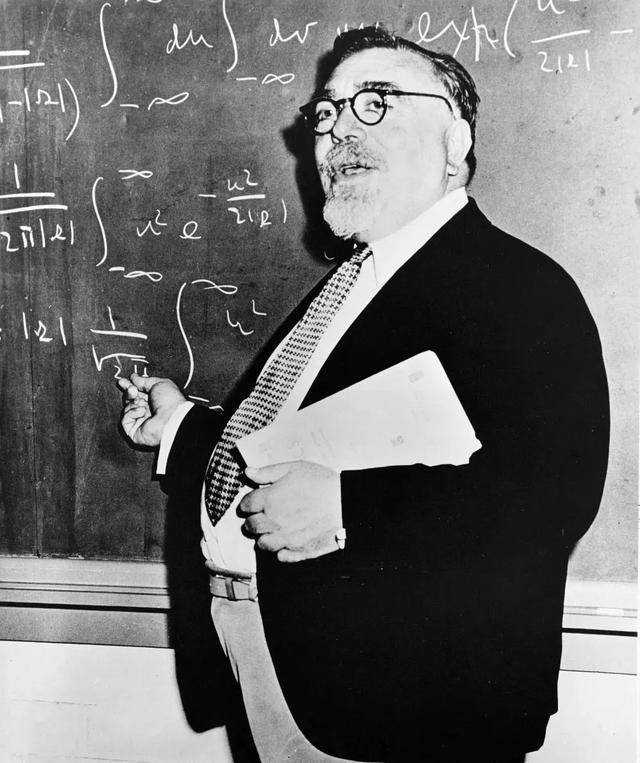

Norbert Wiener(1894-1964)在随机过程、电子工程和控制系统方面做出了重大贡献。他开创了控制论,并提出了反馈机制导致智能行为的理论,为现代人工智能奠定了基础。

这次演示引起了相当大的轰动。然而,也有怀疑者,比如被认为是早期人工智能研究理论基础的奠基者之一的诺伯特·维纳教授。甚至在瓦伦·韦弗的备忘录发表之前,诺伯特·维纳就在1947年致瓦伦·韦弗的一封信中表达了他的怀疑,他在信中写道:

“我坦率地说,我担心不同语言的词汇边界太模糊,情感和国际的内涵太广泛,任何准机械翻译方案都不会有太大希望。目前,语言的机械化,除了为盲人设计光电阅读机会之外,似乎还为时过早。”

机器翻译的支持者与资金

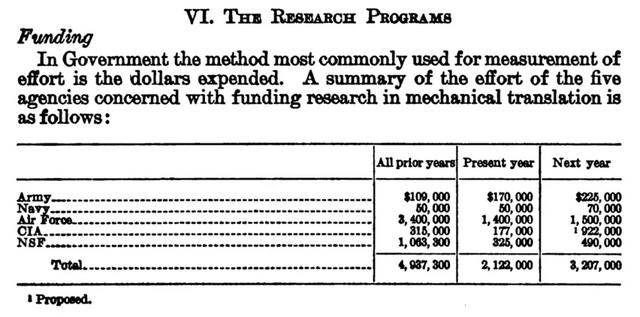

然而,似乎怀疑者是少数,因为梦想家们成功地超越了他们的担忧,并成功获得了必要的资金。五个政府机构参与了资助研究:主要的贡献者是国家科学基金会(NSF),以及中央情报局(CIA)、陆军、海军和空军。

到1960年,这些机构在机械翻译项目上总共投资了近500万美元。

五个政府机构的资金,该报告可追溯到1960年

到1954年,机械翻译研究已经获得了足够的兴趣,得到了国家科学基金会(NSF)的认可,NSF向麻省理工学院(MIT)提供了一笔资助。CIA和NSF进行了谈判,1956年初,两位主任之间有来往信件。NSF同意管理所有相关方同意的任何需要的机器翻译研究计划。

根据国家科学基金会1960年的证词,美国有11个研究组在联邦政府的支持下从事机械翻译研究。空军、美国陆军和美国海军也表现出极大的兴趣。

人工智能的诞生

IBM-乔治城机器公开演示的次年,麦卡锡在1955年发布的达特茅斯夏季会议提案中创造了“人工智能”一词。这一事件引发了新一波的梦想和希望,进一步增强了现有的热情。

新的研究中心出现了,配备了更强的计算机能力和更大的内存容量。同时,高级编程语言的发展也在进行。这些进步部分归功于国防部的大量投资,国防部是自然语言处理研究的主要支持者。

在语言学领域,特别是乔姆斯基提出的形式语法模型的发展,激发了几个翻译项目的开展。这些发展似乎有望显著提高翻译能力。

正如约翰·哈金斯在《机器翻译简史》中所写的那样,有许多关于即将“突破”的预测。然而,研究人员很快遇到了语义障碍,这些障碍提出了复杂的问题,没有简单的解决方案,导致了日益增长的幻灭感。

幻灭

在《威士忌是看不见的》一书中,约翰·哈金斯引用了一个著名的例子,即一个机器翻译系统将圣经中的“精神愿意,但肉体软弱”翻译成俄语,然后再翻译回来变成“威士忌强壮,但肉体腐烂”。

虽然这个故事的准确性有待考证,伊西多尔·平丘克甚至说这个故事可能是杜撰的,但伊莱恩·里奇用它来展示早期机器翻译系统处理成语的无能。总体来说,这个例子说明了机器翻译系统在单词语义方面的问题。

圣经里有句话叫“心灵固然愿意,但肉体却软弱了”

MT 系统将其翻译为“威士忌很烈,但肉却烂了”

一个可能不可信的陈词滥调的例子

主要打击来自ALPAC小组的发现,该小组由美国政府委托,由国家科学基金会主任Dr. Leland Haworth领导,他们支持这一观点。

在他们的报告中,机器翻译与物理学和地球科学各种文本的人工翻译进行了比较。结论是:机器翻译的输出比人工翻译在所有审查的例子中都不准确、速度慢、成本高且不全面。

1966年,美国国家研究委员会突然终止了所有对机器翻译研究的支持。在英格兰,科学家们误以为翻译书面文本比解密密码更具挑战性,因此在用计算机解密德国秘密代码成功后,他们错误地认为翻译书面文本不会比解密密码更具挑战性。

然而,处理“自然语言”的复杂性比预期的更难。尝试自动词典查找和应用语法规则的结果荒谬。经过二十年的研究和两千万美元的投资,仍未找到解决方案,促使国家研究委员会终止了这一研究工作。

幻灭感的产生是因为对该领域实用应用的高期望,尽管在语言学理论基础上缺乏足够的支持。研究人员更关注理论方面,而不是实用实现。此外,有限的硬件可用性和技术解决方案的不成熟也带来了额外的挑战。

第二个寒冬:1969年,连接主义与神经网络研究的衰落

继第一个失望的浪潮之后,第二次失望的浪潮很快到来,为人工智能研究人员敲响了夸大其词的警钟。然而,在深入探讨随之而来的困境之前,有必要了解一些背景信息。

20世纪40年代,麦卡洛克和沃尔特·皮茨着手研究心智的基本原理,并开发了早期版本的人工神经网络,灵感来自生物神经网络的结构。

大约十年后,即20世纪50年代,认知科学作为一个独立学科出现,被称为“认知革命”。许多早期的人工智能模型受到了人脑工作原理的启发。一个显著的例子是马文·明斯基的SNARC系统,这是第一个模拟老鼠在迷宫中导航的计算机化人工神经网络。

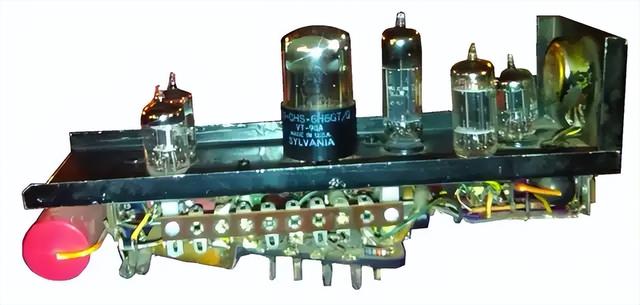

图片由Gregory Loan提供:Gregory拜访了马文·明斯基,询问他的迷宫解决计算机发生了什么。明斯基回答说,它被借给了一些达特茅斯的学生,后来被拆解了。然而,他还留有一个“神经元”,Gregory拍了一张照片。

然而,在20世纪50年代后期,这些方法大多被放弃,研究人员将注意力转向符号推理,认为这是实现智能的关键。

像逻辑理论家(1956年,被认为是第一个人工智能程序)和通用问题解决器(1957年,由兰德公司艾伦·纽厄尔、赫伯特·A·西蒙和克利夫·肖设计的通用问题解决机器)等程序的成功,促使了这一转变。

一种类型的连接主义研究仍在继续:弗兰克·罗森布拉特坚持不懈地研究感知机。罗森布拉特最初于1957年在康奈尔航空实验室的IBM 704计算机上模拟了感知器。然而,随着1969年马文·明斯基和西摩尔·佩珀特的《感知器》一书的出版,感知机研究戛然而止,该书详细说明了感知机的局限性。

正如丹尼尔·克雷维尔所写:

《感知器》出版后不久,一件悲惨的事件进一步减缓了该领域的研究:据传闻,弗兰克·罗森布拉特在一次划船事故中溺水身亡,当时他已经是一个失意的人。失去了最有说服力的推广者,神经网络研究进入了长达十五年的衰落期。

在此期间,尽管规模较小,但连接主义研究仍在取得重要进展。保罗·韦博斯在1974年引入了反向传播算法,这是训练神经网络的重要算法,尽管资源有限,但这一研究仍在继续。为联结主义项目争取重大资金仍然困难,导致这些研究的追求有所减少。

直到20世纪80年代中期,转折点才出现。当时,像约翰·霍普菲尔德、大卫·鲁梅尔哈特等杰出研究人员重新唤起了对神经网络的广泛兴趣。他们的工作重新点燃了对联结主义方法的热情,为神经网络领域的大规模研究和发展的复兴铺平了道路。

第三个寒冬,1974年:AI研究人员与资助方之间的沟通障碍

高期望和雄心勃勃的主张往往是通向失望的直接路径。20世纪60年代末和70年代初,马文·明斯基和西摩尔·佩珀特在麻省理工学院领导了微世界项目,他们开发了称为微世界的简化模型。他们将这一努力的总体方向定义为:

我们认为[微世界]非常重要,因此我们将大量精力投入到开发这些微世界集合中,并寻找如何利用模型的启示和预测能力,而不被其与字面真理的不兼容性所淹没。

然而,微世界的倡导者很快意识到,即使是人类使用的最具体的方面,也不能在不考虑人类文化的广泛背景下定义。例如,SHRDLU中使用的技术仅限于特定的专业领域。微世界的方法并未导致通用智能的逐步解决方案。明斯基、佩珀特及其学生无法将一个微世界逐步推广到更大的宇宙,或者简单地将几个微世界组合成一个更大的集合。

全国其他人工智能实验室也面临类似的难以满足期望的困难。例如,斯坦福大学的Shakey机器人项目未能达到成为自动间谍设备的期望。研究人员发现自己陷入了越来越夸大的循环中,在他们的提案中承诺了超过他们能交付的东西。最终的结果往往达不到初始承诺。

资助这些项目的国防部高级研究计划局(DARPA)开始重新评估其方法,并要求研究人员提供更现实的期望。

1971-75年:DARPA的削减

20世纪70年代初,DARPA的语音理解研究(SUR)计划旨在开发能够理解口头命令和数据的计算机系统,以便在战斗场景中实现无接触互动。五年后,耗资一千五百万美元,DARPA突然终止了该项目,尽管具体原因尚不清楚。斯坦福、麻省理工学院和卡内基梅隆等著名机构的数百万美元合同几乎被削减至无足轻重的地步。

丹尼尔·克雷维尔在他的书中描述了当时DARPA的资助理念:

DARPA当时的理念是“资助人,而不是项目!”闵斯基曾是Licklider在哈佛的学生,与他关系密切。正如闵斯基告诉我的,“Licklider给了我们一大笔钱”,并不特别关心细节。

在这五年中,包括Bolt, Beranek, and Newman, Inc.(BBN)和卡内基梅隆在内的几家著名承包商生产了许多重要系统。这些系统包括SPEECHLESS、HIM、HEARSAY-I、DRAGON、HARPY和HEARSAY-II,这些系统在理解连贯语音和处理多个说话者的千词词汇句子方面取得了显著进展。

这些系统在理解不受约束的输入方面存在局限性,用户不得不猜测哪些命令适用于他们,因为受限的语法限制了系统的理解能力。尽管在这一方面令人失望,人工智能研究人员仍以这些项目为荣。例如,HEARSAY-II因其使用“黑板”设备集成多个知识源而被誉为有史以来最具影响力的人工智能程序之一。

但此时,人工智能研究人员与资助方之间关于期望的沟通差距变得过大。

1973年:响应Lighthill报告,英国AI研究大幅减少

人工智能研究的衰退并不仅限于美国研究人员。在英国,一份由流体动力学领域的杰出人物、剑桥大学卢卡斯应用数学讲座前任教授詹姆斯·莱特希尔爵士撰写的报告,对人工智能研究的现状造成了沉重打击。莱特希尔将他的研究分为三部分,称为“该学科的ABC”。

“A”代表高级自动化,旨在用专门设计的机器取代人类。“C”代表基于计算机的中枢神经系统(CNS)研究。最后,“B”代表人工智能本身,作为A和C类之间的桥梁。

尽管A和C类经历了交替的成功和失败,莱特希尔强调了围绕B类桥梁活动的普遍和深刻的失望感。正如他所说:“这引发了关于人工智能作为一个综合研究领域的概念是否有效的疑问。”

该报告引发了一场激烈的辩论,并于1973年在BBC“争议”系列中播出。题为“通用机器人是海市蜃楼”的辩论在皇家学会举行,詹姆斯·莱特希尔爵士与唐纳德·米奇、约翰·麦卡锡和理查德·格雷戈里对峙。

不幸的是,该报告的后果是严重的,导致英国的人工智能研究几乎完全解体。只有少数几所大学,如爱丁堡大学、埃塞克斯大学和萨塞克斯大学,继续进行人工智能研究。直到1983年,人工智能研究才在更大范围内复苏。这一复兴是由于英国政府的资助计划Alvey的推动,该计划为了响应日本的第五代项目,拨款3.5亿英镑用于人工智能研究。

第四个寒冬:1987年,LISP机器市场的崩溃

在被称为连接主义寒冬的时期,符号系统如逻辑理论家(1956年)和通用问题解决者(1957年)在硬件限制下继续进展。这些系统由于当时计算机能力有限,只能处理玩具例子。赫伯特·西蒙对20世纪50年代至60年代的情况这样描述:

“人们避开以知识为中心的任务,因为我们当时无法用现有的计算机构建大型数据库。我们的第一个象棋程序和逻辑理论家都是在一个只有64到100字核心和一个有10,000字可用空间的存储鼓的计算机上完成的。所以语义并不是重点。我记得我有一个学生想要做一个关于如何从大存储中提取信息的论文。我告诉他‘绝对不行!你只能在玩具例子上做这个论文,我们无法知道它如何扩展。你最好找点别的事情做。’所以人们确实避开了那些知识是关键问题的任务。”

大约在1960年,麦卡锡和明斯基在麻省理工学院开发了LISP,这是一种基于递归函数的编程语言。由于其符号处理能力和处理复杂任务的灵活性,LISP变得非常重要,这对早期AI的发展至关重要。LISP是最早用于AI研究的语言之一。然而,直到20世纪70年代初,随着拥有大量内存的计算机的出现,程序员才得以实现知识密集型应用。

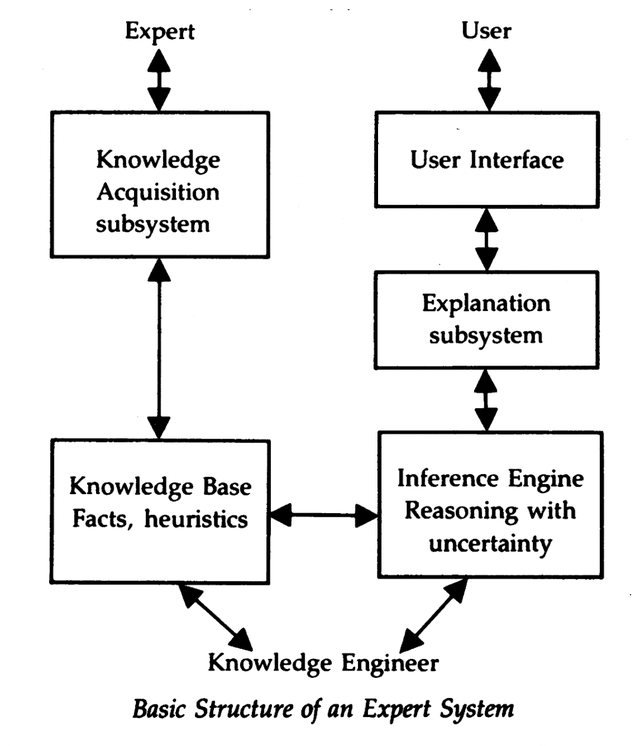

这些系统成为“专家系统”的基础,旨在结合人类专业知识并在某些任务中取代人类。20世纪80年代标志着专家系统的崛起,将AI从学术领域转向实际应用,LISP成为首选编程语言。根据程序员及Y Combinator和Hacker News的联合创始人保罗·格雷厄姆的文章,LISP“是现有语言的一次激进突破”并引入了九个创新理念。

专家系统的发展代表了AI领域的重要里程碑,弥合了学术研究与实际应用之间的差距。卡内基梅隆大学的约翰·麦克德莫特于1980年1月提出了第一个专家系统XCON(eXpert CONfigurer)。XCON被数字设备公司(DEC)用于简化其VAX计算机的配置过程。到1987年,XCON处理了大量订单,展示了其影响力和有效性。

1981年,卡内基梅隆大学开始开发一个新系统Xsel。开发工作后来由DEC接管,并于1982年10月开始现场测试。尽管Xcon和Xsel获得了大量宣传,它们仍处于原型阶段。当时的Xsel项目经理布鲁斯·麦克唐纳开始抗议宣传远远超过了实际成就,但销售副总裁并不打算停止。麦克唐纳记得一次与高级管理层的会议,销售副总裁盯着他说:“你已经在这件事上工作了三年了。它难道还没准备好?”

20世纪80年代初,专家系统成功案例激增,导致许多大公司成立了AI小组。个人电脑的兴起、《星球大战》电影的流行和《Discover》和《High Technology》等杂志促进了公众对AI的兴趣。20世纪70年代末的十亿美元生物技术热潮推动了对高科技的投资兴趣,促使顶尖AI专家开始新的创业:

- 爱德华·费根鲍姆,被称为“专家系统之父”,与一些斯坦福大学的同事成立了Teknowledge, Inc.

- 卡内基梅隆大学的研究人员成立了卡内基集团。

- 麻省理工学院的衍生公司足够多,形成了被称为AI巷的区域,这些初创公司包括Symbolics、Lisp Machines, Inc.和Thinking Machines Corporation。

- 拉里·哈里斯离开达特茅斯成立了人工智能公司。

- 在耶鲁大学的罗杰·香克监督了Cognitive Systems, Inc.的成立。

那时出现的公司可以分为三个主要领域,从销售额最大到最小依次为:

1、AI相关硬件和软件,特别是称为LISP机器的微型计算机,专门用于以接近大型机速度运行LISP程序

2、称为“专家系统开发工具”或“外壳”的软件,用于大公司开发其内部专家系统

3、实际的专家系统应用

LISP机器

到1985年,共有150家公司在内部AI小组上花费了10亿美元。1986年,美国AI相关硬件和软件的销售额达到了4.25亿美元,成立了40家新公司,总投资额为3亿美元。

爆炸性的增长带来了挑战,因为随着记者、风险资本家、行业猎头和企业家的涌入,学术界感到拥挤。1980年美国人工智能协会的首次会议吸引了大约一千名研究人员,而到1985年,AAAI和IJCAI的联合会议的出席人数接近六千。氛围从休闲装变成了正式装。

在1984年的AAAI年会上,罗杰·香克和马文·明斯基警告即将到来的“AI寒冬”,预测即将到来的AI泡沫破裂,而这确实在三年后发生了,基于LISP的AI专用硬件市场崩溃了。

Sun-1 是 Sun Microsystems 公司生产的第一代 UNIX 计算机工作站和服务器,于 1982 年 5 月推出

Sun Microsystems和Lucid等公司提供了功能强大的工作站和LISP环境作为替代品。通用工作站对LISP机器构成了挑战,促使Lucid和Franz LISP等公司为UNIX系统开发了越来越强大和便携的LISP版本。后来,Apple和IBM的桌面计算机出现了更简单的架构来运行LISP应用程序。到1987年,这些替代品的性能匹配昂贵的LISP机器,使得这些专用机器变得过时。价值五亿美元的行业在一年内迅速被取代。

1990年代:对新专家系统部署和维护的抵制

在LISP机器市场崩溃后,更先进的机器取而代之,但最终也遭遇了同样的命运。到20世纪90年代初,大多数商业LISP公司,包括Symbolics和Lucid Inc.,都失败了。德州仪器和施乐公司也退出了这个领域。一些客户公司继续维护基于LISP的系统,但这需要支持工作。

第一台 Macintosh

第一台 IBM 个人计算机

进入1990年代及以后,“专家系统”一词和独立AI系统的概念在IT词汇中基本消失了。对此有两种解释。一种观点认为“专家系统失败了”,因为它们未能兑现过度炒作的承诺,导致IT界转向了其他领域。另一种观点认为专家系统是其成功的受害者。随着IT专业人员接受规则引擎等概念,这些工具从用于开发专用专家系统的独立工具转变为在许多领域中的标准工具。

第五个寒冬:1988年,没有高级机器智能,没有资金

1981年,日本公布了他们雄心勃勃的第五代计算机项目计划,引起了全球的关注。美国,凭借其国防部资助AI研究的历史和技术专长,于1983年启动了战略计算计划(SCI)作为回应。SCI旨在在十年内开发先进的计算机硬件和人工智能。《战略计算:DARPA与机器智能的追求,1983-1993》的作者们描述了“SCI设想的机器”:

“它将每秒运行100亿条指令,以实现像人类一样的视觉、听觉、言语和思考。所需的集成度将与人类大脑(已知最复杂的仪器)所达到的水平相媲美。”

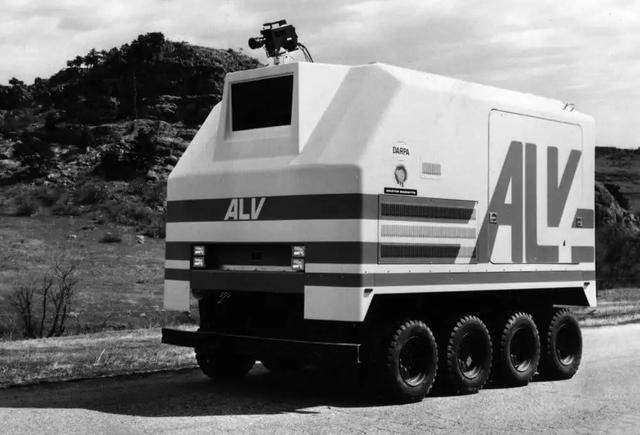

战略计算计划(SCI)下的一个显著项目是“智能卡车”,即自主陆地车辆(ALV)项目。它获得了SCI年度预算的很大一部分,旨在开发一种多功能机器人,用于各种任务。这些任务包括武器运输、侦察、弹药处理和后方补给。目标是创建一辆能够在崎岖地形上行驶、克服障碍并利用伪装的车辆。最初,轮式原型仅限于道路和平坦地面,但最终产品被设想为能够在机械腿上行驶任何地形。

自主陆地车辆(ALV)

到20世纪80年代末,显而易见该项目远未达到预期的机器智能水平。主要挑战在于缺乏一个有效且稳定的管理结构来协调项目的不同方面,并共同向机器智能的目标推进。尽管进行了各种尝试以在SCI上实施管理方案,但都未能成功。此外,SCI的雄心目标,如ALV项目的自动驾驶能力,超出了当时的可实现范围,更像是当代多模态AI系统和难以捉摸的AGI(人工通用智能)概念。

在1987年接管信息处理技术办公室(IPTO)的杰克·施瓦茨的领导下,DARPA对AI研究的资助有所减少。在《思考的机器:对人工智能历史和前景的个人探询》一书中,帕梅拉·麦科杜克描述了施瓦茨对战略计算计划的态度和AI的角色:

“施瓦茨认为DARPA在使用一种游泳模型——设定目标,然后无论水流或风暴如何都朝目标游去。相反,DARPA应该使用冲浪者模型——等待大浪,使其相对有限的资金能够优雅且成功地冲向同样的目标。从长远来看,AI是可能且有前景的,但它的浪潮尚未兴起。”

尽管未能实现高级机器智能,SCI确实完成了一些特定的技术里程碑。例如,到1987年,ALV已经展示了在双车道公路上的自动驾驶能力、障碍物避让和不同条件下的越野驾驶。SCI ALV项目使用的视频摄像头、激光扫描仪和惯性导航设备为当今商用无人驾驶汽车的发展奠定了基础。

据《战略计算:DARPA与机器智能的追求,1983-1993》所述,国防部在1983年至1993年间在SCI上投资了1,000,417,775.68美元。该项目最终在1990年代被加速战略计算计划(Accelerated Strategic Computing Initiative)接替,后来又被高级模拟和计算计划(Advanced Simulation and Computing Program)接替。

结论

寒冬无疑是令人不快的,但在那些时期进行的研究为最近在大型语言模型(LLM)上的突破提供了可能。在符号专家系统鼎盛时期,连接主义研究者继续在神经网络上进行工作,尽管规模较小。保罗·韦尔博斯发现的反向传播算法对于训练神经网络至关重要,是进一步进展的关键。

在20世纪80年代中期,随着霍普菲尔德、拉姆哈特、威廉姆斯、辛顿等研究人员展示了反向传播在神经网络中的有效性及其表示复杂分布的能力,“连接主义寒冬”结束了。这种复兴与符号专家系统的衰退同时发生。

在此之后,神经网络的研究蓬勃发展,没有再遭遇任何重大挫折,导致了许多新模型的发展,最终为现代大语言模型的出现铺平了道路。

(未完待续)

鲁公网安备37020202000738号

鲁公网安备37020202000738号