今天凌晨 1 点( 太平洋时间 5 月 13 日上午 10 点 ),OpenAI 的 CTO Mira Murati 不到30分钟,一场短暂的春季新闻发布会向大家展示了一波浪潮 OpenAI 的新肌肉。

说实话,还是有点意犹未尽,因为这个 AI ,似乎已经成精了。

新闻发布会主要有四个部分,分别是桌面端 App 的更新、 WebUI 的更新、GPT-4o 实时发布模型 AI 助手的功能演示。

其中,最重、最核心的无疑是 GPT-4o 这个新模型。

根据 Mira Murati 的说法,OpenAI 的愿景是 AI 方便可以使所有人受益,所以新的 GPT-4o 该模型将向所有人免费开放,付费用户将比免费用户使用更多 5 倍。( 官员指出,当使用次数达到上限时,免费用户将被迫退回 GPT-3.5 版本。这应该是出于成本考虑。 )

与上一代相比 GPT-4 Turbo,GPT-4o API 的速度快了 2 倍,成本便宜 50%、在速度限制方面,它也高于前者 5 倍。

当然,如果只是这些性能上的“ 略微提升 ",对不起 OpenAI 在 AI 事人在该领域的地位。

实际上,根据 OpenAI 官网介绍,GPT-4o 中的 “ o ” ,代表的是 “ omni ”,也就是 “ 全能 ” 意思。它成功地打开了所有的文本、视觉和音频,这意味着 GPT-4o 可接受文本、音频和图像的任何组合作为输入,并生成文本、音频和图像的任何组合输出。

这是多模态大模型的重大变化。

拿此前 ChatGPT 以语音模式为例。它使用由三个独立模型组成的管道。一个模型负责将音频转录为文本。第二个模型是 GPT-4 ,它负责接收和输出文本,第三个模型将文本转换为音频

。

这个过程意味着中间的主角 GPT-4 收到的信息实际上是二手的 —— 它不能直接观察音调、多个演讲者或背景噪音,也不能输出笑声、唱歌或表达情感。

而在最新的 GPT-4o 在模型中,所有的输入和输出都由相同的神经网络处理,即新的 GPT-4o 它是一种解决上述所有缺点的原始多模态模型,而不是以前的组合模型。

总之,各种数据,特别是视觉和音频理解,GPT-4o 与市场上其他大型模型相比,出现了一波遥遥领先的浪潮。

在新闻发布会上,他们还简要演示了这一基础 GPT-4o 的最新 AI 助手,只能说是相当震撼。

一个是 AI 助手建议 OpenAI 工作人员不要紧张,演讲前可以深呼吸。OpenAI 员工故意呼吸,让员工大声呼吸 AI 助手评价他的深呼吸,AI 助手直接伤了他一句话 “ 你不是吸尘器 。。。

显然,新模型可以听到发言人呼吸声的重量,并及时开玩笑,充满情感。

此外,工作人员还要求工作人员同时要求 AI 当助手讲故事时,不断地要求助手讲故事 AI 改变音色、语调、情感等。AI 则像《 喜剧之王 》和周星驰一样,完美的回应 “ 导演 ” 每一个需求。

同样,AI 助手的视觉能力也让许多人对演示现场感到惊讶。无论是通过视频,一步一步地指导工作人员解决方案,还是通过摄像头,观察人们的表情来猜测他们的情绪,AI 几乎所有的助手都完美胜任。

他们还在新闻发布会上展示 AI 在演示中,助手的实时翻译功能 AI 完美地切换意大利语和英语,基本上感觉不到任何延迟。

知危编辑部上传了一段完整的新闻发布会视频,配有翻字幕。您可以看到视频演示的效果。面对惊人的效果,我们的文字描述非常苍白。请从视频开始 9:15 单独观看演示。( 时间匆忙,机器翻转字幕没有精细校准,导致部分英文字母重叠,意大利机器识别代码混乱,但基本上不影响对视频的理解,给您带来不完美的体验,对不起 )

知危编辑部认为,这次新闻发布会的另一个亮点是基于 GPT-4o 的桌面端 App,用户在新闻发布会现场演示中使用 ChatGPT 本文本对话框不再需要输入。

你可以给 OpenAI 的桌面 App 分享屏幕,让 AI 直接在线帮助您解释代码,分析图表,并通过语音与您实时沟通。只能说老罗的 TNT 当时确实缺乏大模型的赋能。

但是,知危编辑部认为最可怕的是,根据 OpenAI 官方网站:他们只是试图探索,做了一些演示,甚至不完全知道这个模型能做什么,上限在哪里。

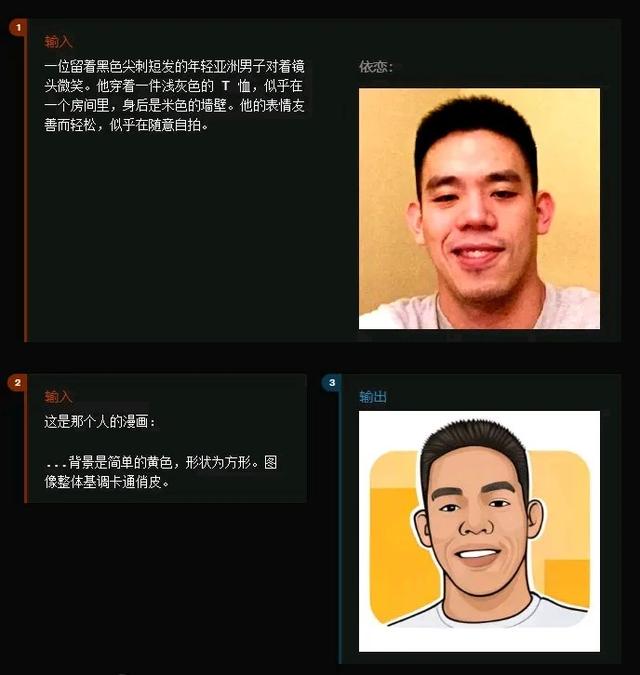

比如简单生成图片,以及图片的风格化,GPT-4o 看起来完全无话可说。

还可以通过详细的描述,让你 AI 制作相应的设计图片。

通过几个简单的描述和输入输出 3D 图形,GPT-4o 似乎也能胜任。

它甚至可以根据要求直接输出相应的声音。

以下是生成的声音,可以点击播放↓

GPT-4o生成的硬币掉落音,知危,3秒

按照 OpenAI 的说法,GPT-4o 文本和图像功能将从今天开始 ChatGPT 推出并给出入口链接。正式开放音频功能需要几周甚至几个月的安全评估。

然而,在出版之前,知危编辑部拥有的一切 ChatGPT 在账户中,进入官方入口后仍然是唯一一个 GPT-3.5 和 GPT-4 不知道后台是否还没有完成功能,所以我们还没有给你带来实测体验。

也许几个小时后,你可以安不躁,GPT-4o 它将在线完成,我们可以进一步体验。

到目前为止,我们是对的 GPT-4o 与之相比,快速介绍已经完成 “ 免费 ” 和 “ 更强 我们认为这次更新最重要的是 “ 易用 ” 性。

我们认为最好的工具应该让你感觉不到它的存在。

在过去,手机和电脑大大提高了我们的工作和生活效率,但它们仍然有一定的门槛,仍然需要你找到方法 “ 高效的输入 ”。

而这次,GPT-4o 真正让人与机器的交流变得丝滑,用最原始、最简单的语音和视频,让你得到你想要的信息,做你想做的事。

也许我们可以称之为这个 “ 大模型的 OS 化 ”,忘掉 Windows、MacOS、iOS 或是 Android 在未来,我们可能不会接触到操作系统,我们唯一需要的就是对机器说话。

鲁公网安备37020202000738号

鲁公网安备37020202000738号