与其过分关注单一芯片的性能强弱,不如根据人工智能业务场景需求,设计更具针对性的算力系统,实现整体性能最优。

文|周享玥

编|赵艳秋

11月底,北京召开的一场以“智算力就是创新力”为主题的人工智能计算大会上,挤满了来自各行各业的数千位参会者。

在算力紧缺问题依旧未解的当下,大家关心的问题,普遍围绕大模型最新创新和落地成果,以及由其带来的算力、AI infra(AI软件基础设施)等方面的创新和变化。

业界人士观察,今年很可能会是从移动互联网时代迈向智能时代的关键一年。过去从互联网转向移动互联网,大家一开始在手机上使用网页,后来iPhone开创了手机APP进行交互。而在智能时代,未来很可能不再是点开APP,而是直接弹出一个个AI Agent(人工智能代理),去实现交流互动。

“我们现在就在所谓智能时代的iPhone时刻前期,智能的iPhone时刻随时可能发生。”IDC中国副总裁周震刚做了一个比喻。

在这种背景下,国际数据公司(IDC)与浪潮信息在大会现场联合发布的《2023-2024年中国人工智能计算力发展评估报告》(以下简称报告)也受到不少关注。

01

大模型辐射面远比想象要丰富

中国企业对生成式AI的接受程度,可能已超出你的想象。比如在一些想象不到的行业和领域已经开始投入大模型。

近期,手机公司在大模型上动作频频,包括小米、vivo、OPPO、三星等在短短一个月内,接连亮出了10个以上的AI大模型,参数规模从十亿级、百亿级到1300亿不等。但你可能很难想象,手机背后的芯片公司,也在尝试引入大模型。

比如上海的一家手机芯片上市公司,尝试利用大模型解决传统客服问答系统智能程度不高的问题。过去,因为芯片品种有上千种,且涉及大量技术专有名词、参数信息,技术服务团队在本职工作外,需要投入大量时间帮助确认细节。而现在,他们通过大模型的语义理解和判断推理能力,解放一线技术工程师,实现降本提效。

生物医疗领域同样是对大模型探索较多的行业,有数据显示,今年以来,国内已发布近50款医疗大模型。医学科研、药物研发、智慧诊疗、医院管理等都是被探索的方向。但你可能很难想象,国内一些花卉研究所,正基于大模型打造花卉AI育种大模型。

汽车界对大模型的探索也不少,包括吉利、奇瑞、红旗、智己等多家车企都曾宣布接入大模型产品,大家都在争夺谁能首先在智能座舱、自动驾驶等场景实现大模型落地。就连摩托车公司也不甘寂寞。比如成立于1993年的国内摩托车龙头企业——隆鑫通用,正在利用大模型的能力,打造面向消费者的“AI骑行助理”,并试图探索大模型在摩托车发动机的生产质量管控、全地形车的智能化改造等方面的应用。

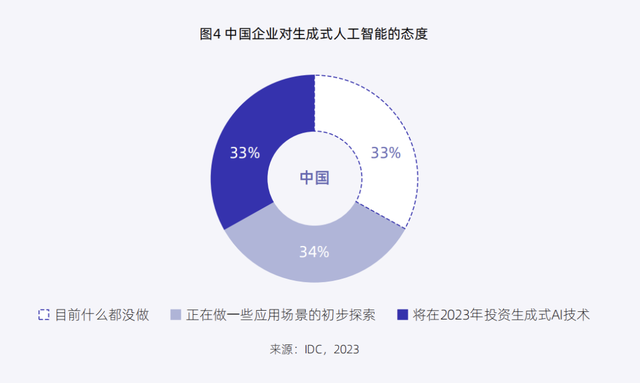

IDC和浪潮信息发布的《报告》,也从数据层面印证了这一点——67%的中国企业已经开始探索生成式AI在企业内的应用机会或进行相关资金投入。

“中国企业尤其认可生成式AI在加速决策、提高效率、优化用户和员工体验等维度带来的价值,并将在未来三年持续提高投入力度,超过七成企业增幅达到20%-40%。”IDC中国副总裁周震刚介绍。

当然,在这波大模型建设热潮中,拥有更多的先发优势和投入动力的,还是原先就在AI上积累更深、AI渗透度更高的行业。

可以看到,在2023年人工智能行业渗透度排名中,Top5的行业依次为互联网、电信、政府、金融和制造。交通、服务、教育等行业在人工智能领域的投资力度也可圈可点,分别位列第六至八名。

其中,高居首位的互联网行业,在最新的生成式AI热潮中,依然是大模型和AIGC技术应用和研发的主战场。李彦宏一度表示,百度要用大模型把全部产品重新做一遍,且“不是整合,也不是接入,是重做和重构。”

而渗透度排行榜上最大的“黑马”——电信行业,反超政府和金融,跃升至第二名。在最近一两个月,电信业加快了在大模型上的进程,三大运营商也都亮出各自“最新的基础大模型+多个行业大模型”。

至于“财大气粗”且一向对技术有着较高追求的金融行业,更是从今年初ChatGPT一火起来,就对大模型技术进行投入。

这一火爆,直接带来智能算力的“暴增”。IDC的数据显示,2023年,中国通用算力规模预计达到59.3EFLOPS,同比增长8.8%;智能算力预计达到414.1EFLOPS,同比增长59.3%,6.7倍于通用算力增速。

02

算力新挑战

大模型时代,“卖铲人”的生意先红火起来。

典型如英伟达,因手握大量GPU资源,今年以来,一直在“开挂式”大丰收,不仅年初在资本市场首次突破万亿美元市值,之后更是拿到了雪花般的订单,收获了真金白银。

最新财报显示,8月到10月的单季度内,英伟达总共向全球大量的数据中心,出售145.1亿美元的芯片,远高于去年同期的38亿美元,也高于市场预期的127亿美元,同比增长324%。

国内的“百模大战”,也为英伟达带去不少生意。2024财年第二财季财报会上,英伟达高管曾透露,英伟达数据中心业务收入的20%至25%都来自中国市场,已创下历史新高。

不止是底层芯片厂商,算力产业链上其他各个环节的提供商们也都尝到了不少红利。比如服务器端,《报告》显示,2023年上半年,中国人工智能服务器市场规模达到30亿美元,同比增长了55.4%,预计全年将达91亿美元,同比增长82.5%。

与此同时,由于大模型对计算能力和数据的高需求,2023年至2026年,全球用于运行生成式AI的服务器市场规模在整体人工智能服务器市场的占比将从11.9%增长到31.7%。

“今年的一个特殊情况是,大家抢卡比较厉害,导致服务器的支出增长非常快 。”IDC周震刚告诉数智前线,随着供需关系趋于平衡,这种高增速预计将在明年放缓,但鉴于算力需求持续上涨,中国AI服务器市场规模还将在未来五年以21.8%的年复合增长率持续增长。

机遇陡升的同时,这个市场也在面临一些新挑战。一方面,单芯片算力已经遇到瓶颈,提升空间有限;另一方面,算力依旧紧缺。这两点上,全球市场无一例外。

当然,中国市场的情况可能还要更严峻一点。一位资深人士告诉数智前线,国内市场今年几乎九成加速计算的能力都由英伟达所提供,仅一成由国产芯片厂商提供,算力短缺问题,依然待解。

此外,各行各业在进行大模型探索和应用的过程中,也存在各种意想不到的挑战和问题。比如,有企业在使用AI集群,对面向场景的AI大模型进行训练时,发现服务器中的CPU到GPU之间的通信带宽,和存储到服务器之间的通信带宽没法同时跑满,导致模型数据不能及时从存储读取,GPU空闲和训练性能低下。

如何在有限的算力下,更高效、低成本、少差错地进行大模型及生成式AI的应用和落地,已经成为许多企业都要面对的问题。

在此背景下,报告认为,国内有关智能算力供给能力的衡量标准正在加速演变——用户在获得算力服务的过程中,会更加以应用为导向进行综合考量,增加对于诸如单位时间可处理Token数量、可靠性、时延、训练时间和资金成本、数据集质量等指标的关注,而不再是仅考虑硬件性能。

这也要求算力供应商做出相应改变。《报告》指出,算力供应商需要“以应用为导向、系统为核心”,构建算力基础设施平台,提高算力利用率,提升诸如卡间互联、多节点间互联等水平,支持灵活稳定扩展和弹性容错,积极打造通用的人工智能软件和硬件平台,以先进的系统性能力满足市场的应用需求。

换句话说,与其过分关注单一芯片的性能强弱,不如根据人工智能业务场景需求,设计更具针对性的算力系统,实现整体性能最优。换一种思维,打破算力困境。

03

业界的新解法

面对算力市场的新机遇和新挑战,包括云厂商、服务器厂商等在内的诸多算力供应商,正在快速反应。

“基本上几个大的云服务商,都已经意识到大模型时代,智能计算的经营模式会和过去传统的云计算模式发生比较大的改变,因此都在重新去组织自己的计算能力。”周震刚告诉数智前线。

比如,百度云、华为云、阿里云都表示,将通过从底层算力到AI平台再到模型服务的全栈技术创新,升级云计算体系。MaaS(Model as a Service)已成为云厂商的服务体系的重要一层。

而在更底层的服务器端,同样带来了服务需求的变化,甚至需要厂商的转身。“我们认为,应该从算力系统、AI软件基础设施(AI infra)、算法模型和产业生态4个方面来进行综合考量,加速智能产业的落地。”浪潮信息高级副总裁刘军表示。

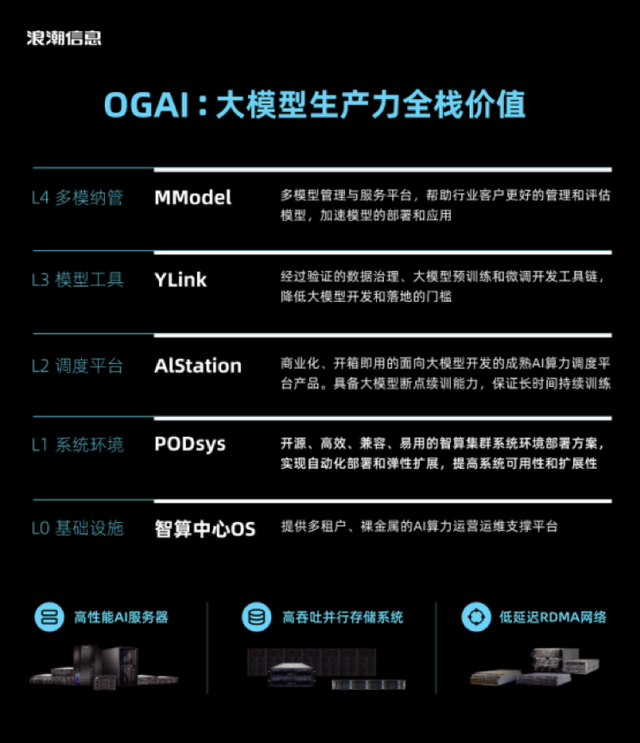

业界观察,服务器企业也在加速AI infra的进展,这是一个新动向。浪潮信息在今年8月推出了大模型智算软件栈OGAI“元脑生智”(Open GenAI Infra)。

它包括L0的基础设施层(智算中心OS)、L1的系统环境层(PODsys)、L2的调度平台层(AIStation),L3的模型工具层(YLink)和L4的多模纳管层(MModel)。各层对应不同的应用场景,且分层解耦,用户需要哪些工具,就能调用哪些。

这也是算力供应商“以应用为导向、系统为核心”的典型例证。类似的还有百度在千帆大模型平台上提供的工具链。腾讯、阿里等也都有相应服务出来。各家大厂的普遍思路是,持续更新迭代自己大模型的能力,同时又为大模型的训练和推理,提供训推经验、数据、计算、存储、网络等涉及方方面面的全套工具链和服务。

另外,在算力系统层面,打造开放多元的AI算力平台,解决目前多元算力共存的问题,也是未来几年产业大趋势。如浪潮信息发布的G7算力平台,采用开放多元的架构设计,支持最广泛的通用处理器和加速芯片,同时将整个集群的性能加速比提升至超过90%,从而保障更大规模的集群扩展性能。

大模型的浪潮还在继续,移动互联网时代迈向智能时代的大门即将打开,在这个关键转折点上,反应速度的快慢往往决定了谁能更快抢得先机。周震刚建议,用户应该要尽早去拥抱这个趋势,供应商也应尽早适应和跟上算力市场的改变。

鲁公网安备37020202000738号

鲁公网安备37020202000738号